Metoda wąskiego gardła informacji

Metoda wąskiego gardła informacji to technika w teorii informacji wprowadzona przez Naftalego Tishby'ego , Fernando C. Pereirę i Williama Bialka . Jest przeznaczony do znajdowania najlepszego kompromisu między dokładnością a złożonością ( kompresja ) podczas podsumowywania (np. grupowania ) zmiennej losowej X , biorąc pod uwagę łączny rozkład prawdopodobieństwa p(X,Y) między X a obserwowaną istotną zmienną Y - i sam opisał jako dostarczający „zaskakująco bogatych ram do omawiania różnych problemów związanych z przetwarzaniem i uczeniem się sygnałów” .

Zastosowania obejmują grupowanie dystrybucyjne i redukcję wymiarów , a ostatnio zasugerowano, że jest to teoretyczna podstawa głębokiego uczenia się . Uogólnił klasyczne pojęcie minimalnych wystarczających statystyk ze statystyk parametrycznych na dowolne rozkłady, niekoniecznie wykładnicze. Czyni to poprzez złagodzenie warunku wystarczalności, aby uchwycić pewien ułamek wzajemnej informacji z odpowiednią zmienną Y .

Wąskie gardło informacji można również postrzegać jako problem zniekształcenia szybkości , z funkcją zniekształcenia, która mierzy, jak dobrze prognozuje się Y na podstawie skompresowanej reprezentacji T w porównaniu z jej bezpośrednią prognozą na podstawie X . Ta interpretacja zapewnia ogólny algorytm iteracyjny do rozwiązywania kompromisu związanego z wąskim gardłem informacyjnym i obliczania krzywej informacyjnej z rozkładu p(X,Y) .

Niech skompresowana reprezentacja będzie dana przez zmienną losową . Algorytm minimalizuje następujący funkcjonał w odniesieniu do rozkładu warunkowego: :

gdzie i są wzajemnymi informacjami i i odpowiednio i _ _ _

Minimalne wystarczające statystyki

Równania samozgodne

Teoria uczenia się

Przejścia fazowe

Teoria informacji głębokiego uczenia się

Teoria wąskich gardeł informacji jest ostatnio wykorzystywana do badania głębokich sieci neuronowych (DNN). Rozważ wejściową i wyjściową DNN i niech będzie . Shwartz-Ziv i Tishby zaproponowali kompromis między miarami wzajemnej i . W odpowiednio _ wejście i wyjście. Przypuszczali, że proces szkolenia DNN składa się z dwóch oddzielnych faz; 1) początkowa faza dopasowania, w której wzrasta i 2) kolejna faza kompresji, w której maleje. Saxe i in. w odparli twierdzenie Shwartz-Ziv i Tishby, stwierdzając, że to zjawisko kompresji w DNN nie jest kompleksowe i zależy od konkretnej funkcji aktywacji. W szczególności twierdzili, że kompresja nie występuje w przypadku funkcji aktywacji ReLu. Shwartz-Ziv i Tishby zakwestionowali te twierdzenia, argumentując, że Saxe i in. nie zaobserwowali kompresji z powodu słabych szacunków wzajemnych informacji. Ostatnio Noshad i in. wykorzystali optymalny estymator wzajemnych informacji do zbadania tej kontrowersji, zauważając, że optymalny estymator oparty na hash ujawnia zjawisko kompresji w szerszym zakresie sieci z aktywacjami ReLu i maxpooling. Z drugiej strony, ostatnio Goldfeld i in. argumentowali, że obserwowana kompresja jest wynikiem zjawisk geometrycznych, a nie zjawisk teorii informacji, pogląd ten podzielano również w .

Wariacyjne wąskie gardło

Wąskie gardło Gaussa

Wąskie gardło Gaussa, czyli zastosowanie podejścia informacyjnego wąskiego gardła do zmiennych Gaussa, prowadzi do rozwiązań związanych z kanoniczną analizą korelacji. Załóżmy, że są wspólnie wielowymiarowymi zerowymi średnimi wektorami normalnymi z kowariancjami i jest skompresowaną wersją które muszą utrzymywać określoną wartość wzajemnych informacji z . Można wykazać, że optymalny jest wektorem normalnym składającym się z liniowych kombinacji elementów T ma ortogonalne rzędy.

Macierz projekcji rzeczywistości zawiera wiersze wybrane z ważonych lewych wektorów własnych rozkładu macierzy na wartości osobliwe (ogólnie asymetryczne)

Zdefiniuj rozkład na wartości osobliwe

i wartości krytyczne

wtedy liczba aktywnych wektorów własnych w rzucie lub kolejność aproksymacji jest podana przez

I w końcu dostajemy

W których wagi są podane przez

gdzie

Zastosowanie gaussowskiego wąskiego gardła informacyjnego do szeregów czasowych (procesów) daje rozwiązania związane z optymalnym kodowaniem predykcyjnym. Ta procedura jest formalnie równoważna z liniową analizą cech w zwolnionym tempie.

Optymalne struktury czasowe w liniowych układach dynamicznych można ujawnić w tak zwanym wąskim gardle informacyjnym przeszłości i przyszłości, czyli zastosowaniu metody wąskiego gardła do niegaussowskich próbkowanych danych. Koncepcja, traktowana przez Creutzig, Tishby i in., nie jest pozbawiona komplikacji, ponieważ w ćwiczeniu składają się na nią dwie niezależne fazy: po pierwsze oszacowanie gęstości prawdopodobieństwa nieznanego macierzystego, z którego pobierane są próbki danych, a po drugie wykorzystanie tych gęstości w teoretyczne ramy informacyjne wąskiego gardła.

Oszacowanie gęstości

oszacować gęstość prawdopodobieństwa w punktach próbkowania Jest to dobrze znany problem z wieloma rozwiązaniami opisanymi przez Silvermana . W niniejszej metodzie wspólne prawdopodobieństwa próbek są znajdowane przy użyciu macierzy przejść Markowa , co ma pewną matematyczną synergię z samą metodą wąskiego gardła.

Dowolnie rosnąca metryka odległości między wszystkimi parami próbek a macierzą odległości wynosi ja , . Wtedy prawdopodobieństwa przejść między parami próbek dla pewnego musi być obliczone. Traktując próbki jako wersję jako macierz prawdopodobieństwa przejścia stanu Markowa, wektor prawdopodobieństw „stanów” po uwarunkowany początkowym stan jest . Wektor prawdopodobieństwa równowagi podany w zwykły sposób przez dominujący wektor własny macierzy, który jest niezależny od wektora inicjującego . Ta metoda przejścia Markowa ustala prawdopodobieństwo w punktach próbkowania, które uważa się za proporcjonalne do tamtejszych gęstości prawdopodobieństw.

Inne interpretacje wykorzystania wartości własnych macierzy odległości w Silverman's Density Estimation for Statistics and Data Analysis .

Klastry

W poniższym przykładzie miękkiego klastrowania wektor odniesienia zakłada jest znane Klaster miękki w próbkach danych . Tishby i in. przedstawił następujący iteracyjny zestaw równań do wyznaczania klastrów, które ostatecznie są uogólnieniem algorytmu Blahuta-Arimoto , opracowanego w teorii zniekształceń szybkości . Wydaje się, że zastosowanie tego typu algorytmu w sieciach neuronowych wywodzi się z argumentów dotyczących entropii wynikających z zastosowania rozkładów Gibbsa w wyżarzaniu deterministycznym.

Funkcja każdej linii iteracji rozwija się jako

Linia 1: Jest to zestaw prawdopodobieństw warunkowych o wartościach macierzowych

Kullbacka – Leiblera między wektorami wygenerowanymi przez przykładowe dane a wektorami wygenerowanymi przez zredukowane informacje proxy stosowane do oceny wierności skompresowanego wektora w odniesieniu do danych referencyjnych (lub kategorycznych) równaniem wąskiego gardła. jest rozbieżnością Kullbacka-Leiblera między rozkładami

i normalizacją skalarną Ważenie ujemnym wykładnikiem odległości oznacza, że wcześniejsze prawdopodobieństwa skupień są zmniejszane w wierszu 1, gdy dywergencja Kullbacka-Leiblera jest duża, a zatem prawdopodobieństwo pomyślnych skupień wzrasta, podczas gdy nieudane zanikają.

Wiersz 2: Drugi zbiór prawdopodobieństw warunkowych o wartościach macierzowych. Zgodnie z definicją

gdzie tożsamości Bayesa są używane.

Linia 3: ta linia znajduje krańcowy rozkład klastrów do

To standardowy wynik.

Dalsze dane wejściowe do algorytmu to krańcowy rozkład próbki, który został już określony przez dominujący wektor własny i rozbieżności Kullbacka – Leiblera o wartości funkcjonować

wyprowadzone z odstępów między próbkami i prawdopodobieństw przejścia.

Macierz może być inicjowana losowo lub z rozsądnym domysłem, podczas gdy macierz nie wymaga żadnych wcześniejszych wartości. Chociaż algorytm jest zbieżny, może istnieć wiele minimów, które należy rozwiązać.

Definiowanie konturów decyzyjnych

Aby sklasyfikować nową próbkę zewnętrzną do zbioru treningowego poprzednia metryka odległości znajduje prawdopodobieństwa przejścia między próbki w , operatorname normalizacja. Po drugie, zastosuj ostatnie dwa wiersze algorytmu 3-wierszowego, aby uzyskać prawdopodobieństwa klastrów i kategorii warunkowych.

Wreszcie

Parametr musi być nadzorowany, ponieważ gdy jest zwiększany od zera, rosnąca liczba cech w przestrzeni prawdopodobieństwa kategorii skupia się na pewnych krytycznych progach

Przykład

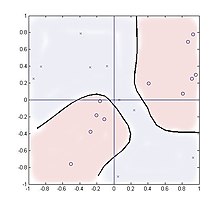

Poniższy przypadek analizuje grupowanie w mnożniku czterokwadrantowym z kategoriami generowanymi . Ta funkcja ma dwa przestrzennie oddzielone klastry dla każdej kategorii, co pokazuje, że metoda może obsłużyć takie rozkłady.

Pobiera się 20 próbek, równomiernie rozmieszczonych na kwadracie . Liczba klastrów używanych poza liczbą kategorii, w tym przypadku dwóch, ma niewielki wpływ na wydajność, a wyniki są pokazane dla dwóch klastrów przy użyciu parametrów .

Funkcja odległości to ja podczas gdy rozkład warunkowy to 2 × 20 matryca

i zero gdzie indziej.

Sumowanie w wierszu 2 zawiera tylko dwie wartości reprezentujące wartości treningowe +1 lub -1, ale mimo to działa dobrze. Rysunek przedstawia położenie dwudziestu próbek, przy czym „0” oznacza Y = 1, a „x” oznacza Y = −1. Pokazano kontur na poziomie ilorazu wiarygodności jedności,

nowa próbka na kwadracie. Teoretycznie kontur powinien być wyrównany ze v ale dla tak małych liczb próbek zamiast tego podążali za fałszywymi skupieniami punktów próbkowania.

Analogie sieci neuronowych/logiki rozmytej

Algorytm ten jest nieco analogiczny do sieci neuronowej z pojedynczą warstwą ukrytą. Węzły wewnętrzne są reprezentowane przez klastry, i druga warstwa wag sieciowych to prawdopodobieństwa warunkowe. i odpowiednio. Jednak w przeciwieństwie do standardowej sieci neuronowej algorytm opiera się całkowicie na prawdopodobieństwach jako danych wejściowych, a nie na samych wartościach próbek, podczas gdy wartości wewnętrzne i wyjściowe są warunkowymi rozkładami gęstości prawdopodobieństwa. Funkcje nieliniowe są zawarte w metryce odległości funkcjach wpływających / promieniowych funkcjach bazowych przejścia zamiast funkcji sigmoidalnych.

, często w dziesiątkach iteracji, i zmieniając , λ i } liczności klastrów, można osiągnąć różne poziomy skupienia się na cechach.

Statystyczna definicja miękkiego klastrowania z rozmytej .

Rozszerzenia

Ciekawym rozszerzeniem jest przypadek wąskiego gardła informacyjnego z informacjami pobocznymi. Tutaj maksymalizuje się informacje o jednej zmiennej docelowej i minimalizuje o innej, ucząc się reprezentacji, która zawiera informacje o wybranych aspektach danych. Formalnie

Bibliografia

- Weiss, Y. (1999), „Segmentacja za pomocą wektorów własnych: jednoczący widok”, Proceedings IEEE International Conference on Computer Vision (PDF) , s. 975–982

- P. Harremoës i N. Tishby „Ponowna wizyta w wąskim gardle informacji lub jak wybrać dobrą miarę zniekształceń”. W materiałach Międzynarodowego Sympozjum Teorii Informacji (ISIT) 2007

![{\displaystyle A=[w_{1}U_{1},\dots ,w_{M}U_{M}]^{T}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/2452fbcc21043b263e6427f67922d2f3794ed0da)

![{\displaystyle {\begin{cases}p(c|x)=Kp(c)\exp {\Big (}-\beta \,D^{KL}{\Big [}p(y|x)\,||\,p(y|c){\Big ]}{\Big )}\\p(y|c)=\textstyle \sum _{x}p(y|x)p(c|x)p(x){\big /}p(c)\\p(c)=\textstyle \sum _{x}p(c|x)p(x)\\\end{cases}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/f9b29faec038fbb2da40e4ba191be82a2fd73760)

![{\displaystyle A_{i,j}=p(c_{i}|x_{j})=Kp(c_{i})\exp {\Big (}-\beta \,D^{KL}{\Big [}p(y|x_{j})\,||\,p(y|c_{i}){\Big ]}{\Big )}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/6f287e6823ebfa39f521fe993a875691ff778fdc)

![{\displaystyle D_{i,j}^{KL}=D^{KL}{\Big [}p(y|x_{j})\,||\,p(y|c_{i}){\Big ]}{\Big )}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3589cf4b3fe5eeb605388c57058dfb558db84576)

![{\displaystyle [-1,1]^{2}\,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a4376d6f93ed4561418bc9e39a4992b97da77bc0)