Lasso (statystyki)

W statystyce i uczeniu maszynowym lasso ( operator najmniejszego bezwzględnego skurczu i selekcji ; także Lasso lub LASSO ) to metoda analizy regresji , która przeprowadza zarówno selekcję zmiennych , jak i regularyzację w celu zwiększenia dokładności przewidywania i możliwości interpretacji wynikowego modelu statystycznego . Został pierwotnie wprowadzony w geofizyce , a później przez Roberta Tibshiraniego , który ukuł ten termin.

Lasso został pierwotnie opracowany dla modeli regresji liniowej . Ten prosty przypadek ujawnia znaczną ilość informacji o estymatorze. Obejmują one jego związek z regresją grzbietową i wyborem najlepszego podzbioru oraz powiązania między oszacowaniami współczynników lassa a tak zwanym miękkim progowaniem. Ujawnia również, że (podobnie jak w przypadku standardowej regresji liniowej) oszacowania współczynników nie muszą być unikalne, jeśli współzmienne są współliniowe .

Chociaż pierwotnie zdefiniowano ją dla regresji liniowej, regularyzacja lassem może być łatwo rozszerzona na inne modele statystyczne, w tym uogólnione modele liniowe , uogólnione równania estymacji , modele proporcjonalnego hazardu i M-estymatory . Zdolność Lasso do przeprowadzania selekcji podzbiorów opiera się na formie ograniczenia i ma różne interpretacje, w tym pod względem geometrii , statystyki bayesowskiej i analizy wypukłej .

LASSO jest ściśle powiązany z odszumianiem pościgu za bazą .

Historia

Lasso zostało wprowadzone w celu poprawy dokładności przewidywania i interpretowalności modeli regresji. Wybiera zredukowany zestaw znanych współzmiennych do wykorzystania w modelu.

Lasso został opracowany niezależnie w literaturze geofizycznej w 1986 roku na podstawie wcześniejszych prac, w których zastosowano zarówno za , jak i penalizację współczynników Statystyk Robert Tibshirani niezależnie odkrył go na nowo i spopularyzował w 1996 roku na podstawie nieujemnej garoty Breimana .

Przed lassem najczęściej stosowaną metodą wyboru współzmiennych była selekcja krokowa . Takie podejście poprawia dokładność przewidywania tylko w niektórych przypadkach, na przykład gdy tylko kilka współzmiennych ma silny związek z wynikiem. Jednak w innych przypadkach może zwiększyć błąd prognozy.

W tamtym czasie regresja grzbietu była najpopularniejszą techniką poprawiania dokładności prognoz. Regresja grzbietowa poprawia błąd predykcji, zmniejszając sumę kwadratów współczynników regresji do wartości mniejszej niż ustalona wartość w celu zmniejszenia nadmiernego dopasowania , ale nie przeprowadza selekcji współzmiennych, a zatem nie ułatwia interpretacji modelu.

Lasso osiąga oba te cele, wymuszając, aby suma wartości bezwzględnych współczynników regresji była mniejsza niż stała wartość, co wymusza na niektórych współczynnikach zero, wykluczając je z wpływu na prognozy. Pomysł ten jest podobny do regresji grzbietowej, która również zmniejsza rozmiar współczynników; jednak regresja grzbietowa nie ustawia współczynników na zero (a zatem nie przeprowadza selekcji zmiennych ).

Podstawowa forma

Najmniejsze kwadraty

Rozważmy próbę składającą się z N przypadków, z których każdy składa się z p współzmiennych i pojedynczego wyniku. Niech będzie wynikiem i będzie wektorem współzmiennym dla i- tego przypadku. Wtedy celem lassa jest rozwiązanie

Tutaj jest stałym współczynnikiem, jest wektorem współczynników, a jest parametrem swobodnym, który określa stopień uregulowania.

będzie macierzą współzmiennych, tak że i to i -ty wiersz , wyrażenie można zapisać bardziej zwięźle jako X {\ displaystyle X}

gdzie } jest normą .

Oznaczając średnią skalarną punktów danych przez przez i średnią zmiennych odpowiedzi przez x , wynikowe oszacowanie dla to że

dlatego standardem jest praca ze zmiennymi, dla których średnia wynosi zero. Ponadto współzmienne są zwykle standaryzowane , aby rozwiązanie nie zależało od skali pomiaru.

Przepisanie może być pomocne

w tak zwanej postaci Lagrange'a

dokładny związek między od danych

Współzmienne ortonormalne

Można teraz rozważyć niektóre podstawowe właściwości estymatora lassa.

Zakładając najpierw, że współzmienne są ortonormalne , tak że δ to delta Kroneckera równoważnie , za pomocą metod podgradientowych ,

jest określany jako operator progowania miękkiego , ponieważ tłumaczy wartości w kierunku zera (czyniąc je dokładnie zerowymi, jeśli są wystarczająco małe) zamiast ustawiania mniejszych wartości na zero i pozostawiania większych nietkniętych jako S α {\ displaystyle S _ {\ alfa}} twardy operator progowania , często oznaczany to

W regresji grzbietowej celem jest minimalizacja

Używając wzoru regresji grzbietu: :

jednolity współczynnik nie ustawia żadnych [ potrzebne źródło ] .

Można to również porównać do regresji z wyborem najlepszego podzbioru , w której celem jest minimalizacja

gdzie normą która jest zdefiniowana jako jeśli dokładnie m składników z jest niezerowych. W tym przypadku można to wykazać

gdzie jest tak zwaną twardą funkcją progową i wskaźnika (jest to 1, jeśli jej argument jest prawdziwy, a 0 w przeciwnym

Dlatego oszacowania lassa mają wspólne cechy zarówno regresji grzbietowej, jak i regresji wyboru najlepszego podzbioru, ponieważ oba zmniejszają wielkość wszystkich współczynników, takich jak regresja grzbietowa, i ustawiają niektóre z nich na zero, jak w przypadku wyboru najlepszego podzbioru. Dodatkowo, podczas gdy regresja grzbietowa skaluje wszystkie współczynniki o stały współczynnik, lasso zamiast tego tłumaczy współczynniki w kierunku zera o stałą wartość i ustawia je na zero, jeśli osiągną tę wartość.

W jednym szczególnym przypadku dwie zmienne towarzyszące, powiedzmy j i k , są identyczne dla każdej obserwacji, więc , gdzie . Następnie wartości i , które minimalizują funkcję celu lassa, nie są jednoznacznie określone. W rzeczywistości, jeśli jakiś w którym , to jeśli zastępując przez Displaystyle przez , zachowując wszystkie pozostałe naprawiony, daje nowe rozwiązanie, więc funkcja celu lasso ma wtedy kontinuum ważnych minimalizatorów. Aby rozwiązać ten problem, zaprojektowano kilka wariantów lassa, w tym regularyzację elastycznej sieci .

Formularz ogólny

Regularyzację Lasso można rozszerzyć na inne funkcje celu, takie jak te dla uogólnionych modeli liniowych , uogólnionych równań estymujących , modeli proporcjonalnego hazardu i M-estymatorów . Biorąc pod uwagę funkcję celu

rozwiązaniem estymatora jest uregulowana lassem wersja estymatora

gdzie tylko jest karane, podczas gdy przyjąć dowolną dozwoloną wartość, tak jak nie było karane w podstawowym przypadku

Interpretacje

Interpretacja geometryczna

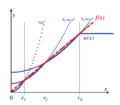

Lasso może ustawić współczynniki na zero, podczas gdy powierzchownie podobna regresja grzbietu nie. Wynika to z różnicy w kształcie ich granic ograniczających. Zarówno regresję lasso, jak i regresję grzbietową można interpretować jako minimalizację tej samej funkcji celu

ale w odniesieniu do różnych ograniczeń: dla lasso i dla grzbietu. Rysunek pokazuje, że region ograniczeń zdefiniowany przez jest kwadratem obróconym tak, że jego rogi leżą na osiach (ogólnie cross ) , podczas gdy region zdefiniowany przez norma to okrąg (ogólnie n -sfera ), który jest niezmienny obrotowo i dlatego nie ma rogów. Jak widać na rysunku, wypukły obiekt, który leży stycznie do granicy, taki jak pokazana linia, prawdopodobnie napotka róg (lub odpowiednik o wyższych wymiarach) hipersześcianu, dla którego niektóre składniki β {\ są identycznie zerowe, podczas gdy w przypadku n -sfery punkty na granicy, dla których niektóre składowe od innych, a wypukły przedmiot nie ma większego prawdopodobieństwa zetknięcia się z punktem, w którym niektóre składniki są równe zeru niż jeden, dla którego żaden z nich nie jest.

Ułatwienie interpretacji λ dzięki kompromisowi między dokładnością a prostotą

aby łatwo było przewidzieć i wpłynąć na stopień skurczu związany z daną . Zakłada się, że z wynikami Z i że ). Niech hipotetyczne współczynniki regresji i niech zapoznaj się ze zwykłymi rozwiązaniami najmniejszych kwadratów zoptymalizowanymi pod kątem danych. Następnie możemy zdefiniować Lagrange'a jako kompromis między dokładnością w próbce rozwiązań zoptymalizowanych pod kątem danych a prostotą trzymania się hipotetycznych wartości. To skutkuje

gdzie jest określony poniżej. Pierwszy ułamek reprezentuje względną dokładność, drugi ułamek względną prostotę, a nimi.

można zdefiniować, określając jako , czyli maksymalna wielkość odchylenia od , gdy . Zakładając, że zdefiniować za pomocą :

Jeśli , używane jest zwykłe rozwiązanie najmniejszych kwadratów (OLS). Hipotetyczna wartość { \ . Ponadto, jeśli , to reprezentuje proporcjonalny wpływ . Innymi słowy, minimalny wpływ hipotetycznej wartości w stosunku do rozwiązania OLS zoptymalizowanego pod

Jeśli -norm jest używany do karania odchyleń od zera przy pojedynczym regresorze, ścieżka rozwiązania jest określona przez

. Jak , porusza się w kierunku punktu kiedy bliskie zeru ale w przeciwieństwie do 2 { jeśli ).

. może odbiegać od regresora w dokładność. Pierwszy,

Wartość jeśli zamiast hipotetycznych wartości zostaną użyte . Indywidualny wkład odejścia od każdej hipotezy można obliczyć za pomocą macierzy x

gdzie . Jeśli , gdy oblicza się suma elementów ukośnych do . Przekątna niż 0 lub, rzadziej, większe niż 1. Jeśli regresory są nieskorelowane, to po element przekątny odpowiada wartości między } a

Przeskalowaną wersję lassa adaptacyjnego można uzyskać ustawiając . Jeśli regresory są nieskorelowane, moment { \ . Zakładając dla wygody, że jest wektorem zer,

to, że jeśli regresory są nieskorelowane, ponownie określa minimalny wpływ . Nawet jeśli regresory są skorelowane, po raz pierwszy aktywowany parametr regresji, gdy jest równy najwyższemu elementowi ukośnemu .

Wyniki te można porównać z przeskalowaną wersją lassa, definiując , czyli średnie bezwzględne odchylenie od od . Zakładając, że regresory są nieskorelowane, to moment aktywacji regresora jest określony przez

p moment aktywacji jest ponownie podany przez . Jeśli i podzbiorem odpowiednich parametrów są w równym stopniu odpowiedzialne za idealne dopasowanie wtedy ten podzbiór jest aktywowany przy wartości . Moment aktywacji odpowiedniego regresora jest wtedy równy . Innymi słowy, włączenie nieistotnych regresorów opóźnia moment aktywacji odpowiednich regresorów przez to przeskalowane lasso. Lasso adaptacyjne i lasso to szczególne przypadki estymatora „1ASTc”. Ten ostatni grupuje parametry tylko wtedy, gdy bezwzględna korelacja między regresorami jest większa niż wartość określona przez użytkownika.

Interpretacja bayesowska

Tak jak regresję grzbietową można interpretować jako regresję liniową, której współczynnikom przypisano normalne rozkłady a priori , tak lasso można interpretować jako regresję liniową, dla której współczynniki mają rozkłady a priori Laplace'a . Rozkład Laplace'a ma ostry szczyt przy zerze (jego pierwsza pochodna jest nieciągła przy zerze) i koncentruje swoją masę prawdopodobieństwa bliżej zera niż rozkład normalny. Zapewnia to alternatywne wyjaśnienie, dlaczego lasso ma tendencję do ustawiania niektórych współczynników na zero, podczas gdy regresja grzbietu nie.

Interpretacja relaksacji wypukłej

Lasso można również postrzegać jako wypukłą relaksację problemu regresji wyboru najlepszego podzbioru, polegającego na znalezieniu podzbioru współzmiennych, najmniejszą wartość funkcji celu dla pewnego , gdzie n jest całkowitą liczbą współzmiennych. Norma „ granicznym przypadkiem " normy", postaci dla od nie jest wypukła dla , więc nierówność trójkąta nie zachodzi). Dlatego, ponieważ p = 1 jest najmniejszą wartością, dla której najlepszym wypukłym przybliżeniem do najlepszy problem wyboru podzbioru, ponieważ region zdefiniowany przez jest otoczką wypukłą regionu zdefiniowanego przez dla .

Uogólnienia

Warianty lasso zostały stworzone, aby zaradzić ograniczeniom oryginalnej techniki i uczynić metodę bardziej przydatną do określonych problemów. Prawie wszystkie z nich koncentrują się na poszanowaniu lub wykorzystaniu zależności między współzmiennymi.

Elastyczna regularyzacja sieci dodaje dodatkową karę podobną do regresji grzbietowej, która poprawia wydajność, gdy liczba predyktorów jest większa niż wielkość próby, pozwala metodzie wybrać razem silnie skorelowane zmienne i poprawia ogólną dokładność predykcji.

Lasso grupowe umożliwia wybranie grup powiązanych zmiennych towarzyszących jako pojedynczej jednostki, co może być przydatne w ustawieniach, w których nie ma sensu uwzględnianie niektórych zmiennych towarzyszących bez innych. Dalsze rozszerzenia lassa grupowego wykonują selekcję zmiennych w obrębie poszczególnych grup (rzadkie lasso grupowe) i umożliwiają nakładanie się grup (lasso grupowe nakładania się).

Połączone lasso może uwzględniać przestrzenną lub czasową charakterystykę problemu, dając oszacowania, które lepiej pasują do struktury systemu. Modele uregulowane lasso można dopasować przy użyciu technik, w tym metod subgradientowych , regresji najmniejszych kątów (LARS) i metod proksymalnych gradientów . Określenie optymalnej wartości parametru regularyzacji jest ważną częścią zapewnienia dobrego działania modelu; jest zwykle wybierany za pomocą walidacji krzyżowej .

Elastyczna siatka

W 2005 roku Zou i Hastie wprowadzili elastyczną siatkę . Kiedy p > n (liczba współzmiennych jest większa niż wielkość próby), lasso może wybrać tylko n współzmiennych (nawet jeśli więcej jest powiązanych z wynikiem) i ma tendencję do wybierania jednej współzmiennej z dowolnego zestawu wysoce skorelowanych współzmiennych. Dodatkowo, nawet gdy n > p , regresja grzbietu zwykle działa lepiej, biorąc pod uwagę silnie skorelowane zmienne towarzyszące.

Elastyczna siatka rozciąga lasso, dodając dodatkowy termin kary, dając

co jest równoważne rozwiązaniu

Problem ten można zapisać w prostej formie lassa

pozwalać

- , ,

β , co daje, gdy współzmienne są ortogonalne względem siebie

Tak więc wynik kary za siatkę elastyczną jest kombinacją efektów kar za lasso i kar za grzbiet.

Wracając do przypadku ogólnego, fakt, że funkcja kary jest teraz ściśle wypukła oznacza, że jeśli , , co jest zmianą w stosunku do lassa. Ogólnie rzecz biorąc, jeśli

jest przykładową macierzą korelacji, ponieważ są znormalizowane

Dlatego wysoce skorelowane zmienne towarzyszące mają zwykle podobne współczynniki regresji, przy czym stopień podobieństwa zależy zarówno od jak i , co różni się od lassa. Zjawisko to, w którym silnie skorelowane współzmienne mają podobne współczynniki regresji, nazywane jest efektem grupowania. Grupowanie jest pożądane, ponieważ w zastosowaniach takich jak wiązanie genów z chorobą preferowane jest znalezienie wszystkich powiązanych zmiennych towarzyszących, zamiast wybierania jednej z każdego zestawu skorelowanych zmiennych towarzyszących, jak często robi to lasso. Ponadto wybranie tylko jednego z każdej grupy zwykle skutkuje zwiększonym błędem prognozy, ponieważ model jest mniej niezawodny (dlatego regresja grzbietu często przewyższa lasso).

Lasso grupowe

W 2006 roku Yuan i Lin wprowadzili lasso grupowe, aby umożliwić wspólne wybieranie predefiniowanych grup współzmiennych do lub z modelu. Jest to przydatne w wielu ustawieniach, być może najbardziej oczywiste, gdy zmienna kategorialna jest zakodowana jako zbiór współzmiennych binarnych. W takim przypadku grupowe lasso może zapewnić, że wszystkie zmienne kodujące współzmienną jakościową zostaną razem uwzględnione lub wykluczone. Innym środowiskiem, w którym grupowanie jest naturalne, są badania biologiczne. Ponieważ geny i białka często leżą w znanych szlakach, to, które szlaki są powiązane z wynikiem, może być bardziej znaczące niż to, czy poszczególne geny są. Funkcja celu dla lassa grupowego jest naturalnym uogólnieniem standardowego celu lassa

gdzie macierz projektu i wektor współzmiennych zastąpione zbiorem macierzy projektu i wektorów współzmiennych , po jednym dla każdej z grup J. Dodatkowo, termin kary teraz sumą norm określonych przez dodatnio określone macierze. . Jeśli każda współzmienna jest w swojej własnej grupie i to sprowadza się to do standardowego lassa, podczas gdy jeśli jest tylko jedna grupa i , redukuje się do regresji grzbietu. Ponieważ kara zmniejsza się do normą w podprzestrzeniach zdefiniowanych przez każdą grupę, nie może wybrać tylko niektórych współzmiennych z grupy, tak jak nie może tego zrobić regresja grzbietowa. Jednakże, ponieważ kara jest sumą różnych norm podprzestrzennych, jak w standardowym lasso, ograniczenie ma pewne punkty niezróżnicowane, które odpowiadają niektórym podprzestrzeniom identycznym zeru. Dlatego może ustawić wektory współczynników odpowiadające niektórym podprzestrzeniom na zero, podczas gdy inne tylko zmniejszają. Możliwe jest jednak rozszerzenie lassa grupowego do tak zwanego rzadkiego lassa grupowego, które może wybierać poszczególne zmienne towarzyszące w grupie, dodając dodatkowe kara dla każdej podprzestrzeni grupy. Inne rozszerzenie, grupowe lasso z nakładaniem się, umożliwia współdzielenie współzmiennych między grupami, np. jeśli gen miałby wystąpić w dwóch szlakach.

Połączone lasso

W niektórych przypadkach badane zjawisko może mieć ważną strukturę przestrzenną lub czasową, którą należy wziąć pod uwagę podczas analizy, na przykład szeregi czasowe lub dane obrazowe. W 2005 roku Tibshirani i współpracownicy wprowadzili połączone lasso, aby rozszerzyć użycie lassa na tego typu dane. Skondensowana funkcja celu lassa to

Pierwszym ograniczeniem jest ograniczenie lassa, podczas gdy drugie bezpośrednio karze duże zmiany w odniesieniu do struktury czasowej lub przestrzennej, co wymusza płynną zmianę współczynników w celu odzwierciedlenia podstawowej logiki systemu. Klastrowe lasso to uogólnienie połączonego lassa, które identyfikuje i grupuje odpowiednie zmienne towarzyszące na podstawie ich efektów (współczynników). Podstawową ideą jest karanie różnic między współczynnikami, tak aby niezerowe skupiały się. Można to modelować za pomocą następującej regularyzacji:

W przeciwieństwie do tego, zmienne można grupować w wysoce skorelowane grupy, a następnie z każdego skupienia można wyodrębnić pojedynczą reprezentatywną współzmienną.

Istnieją algorytmy, które rozwiązują problem połączonego lassa i niektóre jego uogólnienia. Algorytmy mogą rozwiązać go dokładnie w skończonej liczbie operacji.

Quasi-normy i regresja pomostowa

norms ( i połączone lasso konstruują funkcje karne z (z wagami, jeśli to Regresja pomostowa wykorzystuje ogólne quasinormy ( ). For example, for p =1/2 odpowiednikiem celu lassa w postaci Lagrange'a jest rozwiązanie

Gdzie

się, że ułamkowe quasi-normy wyników w analizie danych, zarówno teoretycznie, jak empirycznie Brak wypukłości tych quasi-norm komplikuje problem optymalizacji. Aby rozwiązać ten problem, opracowano i wdrożono procedurę minimalizacji oczekiwań w celu minimalizacji funkcji

gdzie jest dowolną wklęsłą monotonicznie rosnącą funkcją (na przykład karę lasso i / kara).

Wydajny algorytm minimalizacji opiera się na kwadratowej aproksymacji subkwadratowego wzrostu (PQSQ).

Lasso adaptacyjne

Adaptacyjne lasso zostało wprowadzone przez Zou w 2006 r. do regresji liniowej oraz przez Zhanga i Lu w 2007 r. do regresji proporcjonalnego hazardu.

Wcześniejsze lasso

Wcześniejsze lasso zostało wprowadzone do uogólnionych modeli liniowych przez Jianga i in. w 2016 r. w celu uwzględnienia wcześniejszych informacji, takich jak znaczenie niektórych zmiennych towarzyszących. We wcześniejszym lasso takie informacje są podsumowywane w pseudoodpowiedziach (zwanych wcześniejszymi odpowiedziami), dodaje się dodatkową funkcję funkcja z karą lassa. Bez utraty ogólności, w regresji liniowej nową funkcję celu można zapisać jako

co jest równoważne

z odpowiedziami zastępowanymi przez średnią ważoną obserwowanych odpowiedzi i wcześniejszych odpowiedzi odpowiedzi przez wcześniejsze informacje).

parametr jest parametrem równoważącym, ponieważ równoważy względne znaczenie danych i wcześniejszych informacji. W przypadku jest redukowane do lassa. Jeśli , wcześniejsze lasso będzie polegać wyłącznie na wcześniejszych informacjach, aby dopasować model. Ponadto parametr równoważący ma inną atrakcyjną interpretację: kontroluje wariancję w swojej wcześniejszej dystrybucji z bayesowskiego punktu widzenia.

Wcześniejsze lasso jest bardziej wydajne w szacowaniu i przewidywaniu parametrów (z mniejszym błędem oszacowania i błędem prognozy), gdy wcześniejsze informacje są wysokiej jakości i są odporne na wcześniejsze informacje niskiej jakości przy dobrym wyborze parametru równoważącego η { .

Obliczeniowe rozwiązania lassowe

Funkcja strat lassa nie jest różniczkowalna, ale opracowano szeroką gamę technik z analizy wypukłej i teorii optymalizacji w celu obliczenia ścieżki rozwiązania lassa. Obejmują one zejście współrzędnych, metody subgradientowe, regresję najmniejszego kąta (LARS) i metody proksymalnego gradientu. Metody subgradientowe są naturalnym uogólnieniem tradycyjnych metod, takich jak zejście gradientowe i stochastyczne zejście gradientowe do przypadku, w którym funkcja celu nie jest różniczkowalna we wszystkich punktach. LARS to metoda, która jest ściśle powiązana z modelami lassa iw wielu przypadkach pozwala na ich efektywne dopasowanie, chociaż może nie działać dobrze we wszystkich okolicznościach. LARS generuje kompletne ścieżki rozwiązań. Metody proksymalne stały się popularne ze względu na ich elastyczność i wydajność i są obszarem aktywnych badań. Wybór metody będzie zależał od konkretnego wariantu lassa, danych i dostępnych zasobów. Jednak metody proksymalne generalnie działają dobrze.

Wybór parametru regularyzacji

Wybór parametru regularyzacji ( jest podstawową częścią lassa Dobra wartość jest niezbędna do wykonania lassa, ponieważ kontroluje siłę skurczu i wybór zmiennych, co z umiarem może poprawić zarówno dokładność przewidywania, jak i interpretację. Jeśli jednak regularyzacja stanie się zbyt silna, ważne zmienne mogą zostać pominięte, a współczynniki mogą zostać nadmiernie zmniejszone, co może zaszkodzić zarówno zdolności predykcyjnej, jak i wnioskowaniu. Walidacja krzyżowa jest często używana do znalezienia parametru regularyzacji.

Kryteria informacyjne, takie jak Bayesowskie kryterium informacyjne (BIC) i kryterium informacyjne Akaike (AIC) mogą być lepsze niż walidacja krzyżowa, ponieważ są szybsze w obliczeniach, a ich wydajność jest mniej zmienna w małych próbkach. Kryterium informacyjne wybiera parametr regularyzacji estymatora, maksymalizując dokładność modelu w próbie, jednocześnie karając jego efektywną liczbę parametrów / stopni swobody. Zou i in. zaproponowano pomiar efektywnych stopni swobody przez zliczenie liczby parametrów, które odbiegają od zera. Podejście oparte na stopniach swobody zostało uznane za wadliwe przez Kaufmana i Rosseta oraz Jansona i in., ponieważ stopnie swobody modelu mogą wzrosnąć, nawet jeśli jest on bardziej karany przez parametr regularyzacji. Alternatywnie, zdefiniowana powyżej miara względnej prostoty może być wykorzystana do obliczenia efektywnej liczby parametrów. W przypadku lassa miara ta jest dana przez

- ,

od zera do parametr regularyzacji spada od do zera.

Wybrane aplikacje

LASSO zostało zastosowane w ekonomii i finansach i okazało się, że poprawia przewidywania i wybiera czasami zaniedbywane zmienne, na przykład w literaturze dotyczącej przewidywania upadłości przedsiębiorstw lub przewidywaniach firm o wysokim wzroście.

![{\displaystyle s\in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/aff1a54fbbee4a2677039524a5139e952fa86eb9)

![{\displaystyle {\begin{aligned}&\min _{\beta }\left\{{\frac {1}{N}}\sum _{i=1}^{N}\left(y_{i}-x_{i}^{t}\beta \right)^{2}\right\}\\[4pt]&{\text{ subject to }}\sum _{j=1}^{p}|\beta _{j}|\leq t_{1}{\text{ and }}\sum _{j=2}^{p}|\beta _{j}-\beta _{j-1}|\leq t_{2}.\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/a75f99fe3b19232504b470197d1158638ad10255)