Wybór modelu

Selekcja modeli polega na wybraniu modelu spośród różnych kandydatów na podstawie kryterium wydajności w celu wybrania najlepszego. W kontekście uczenia się może to być wybór modelu statystycznego ze zbioru modeli kandydujących, danych danych. W najprostszych przypadkach brany jest pod uwagę istniejący wcześniej zestaw danych. Jednak zadanie to może również obejmować zaprojektowanie eksperymentów w taki sposób, aby zebrane dane były dobrze dopasowane do problemu wyboru modelu. Biorąc pod uwagę modele kandydujące o podobnej mocy predykcyjnej lub wyjaśniającej, najprostszy model najprawdopodobniej będzie najlepszym wyborem ( brzytwa Ockhama ).

Konishi i Kitagawa (2008 , s. 75) stwierdzają: „Większość problemów wnioskowania statystycznego można uznać za problemy związane z modelowaniem statystycznym”. W związku z tym Cox (2006 , s. 197) powiedział: „Sposób, w jaki odbywa się tłumaczenie problemu przedmiotowego na model statystyczny, jest często najbardziej krytyczną częścią analizy”.

Wybór modelu może również odnosić się do problemu wyboru kilku reprezentatywnych modeli z dużego zestawu modeli obliczeniowych w celu podejmowania decyzji lub optymalizacji w warunkach niepewności.

Wstęp

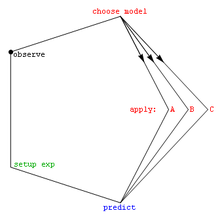

W swoich najbardziej podstawowych formach wybór modelu jest jednym z podstawowych zadań badań naukowych . Określenie zasady wyjaśniającej serię obserwacji jest często bezpośrednio powiązane z modelem matematycznym przewidującym te obserwacje. Na przykład, gdy Galileusz przeprowadzał eksperymenty na płaszczyźnie pochyłej , wykazał, że ruch kul pasuje do paraboli przewidzianej przez jego model [ potrzebne źródło ] .

Spośród niezliczonej liczby możliwych mechanizmów i procesów, które mogły wytworzyć dane, jak w ogóle zacząć wybierać najlepszy model? Powszechnie stosowane podejście matematyczne decyduje o zestawie modeli kandydujących; ten zestaw musi być wybrany przez badacza. Często stosuje się proste modele, takie jak wielomiany , przynajmniej początkowo [ potrzebne źródło ] . Burnham i Anderson (2002) w całej swojej książce podkreślają znaczenie wyboru modeli opartych na solidnych podstawach naukowych, takich jak zrozumienie fenomenologicznych procesów lub mechanizmów (np. reakcji chemicznych) leżących u podstaw danych.

Po wybraniu zestawu kandydujących modeli analiza statystyczna pozwala nam wybrać najlepszy z tych modeli. To, co rozumie się przez najlepsze, jest kontrowersyjne. Dobra technika wyboru modelu zrównoważy dobroć dopasowania z prostotą [ potrzebne źródło ] . Bardziej złożone modele będą w stanie lepiej dostosować swój kształt do danych (na przykład wielomian piątego rzędu może dokładnie pasować do sześciu punktów), ale dodatkowe parametry mogą nie reprezentować niczego użytecznego. (Być może te sześć punktów jest tak naprawdę rozłożonych losowo wokół linii prostej). Dobroć dopasowania jest ogólnie określana za pomocą ilorazu wiarygodności lub jego przybliżenie, prowadzące do testu chi-kwadrat . Złożoność jest ogólnie mierzona przez zliczanie liczby parametrów w modelu.

Techniki wyboru modelu można uznać za estymatory pewnej wielkości fizycznej, takiej jak prawdopodobieństwo, że model wytworzy dane. Odchylenie i wariancja są ważnymi miarami jakości tego estymatora ; Często brana jest pod uwagę także efektywność .

Standardowym przykładem wyboru modelu jest dopasowanie krzywej , gdzie mając zbiór punktów i inną wiedzę podstawową (np. punkty są wynikiem iid próbek), musimy wybrać krzywą opisującą funkcję, która wygenerowała punkty.

Dwa kierunki wyboru modelu

Istnieją dwa główne cele wnioskowania i uczenia się na podstawie danych. Jednym z nich jest odkrycie naukowe, zwane także wnioskowaniem statystycznym, zrozumienie podstawowego mechanizmu generowania danych i interpretacja natury danych. Innym celem uczenia się na podstawie danych jest przewidywanie przyszłych lub niewidocznych obserwacji, zwanych również przewidywaniami statystycznymi. W drugim celu data science niekoniecznie dotyczy dokładnego probabilistycznego opisu danych. Oczywiście można też być zainteresowanym w obu kierunkach.

Zgodnie z dwoma różnymi celami wybór modelu może mieć również dwa kierunki: wybór modelu do wnioskowania i wybór modelu do predykcji. Pierwszym kierunkiem jest zidentyfikowanie najlepszego modelu danych, który najlepiej zapewni wiarygodną charakterystykę źródeł niepewności dla interpretacji naukowej. W tym celu niezwykle ważne jest, aby wybrany model nie był zbyt wrażliwy na wielkość próby. W związku z tym odpowiednim pojęciem do oceny wyboru modelu jest spójność wyboru, co oznacza, że najbardziej solidny kandydat zostanie konsekwentnie wybrany przy wystarczającej liczbie próbek danych.

Drugim kierunkiem jest wybór modelu jako maszyny, która zapewni doskonałą wydajność predykcyjną. Jednak w przypadku tych ostatnich wybrany model może być po prostu szczęśliwym zwycięzcą wśród kilku bliskich konkurentów, ale wydajność predykcyjna może być nadal najlepsza z możliwych. Jeśli tak, wybór modelu jest odpowiedni dla drugiego celu (predykcji), ale użycie wybranego modelu do wglądu i interpretacji może być bardzo niewiarygodne i wprowadzające w błąd. Co więcej, dla tak dobranych bardzo złożonych modeli nawet przewidywania mogą być nieracjonalne dla danych tylko nieznacznie różniących się od tych, na podstawie których dokonano selekcji.

Metody wspomagające wybór zbioru modeli kandydujących

Kryteria

Poniżej znajduje się lista kryteriów wyboru modelu. Najczęściej stosowanymi kryteriami są (i) kryterium informacyjne Akaike oraz (ii) czynnik Bayesa i/lub kryterium informacyjne Bayesa (które w pewnym stopniu przypomina czynnik Bayesa), przegląd patrz Stoica i Selen (2004 ) .

- Kryterium informacyjne Akaike (AIC), miara dopasowania oszacowanego modelu statystycznego

- czynnik Bayesa

- Bayesowskie kryterium informacyjne (BIC), znane również jako kryterium informacyjne Schwarza, statystyczne kryterium wyboru modelu

- Kryterium pomostowe (BC), kryterium statystyczne, które może osiągnąć lepszą wydajność AIC i BIC pomimo trafności specyfikacji modelu.

- Walidacja krzyżowa

- Kryterium informacji o odchyleniu (DIC), kolejne kryterium wyboru modelu zorientowane na Bayesa

- Wskaźnik fałszywych odkryć

- Skoncentrowane kryterium informacyjne (FIC), kryterium wyboru sortujące modele statystyczne według ich skuteczności dla danego parametru skupienia

- Kryterium informacyjne Hannana-Quinna , alternatywa dla kryteriów Akaike i Bayesa

- Kryterium informacyjne Kashyap (KIC) jest potężną alternatywą dla AIC i BIC, ponieważ KIC wykorzystuje macierz informacyjną Fishera

- Test ilorazu wiarygodności

- Mallows C str

- Minimalna długość opisu

- Minimalna długość wiadomości (MML)

- Statystyka PRASA , zwana też kryterium PRASA

- Minimalizacja ryzyka strukturalnego

- Regresja krokowa

- Kryterium informacyjne Watanabe-Akaike (WAIC), zwane także szeroko stosowanym kryterium informacyjnym

- Rozszerzone Bayesowskie Kryterium Informacyjne (EBIC) jest rozszerzeniem zwykłego Bayesowskiego Kryterium Informacyjnego (BIC) dla modeli o dużej przestrzeni parametrów.

- Extended Fisher Information Criterion (EFIC) to kryterium wyboru modelu dla modeli regresji liniowej.

- Ograniczone kryterium minimum (CMC) jest częstym kryterium wyboru modeli regresji z geometryczną podstawą.

Spośród tych kryteriów walidacja krzyżowa jest zazwyczaj najdokładniejsza i najdroższa obliczeniowo w przypadku problemów z uczeniem nadzorowanym. [ potrzebne źródło ]

Burnham i Anderson (2002 , §6.3) mówią, co następuje:

Istnieje wiele metod wyboru modeli. Jednak z punktu widzenia statystycznej wydajności metody i zamierzonego kontekstu jej użycia, istnieją tylko dwie odrębne klasy metod: Zostały one oznaczone jako wydajne i spójne . (...) Zgodnie z częstościowym paradygmatem selekcji modeli generalnie istnieją trzy główne podejścia: (I) optymalizacja niektórych kryteriów selekcji, (II) testy hipotez oraz (III) metody ad hoc.

Zobacz też

- Wszystkie modele są błędne

- Analiza konkurencyjnych hipotez

- Automatyczne uczenie maszynowe (AutoML)

- Dylemat odchylenia-wariancji

- Wybór funkcji

- paradoks Freedmana

- Wyszukiwanie siatki

- Analiza identyfikowalności

- Analiza log-liniowa

- Identyfikacja modelu

- Brzytwa Ockhama

- Optymalny projekt

- Problem z identyfikacją parametrów

- Modelowanie naukowe

- Walidacja modelu statystycznego

- paradoks Steina

Notatki

- Aho, K.; Derryberry, D.; Peterson, T. (2014), „Wybór modeli dla ekologów: światopoglądy AIC i BIC”, Ekologia , 95 (3): 631–636, doi : 10.1890 / 13-1452.1 , PMID 24804445

- Akaike, H. (1994), „Implikacje informacyjnego punktu widzenia na rozwój nauk statystycznych”, w: Bozdogan, H. (red.), Proceedings of the First US/ JAPAN Conference on The Frontiers of Statistical Modeling: An Informational Podejście — tom 3 , Kluwer Academic Publishers , s. 27–38

- Anderson, DR (2008), Wnioskowanie oparte na modelach w naukach przyrodniczych , Springer, ISBN 9780387740751

- Ando, T. (2010), Wybór modelu Bayesa i modelowanie statystyczne , CRC Press , ISBN 9781439836156

- Breiman, L. (2001), „Modelowanie statystyczne: dwie kultury”, Statistical Science , 16 : 199–231, doi : 10.1214/ss/1009213726

- Burnham, KP; Anderson, DR (2002), Model Selection and Multimodel Inference: A Practical Information-Theoretic Approach (wyd. 2), Springer-Verlag, ISBN 0-387-95364-7 [ma ponad 38 000 cytowań w Google Scholar ]

- Chamberlin, TC (1890), „Metoda wielu hipotez roboczych”, Science , 15 (366): 92–6, Bibcode : 1890Sci….15R..92. , doi : 10.1126/science.ns-15.366.92 , PMID 17782687 (przedruk 1965, Science 148: 754–759 [1] doi : 10.1126/science.148.3671.754 )

- Claeskens, G. (2016), „Wybór modelu statystycznego” (PDF) , Annual Review of Statistics and Its Application , 3 (1): 233–256, Bibcode : 2016AnRSA...3..233C , doi : 10.1146/annurev -statistics-041715-033413 [ stały martwy link ]

- Claeskens, G.; Hjort, NL (2008), Wybór modelu i uśrednianie modelu , Cambridge University Press, ISBN 9781139471800

- Cox, DR (2006), Zasady wnioskowania statystycznego , Cambridge University Press

- Ding, J.; Tarokh, V.; Yang . _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ _ MSP.2018.2867638 , S2CID 53035396

- Kashyap, RL (1982), „Optymalny wybór części AR i MA w modelach autoregresyjnej średniej ruchomej”, IEEE Transactions on Pattern Analysis and Machine Intelligence , IEEE, PAMI-4 (2): 99–104, doi : 10.1109 / TPAMI. 1982.4767213 , PMID 21869012 , S2CID 18484243

- Konishi, S.; Kitagawa, G. (2008), Kryteria informacyjne i modelowanie statystyczne , Springer, Bibcode : 2007icsm.book.....K , ISBN 9780387718866

- Lahiri, P. (2001), Wybór modelu , Instytut Statystyki Matematycznej

- Leeb, H.; Pötscher, BM (2009), „Wybór modelu”, w Anderson, TG (red.), Handbook of Financial Time Series , Springer, s. 889–925, doi : 10.1007 / 978-3-540-71297-8_39 , ISBN 978-3-540-71296-1

- Lukacs, PM; Thompson, WL; Kendall, WL; Gould, WR; Doherty, PF Jr.; Burnham, KP; Anderson, DR (2007), „Obawy dotyczące wezwania do pluralizmu teorii informacji i testowania hipotez”, Journal of Applied Ecology , 44 (2): 456–460, doi : 10.1111/j.1365-2664.2006.01267.x , S2CID 83816981

- McQuarrie, Allan DR; Tsai, Chih-Ling (1998), Wybór modelu regresji i szeregów czasowych , Singapur: World Scientific, ISBN 981-02-3242-X

- Massart, P. (2007), Nierówności koncentracji i wybór modelu , Springer

- Massart, P. (2014), „Nieasymptotyczny spacer po prawdopodobieństwie i statystyce” , w: Lin, Xihong (red.), Past, Present and Future of Statistical Science , Chapman & Hall , s. 309–321, ISBN 9781482204988

- Navarro, DJ (2019), „Between the Devil and the Deep Blue Sea: Napięcia między oceną naukową a wyborem modelu statystycznego”, Computational Brain & Behavior , 2 : 28–34, doi : 10.1007/s42113-018-0019-z

- Resende, Paulo Angelo Alves; Dorea, Chang Chung Yu (2016), „Identyfikacja modelu za pomocą kryterium efektywnego określania”, Journal of Multivariate Analysis , 150 : 229–244, arXiv : 1409,7441 , doi : 10,1016/j.jmva.2016.06.002 , S2CID 5469654

- Shmueli, G. (2010), „Wyjaśniać czy przewidywać?” , Nauki statystyczne , 25 (3): 289–310, arXiv : 1101.0891 , doi : 10.1214/10-STS330 , MR 2791669 , S2CID 15900983

- Stoica, P.; Selen, Y. (2004), „Wybór kolejności modeli: przegląd reguł kryteriów informacyjnych” (PDF) , IEEE Signal Processing Magazine , 21 (4): 36–47, doi : 10.1109 / MSP.2004.1311138 , S2CID 17338979

- Wit, E.; van den Heuvel, E.; Romeijn, J.-W. (2012), „ Wszystkie modele są błędne ...”: wprowadzenie do niepewności modelu” (PDF) , Statistica Neerlandica , 66 (3): 217–236, doi : 10.1111 / j.1467-9574.2012.00530.x , S2CID 7793470

- Wit, E.; McCullagh, P. (2001), Viana, MAG; Richards, D. St. P. (red.), „Rozszerzalność modeli statystycznych”, Metody algebraiczne w statystyce i prawdopodobieństwie , s. 327–340

- Wójtowicz, Anna; Bigaj, Tomasz (2016), "Uzasadnienie, potwierdzenie i problem wzajemnie wykluczających się hipotez", w: Kuźniar, Adrian; Odrowąż-Sypniewska, Joanna (red.), Odkrywanie faktów i wartości , Brill Publishers , s. 122–143, doi : 10.1163/9789004312654_009 , ISBN 9789004312654

- Owrang, Arash; Jansson, Magnus (2018), „Kryterium wyboru modelu dla wielowymiarowej regresji liniowej” , IEEE Transactions on Signal Processing , 66 (13): 3436–3446, Bibcode : 2018ITSP...66.3436O , doi : 10.1109/TSP. 2018.2821628 , ISSN 1941-0476 , S2CID 46931136

- B. Gohain, Prakash; Jansson, Magnus (2022), „Niezmienne w skali i spójne Bayesowskie kryterium informacyjne do wyboru rzędów w modelach regresji liniowej”, Przetwarzanie sygnału , 196 : 108499, doi : 10.1016/j.sigpro.2022.108499 , ISSN 0165-1684 , S2CID 246759677