Inżynieria niezawodności

Inżynieria niezawodności to poddyscyplina inżynierii systemów , która kładzie nacisk na zdolność sprzętu do bezawaryjnego działania. Niezawodność opisuje zdolność systemu lub komponentu do działania w określonych warunkach przez określony czas. Niezawodność jest ściśle związana z dostępnością , którą zwykle opisuje się jako zdolność komponentu lub systemu do działania w określonym momencie lub przedziale czasu.

niezawodności jest teoretycznie zdefiniowana jako prawdopodobieństwo sukcesu w czasie t , które oznaczamy R(t). Prawdopodobieństwo to jest szacowane na podstawie szczegółowej analizy (fizyki awarii), poprzednich zestawów danych lub poprzez testy niezawodności i modelowanie niezawodności. Dostępność , testowalność , łatwość utrzymania i konserwacja są często definiowane jako część „inżynierii niezawodności” w programach niezawodności. Niezawodność często odgrywa kluczową rolę w opłacalności systemów.

Inżynieria niezawodności zajmuje się przewidywaniem, zapobieganiem i zarządzaniem wysokimi poziomami inżynierskiej niepewności „ życia ” i ryzyka awarii. Chociaż stochastyczne definiują niezawodność i wpływają na nią, niezawodność osiąga się nie tylko za pomocą matematyki i statystyki. „Prawie całe nauczanie i literatura na ten temat kładzie nacisk na te aspekty i ignoruje rzeczywistość, w której zakresy niepewności w dużej mierze unieważniają ilościowe metody przewidywania i pomiar.” Na przykład łatwo jest przedstawić „prawdopodobieństwo awarii” jako symbol lub wartość w równaniu, ale prawie niemożliwe jest przewidzenie jego prawdziwej wielkości w praktyce, która jest bardzo wielowymiarowa, więc mając równanie na niezawodność nie zaczyna być równoznaczne z posiadaniem dokładnego predykcyjnego pomiaru niezawodności.

Inżynieria niezawodności jest ściśle powiązana z inżynierią jakości, inżynierią bezpieczeństwa i bezpieczeństwem systemu , ponieważ wykorzystują one wspólne metody do ich analizy i mogą wymagać wzajemnego wkładu. Można powiedzieć, że system musi być niezawodnie bezpieczny.

Inżynieria niezawodności koncentruje się na kosztach awarii spowodowanych przestojem systemu, kosztach części zamiennych, sprzętu naprawczego, personelu oraz kosztach roszczeń gwarancyjnych.

Historia

Słowo niezawodność pochodzi z 1816 roku i zostało po raz pierwszy potwierdzone przez poetę Samuela Taylora Coleridge'a . Przed II wojną światową termin ten kojarzony był głównie z powtarzalnością ; test (w dowolnym rodzaju nauki) był uważany za „wiarygodny”, jeśli te same wyniki byłyby uzyskiwane wielokrotnie. Walter A. Shewhart z Bell Labs promował ulepszanie produktów poprzez wykorzystanie statystycznej kontroli procesu , mniej więcej w tym samym czasie, gdy Waloddi Weibull pracował nad statystycznymi modelami zmęczenia. Rozwój inżynierii niezawodności przebiegał tutaj równolegle z jakością. Współczesne użycie słowa niezawodność zostało zdefiniowane przez wojsko USA w latach czterdziestych XX wieku, charakteryzując produkt, który działałby zgodnie z oczekiwaniami i przez określony czas.

Podczas II wojny światowej wiele problemów z niezawodnością wynikało z nieodłącznej zawodności dostępnego wówczas sprzętu elektronicznego oraz problemów ze zmęczeniem. W 1945 roku MA Miner opublikował przełomowy artykuł zatytułowany „Cumulative Damage in Fatigue” w czasopiśmie ASME. Głównym zastosowaniem inżynierii niezawodności w wojsku była lampa próżniowa stosowana w systemach radarowych i innej elektronice, dla których niezawodność okazała się bardzo problematyczna i kosztowna. IEEE utworzyło Reliability Society w 1948 r. W 1950 r. Departament Obrony Stanów Zjednoczonych utworzył grupę o nazwie „Grupa Doradcza ds. Niezawodności Sprzętu Elektronicznego” (AGREE) w celu zbadania metod niezawodności sprzętu wojskowego. Grupa ta zarekomendowała trzy główne sposoby pracy:

- Popraw niezawodność komponentów.

- Ustal wymagania dotyczące jakości i niezawodności dla dostawców.

- Zbieraj dane terenowe i znajduj podstawowe przyczyny awarii.

W latach sześćdziesiątych większy nacisk położono na testowanie niezawodności na poziomie komponentów i systemu. Powstał wówczas słynny wojskowy standard MIL-STD-781. RCA opublikowała również często używanego poprzednika podręcznika wojskowego 217, który był używany do przewidywania wskaźników awaryjności elementów elektronicznych. Nacisk na samą niezawodność komponentów i badania empiryczne (np. Mil Std 217) powoli malał. Stosowano bardziej pragmatyczne podejście, stosowane w branżach konsumenckich. W latach 80. telewizory w coraz większym stopniu składały się z półprzewodników półprzewodnikowych. Samochody szybko zwiększyły wykorzystanie półprzewodników z różnymi mikrokomputerami pod maską i na desce rozdzielczej. Duże systemy klimatyzacji opracowały elektroniczne sterowniki, podobnie jak kuchenki mikrofalowe i wiele innych urządzeń. Systemy komunikacyjne zaczęły przyjmować elektronikę w celu zastąpienia starszych mechanicznych systemów przełączających. Firma Bellcore wydała pierwszą metodologię prognozowania konsumentów dla telekomunikacji, a firma SAE opracowała podobny dokument SAE870050 do zastosowań motoryzacyjnych. Charakter prognoz ewoluował w ciągu dekady i stało się jasne, że złożoność matrycy nie była jedynym czynnikiem determinującym wskaźniki awaryjności układów scalonych (IC). Kam Wong opublikował artykuł kwestionujący krzywiznę wanny — patrz także konserwacja skoncentrowana na niezawodności . W ciągu tej dekady awaryjność wielu komponentów spadła dziesięciokrotnie. Oprogramowanie stało się ważne dla niezawodności systemów. W latach 90. tempo rozwoju układów scalonych nabrało tempa. Szersze zastosowanie samodzielnych mikrokomputerów było powszechne, a rynek komputerów osobistych pomógł utrzymać gęstość układów scalonych zgodnie z prawem Moore'a i podwajać się co mniej więcej 18 miesięcy. Inżynieria niezawodności zmieniała się, zmierzając w kierunku zrozumienia fizyki awarii . Wskaźniki awaryjności komponentów stale spadały, ale problemy na poziomie systemu stały się bardziej widoczne. Myślenie systemowe stawało się coraz ważniejsze. W przypadku oprogramowania model CMM ( Capability Maturity Model ), który dał bardziej jakościowe podejście do niezawodności. Norma ISO 9000 dodała miary niezawodności w ramach części certyfikacji związanej z projektowaniem i rozwojem. Ekspansja sieci WWW stworzyła nowe wyzwania w zakresie bezpieczeństwa i zaufania. Starszy problem zbyt małej ilości dostępnych informacji o niezawodności został teraz zastąpiony zbyt dużą ilością informacji o wątpliwej wartości. Problemy z niezawodnością konsumentów można teraz omawiać online w czasie rzeczywistym przy użyciu danych. Nowe technologie, takie jak systemy mikroelektromechaniczne ( MEMS ), podręczny GPS oraz urządzenia podręczne, które łączyły telefony komórkowe i komputery, stanowią wyzwanie dla utrzymania niezawodności. W ciągu tej dekady czas rozwoju produktu nadal się skracał, a to, co zostało zrobione w ciągu trzech lat, zostało zrobione w ciągu 18 miesięcy. Oznaczało to, że narzędzia i zadania związane z niezawodnością musiały być ściślej powiązane z samym procesem rozwoju. Pod wieloma względami niezawodność stała się częścią codziennego życia i oczekiwań konsumentów.

Przegląd

Cel

Cele inżynierii niezawodności, w malejącej kolejności priorytetów, to:

- Stosowanie wiedzy inżynierskiej i specjalistycznych technik w celu zapobiegania lub zmniejszania prawdopodobieństwa lub częstotliwości awarii.

- Identyfikacja i korygowanie przyczyn awarii, które występują pomimo wysiłków zmierzających do ich zapobiegania.

- Określenie sposobów radzenia sobie z niepowodzeniami, które się zdarzają, jeśli ich przyczyny nie zostały usunięte.

- Stosować metody szacowania prawdopodobnej niezawodności nowych konstrukcji oraz analizowania danych dotyczących niezawodności.

Powodem położenia nacisku na priorytet jest to, że jest to zdecydowanie najbardziej efektywny sposób pracy pod względem minimalizacji kosztów i generowania niezawodnych produktów. Podstawowe umiejętności, które są wymagane, to zatem umiejętność zrozumienia i przewidywania możliwych przyczyn awarii oraz wiedza, jak im zapobiegać. Konieczna jest również znajomość metod, które można wykorzystać do analizy projektów i danych.

Zakres i techniki

Inżynieria niezawodności dla „ systemów złożonych ” wymaga innego, bardziej rozbudowanego podejścia systemowego niż w przypadku systemów nieskomplikowanych. Inżynieria niezawodności może w takim przypadku obejmować:

- Analiza dostępności systemu i gotowości do misji oraz związana z tym alokacja wymagań w zakresie niezawodności i konserwacji

- Funkcjonalna analiza awarii systemu i pochodna specyfikacja wymagań

- Nieodłączna (systemowa) analiza niezawodności projektu i pochodna specyfikacja wymagań dla projektowania sprzętu i oprogramowania

- Projekt diagnostyki systemu

- Systemy odporne na awarie (np. przez redundancję)

- predykcyjna i zapobiegawcza (np. konserwacja zorientowana na niezawodność)

- Czynniki ludzkie / interakcje międzyludzkie / błędy ludzkie

- Awarie spowodowane produkcją i montażem (wpływ na wykrytą „jakość 0-godzinną” i niezawodność)

- Awarie spowodowane konserwacją

- Awarie spowodowane transportem

- Awarie spowodowane pamięcią masową

- Badania użytkowania (obciążenia), analiza naprężeń komponentów i pochodna specyfikacja wymagań

- Awarie oprogramowania (systematyczne).

- Testy awarii/niezawodności (i wymagania pochodne)

- Monitorowanie awarii w terenie i działania naprawcze

- części zamiennych (kontrola dostępności)

- Dokumentacja techniczna, analiza ostrożności i ostrzeżeń

- Pozyskiwanie/organizacja danych i informacji (stworzenie ogólnego dziennika zagrożeń rozwoju niezawodności oraz systemu FRACAS )

- Inżynieria chaosu

Skuteczna inżynieria niezawodności wymaga zrozumienia podstaw mechanizmów awarii, do czego potrzebne jest doświadczenie, szerokie umiejętności inżynierskie i dobra znajomość wielu różnych specjalistycznych dziedzin inżynierii, na przykład:

- Trybologia

- Stres (mechanika)

- Mechanika pękania / zmęczenie

- Inżynieria cieplna

- Mechanika płynów / inżynieria obciążeń udarowych

- Inżynieria elektryczna

- Inżynieria chemiczna (np. korozja )

- Nauka o materiałach

Definicje

Niezawodność można zdefiniować w następujący sposób:

- Pomysł, że przedmiot nadaje się do określonego celu w odniesieniu do czasu

- Zdolność zaprojektowanego, wyprodukowanego lub utrzymywanego elementu do działania zgodnie z wymaganiami w czasie

- Zdolność populacji zaprojektowanych, wyprodukowanych lub utrzymywanych elementów do działania zgodnie z wymaganiami w czasie

- Odporność elementu na uszkodzenia w czasie

- Prawdopodobieństwo, że przedmiot spełni określoną funkcję w określonych warunkach przez określony czas

- Trwałość obiektu

Podstawy oceny niezawodności

ocenie ryzyka niezawodności stosuje się wiele technik inżynierskich , takich jak schematy blokowe niezawodności, analiza zagrożeń , analiza trybów i skutków awarii (FMEA), analiza drzewa błędów (FTA), konserwacja skoncentrowana na niezawodności , (probabilistyczne) obciążenia i obliczenia naprężeń i zużycia materiałów, (probabilistyczna) analiza zmęczenia i pełzania, analiza błędów ludzkich, analiza wad produkcyjnych, testowanie niezawodności itp. Kluczowe znaczenie ma, aby analizy te były wykonywane prawidłowo iz dużą dbałością o szczegóły, aby były skuteczne. Ze względu na dużą liczbę technik niezawodności, ich koszt oraz różne stopnie niezawodności wymagane w różnych sytuacjach, większość projektów opracowuje plan programu niezawodności, aby określić zadania związane z niezawodnością ( dotyczące specyfikacji pracy (SoW), które zostaną wykonane dla tego konkretnego systemu.

Zgodnie z tworzeniem przypadków bezpieczeństwa , na przykład zgodnie z ARP4761 , celem ocen niezawodności jest dostarczenie solidnego zestawu jakościowych i ilościowych dowodów na to, że użycie komponentu lub systemu nie będzie wiązało się z niedopuszczalnym ryzykiem. Podstawowe kroki, które należy podjąć, to:

- Dokładnie zidentyfikuj odpowiednie „zagrożenia” związane z zawodnością, np. potencjalne warunki, zdarzenia, błędy ludzkie, tryby awarii, interakcje, mechanizmy awarii i pierwotne przyczyny, za pomocą określonych analiz lub testów.

- Oceń powiązane ryzyko systemowe, przeprowadzając szczegółową analizę lub testy.

- Zaproponuj łagodzenie, np. wymagania , zmiany w projekcie, logikę wykrywania, konserwację, szkolenie, dzięki którym ryzyko może zostać obniżone i kontrolowane na akceptowalnym poziomie.

- Określ najlepsze środki zaradcze i uzyskaj porozumienie co do ostatecznych, akceptowalnych poziomów ryzyka, w miarę możliwości w oparciu o analizę kosztów i korzyści.

Ryzyko jest tutaj kombinacją prawdopodobieństwa i dotkliwości wystąpienia incydentu awarii (scenariusza). Na dotkliwość można spojrzeć z punktu widzenia bezpieczeństwa systemu lub dostępności systemu. Niezawodność dla bezpieczeństwa może być traktowana jako zupełnie inny cel niż niezawodność dla dostępności systemu. Dostępność i bezpieczeństwo mogą istnieć w dynamicznym napięciu, ponieważ utrzymywanie zbyt dużej dostępności systemu może być niebezpieczne. Zbyt szybkie wymuszenie przejścia systemu inżynieryjnego w stan bezpieczny może wymusić fałszywe alarmy, które ograniczają dostępność systemu.

W definicji de minimis dotkliwość awarii obejmuje koszt części zamiennych, roboczogodzin, logistyki, uszkodzenia (awarie wtórne) oraz przestoje maszyn, które mogą spowodować utratę produkcji. Pełniejsza definicja niepowodzenia może również oznaczać obrażenia, rozczłonkowanie i śmierć ludzi w systemie (świadkami wypadków w kopalniach, wypadkach przemysłowych, awariach promów kosmicznych) i to samo dla niewinnych osób postronnych (świadkami mieszkańców miast takich jak Bhopal, Love Canal, Czarnobyl, Sendai i inne ofiary trzęsienia ziemi i tsunami w Tōhoku w 2011 roku) – w tym przypadku inżynieria niezawodności staje się bezpieczeństwem systemu. To, co jest dopuszczalne, określa instytucja zarządzająca, klienci lub zainteresowane społeczności. Ryzyko szczątkowe to ryzyko, które pozostaje po zakończeniu wszystkich działań związanych z niezawodnością i obejmuje ryzyko niezidentyfikowane, a zatem nie jest w pełni mierzalne.

Złożoność systemów technicznych, takich jak ulepszenia projektu i materiałów, planowane kontrole, konstrukcja odporna na błędy i redundancja kopii zapasowych, zmniejsza ryzyko i zwiększa koszty. Ryzyko można zmniejszyć do poziomu ALARA (tak niskiego, jak rozsądnie osiągalne) lub ALAPA (tak niskiego, jak praktycznie osiągalne).

Plan programu niezawodności i dostępności

Wdrożenie programu niezawodności to nie tylko zakup oprogramowania; to nie tylko lista kontrolna elementów, które należy wypełnić, aby zapewnić niezawodne produkty i procesy. Program niezawodności to złożony system uczenia się i oparty na wiedzy, unikalny dla produktów i procesów. Jest wspierany przez przywództwo, zbudowany na umiejętnościach rozwijanych w zespole, zintegrowany z procesami biznesowymi i realizowany zgodnie ze sprawdzonymi standardowymi praktykami pracy.

Plan programu niezawodności służy do dokładnego udokumentowania „najlepszych praktyk” (zadań, metod, narzędzi, analiz i testów) wymaganych dla określonego (pod)systemu, a także wyjaśnienia wymagań klienta dotyczących oceny niezawodności. W przypadku złożonych systemów o dużej skali plan programu niezawodności powinien stanowić odrębny dokument . Określenie zasobów siły roboczej i budżetów na testowanie i inne zadania ma kluczowe znaczenie dla powodzenia programu. Ogólnie rzecz biorąc, ilość pracy wymaganej dla skutecznego programu dla złożonych systemów jest duża.

Plan programu niezawodności jest niezbędny do osiągnięcia wysokiego poziomu niezawodności, testowalności, łatwości konserwacji i wynikającej z tego dostępności systemu i jest opracowywany na wczesnym etapie rozwoju systemu i udoskonalany w całym cyklu życia systemu. Określa nie tylko to, co robi inżynier niezawodności, ale także zadania wykonywane przez innych interesariuszy . Skuteczny plan programu niezawodności musi zostać zatwierdzony przez najwyższe kierownictwo programu, które odpowiada za przydzielenie wystarczających środków na jego realizację.

Plan programu niezawodności może być również wykorzystany do oceny i poprawy dostępności systemu poprzez strategię skupienia się na zwiększaniu testowalności i łatwości konserwacji, a nie na niezawodności. Poprawa łatwości konserwacji jest na ogół łatwiejsza niż poprawa niezawodności. Szacunki dotyczące łatwości utrzymania (wskaźniki napraw) są również generalnie dokładniejsze. Ponieważ jednak niepewności oszacowań niezawodności są w większości przypadków bardzo duże, prawdopodobnie zdominują one obliczenia dostępności (problem niepewności predykcji), nawet jeśli poziomy łatwości utrzymania są bardzo wysokie. Kiedy niezawodność nie jest pod kontrolą, mogą pojawić się bardziej skomplikowane problemy, takie jak niedobory siły roboczej (konserwatorów / możliwości obsługi klienta), dostępność części zamiennych, opóźnienia logistyczne, brak zaplecza naprawczego, rozległe koszty modernizacji i zarządzania złożoną konfiguracją i inne. Problem zawodności może nasilać się również z powodu „efektu domina” awarii serwisowych po naprawach. Dlatego skupienie się tylko na łatwości konserwacji nie wystarczy. Jeśli zapobiega się awariom, żadne inne kwestie nie mają znaczenia, dlatego niezawodność jest ogólnie uważana za najważniejszą część dostępności. Niezawodność należy ocenić i poprawić w odniesieniu zarówno do dostępności, jak i całkowity koszt posiadania (TCO) ze względu na koszty części zamiennych, roboczogodzin konserwacji, kosztów transportu, kosztów magazynowania, ryzyka związanego z przestarzałymi częściami itp. Ale, jak GM i Toyota odkryły to z opóźnieniem, TCO obejmuje również koszty odpowiedzialności na dalszych etapach, gdy obliczenia niezawodności nie są wystarczająco lub dokładnie odnosiły się do osobistych zagrożeń dla zdrowia klientów. Często potrzebny jest kompromis między tymi dwoma. Może istnieć maksymalny stosunek między dostępnością a kosztem posiadania. W planie należy również uwzględnić testowalność systemu, ponieważ jest to związek między niezawodnością a łatwością konserwacji. Strategia konserwacji może wpływać na niezawodność systemu (np konserwacja predykcyjna ), chociaż nigdy nie może wynieść go ponad wrodzoną niezawodność.

Plan niezawodności powinien jasno określać strategię kontroli dostępności. To, czy ważniejsza jest tylko dostępność, czy też koszt posiadania, zależy od sposobu użytkowania systemu. Na przykład system, który jest krytycznym ogniwem w systemie produkcyjnym — np. duża platforma wiertnicza — zwykle może wiązać się z bardzo wysokimi kosztami posiadania, jeśli koszt ten przekłada się na choćby niewielki wzrost dostępności, ponieważ niedostępność platformy powoduje ogromną utratę przychodów, która może z łatwością przekroczyć wysokie koszty posiadania. Właściwy plan niezawodności powinien zawsze odnosić się do analizy RAMT w jej pełnym kontekście. RAMT oznacza niezawodność, dostępność, łatwość konserwacji i testowalność w kontekście potrzeb klienta.

Wymagania dotyczące niezawodności

W przypadku każdego systemu jednym z pierwszych zadań inżynierii niezawodności jest odpowiednie określenie wymagań w zakresie niezawodności i łatwości konserwacji, które wynikają z ogólnych potrzeb dotyczących dostępności i, co ważniejsze, wynikają z właściwej analizy błędów projektowych lub wyników wstępnych testów prototypu. Jasne wymagania (możliwe do zaprojektowania) powinny powstrzymywać projektantów przed projektowaniem konkretnych elementów/konstrukcji/interfejsów/systemów. Ustawianie jedynie celów dotyczących dostępności, niezawodności, testowalności lub łatwości konserwacji (np. maksymalne wskaźniki awaryjności) nie jest właściwe. Jest to szerokie nieporozumienie dotyczące Inżynierii Wymagań Niezawodności. Wymagania dotyczące niezawodności dotyczą samego systemu, w tym wymagań dotyczących testów i ocen oraz związanych z nimi zadań i dokumentacji. Wymagania dotyczące niezawodności są zawarte w odpowiednich specyfikacjach wymagań dotyczących systemu lub podsystemu, planach testów i oświadczeniach kontraktowych. Stworzenie odpowiednich wymagań niższego poziomu ma kluczowe znaczenie. Określenie jedynie minimalnych celów ilościowych (np. Średni czas między awariami (MTBF) lub wskaźniki awaryjności) nie są wystarczające z różnych powodów. Jednym z powodów jest to, że pełna walidacja (związana z poprawnością i weryfikowalnością w czasie) ilościowej alokacji niezawodności (specyfikacji wymagań) na niższych poziomach dla złożonych systemów nie może (często) zostać przeprowadzona w wyniku (1) faktu, że wymagania są probabilistyczne, (2) niezwykle wysoki poziom niepewności związany z wykazaniem zgodności ze wszystkimi tymi probabilistycznymi wymaganiami, a ponieważ (3) niezawodność jest funkcją czasu, a dokładne oszacowania (probabilistycznej) liczby niezawodności na element są dostępne tylko bardzo późno w projekcie, czasem nawet po wielu latach eksploatacji. Porównaj ten problem z ciągłym (ponownym) równoważeniem, na przykład, wymagań masy systemu niższego poziomu w rozwoju samolotu, co już często jest dużym przedsięwzięciem. Zauważ, że w tym przypadku masy różnią się tylko o kilka procent, nie są funkcją czasu, dane są nieprobabilistyczne i dostępne już w modelach CAD. W przypadku niezawodności poziomy zawodności (wskaźniki awaryjności) mogą zmieniać się wraz z czynnikami dziesięcioleci (wielokrotnościami 10) w wyniku bardzo niewielkich odchyleń w projekcie, procesie lub czymkolwiek innym. Informacje często nie są dostępne bez ogromnych niepewności w fazie rozwoju. To sprawia, że ten problem alokacji jest prawie niemożliwy do wykonania w użyteczny, praktyczny i prawidłowy sposób, który nie skutkuje masowym zawyżeniem lub zaniżeniem specyfikacji. Potrzebne jest zatem podejście pragmatyczne – np.: stosowanie ogólnych poziomów/klas wymagań ilościowych uzależnionych jedynie od dotkliwości skutków awarii. Ponadto walidacja wyników jest zadaniem o wiele bardziej subiektywnym niż w przypadku jakiegokolwiek innego rodzaju wymagań. (Ilościowe) parametry niezawodności — pod względem MTBF — są zdecydowanie najbardziej niepewnymi parametrami projektowymi w każdym projekcie.

Ponadto wymagania projektowe dotyczące niezawodności powinny kierować projektem (systemu lub części) w celu uwzględnienia cech, które zapobiegają występowaniu awarii lub przede wszystkim ograniczają skutki awarii. Nie tylko pomogłoby to w niektórych przewidywaniach, ale wysiłek ten powstrzymałby od rozproszenia wysiłków inżynieryjnych w rodzaj pracy księgowej. Wymaganie projektowe powinno być wystarczająco precyzyjne, aby projektant mógł „zaprojektować” je, a także udowodnić - poprzez analizę lub testowanie - że wymaganie zostało spełnione i, jeśli to możliwe, w pewnym stopniu stwierdzone. Każdy rodzaj wymagań dotyczących niezawodności powinien być szczegółowy i można go wyprowadzić z analizy awarii (analiza naprężeń i zmęczenia metodą elementów skończonych, analiza zagrożeń niezawodności, FTA, FMEA, analiza czynnika ludzkiego, analiza zagrożeń funkcjonalnych itp.) lub dowolnego rodzaju testów niezawodności. Potrzebne są również wymagania dotyczące testów weryfikacyjnych (np. wymagane naprężenia przeciążeniowe) i wymagany czas testów. Aby uzyskać te wymagania w efektywny sposób, a Inżynieria systemowa należy zastosować ocenę ryzyka i logikę łagodzenia skutków. Należy stworzyć solidne systemy dzienników zagrożeń, które zawierają szczegółowe informacje o przyczynach i sposobach awarii systemów. Wymagania mają być uzyskiwane i śledzone w ten sposób. Te praktyczne wymagania projektowe powinny kierować projektem, a nie być wykorzystywane wyłącznie do celów weryfikacji. Wymagania te (często ograniczenia projektowe) są w ten sposób wyprowadzane z analizy awarii lub badań wstępnych. Zrozumienie tej różnicy w porównaniu z czysto ilościową (logistyczną) specyfikacją wymagań (np. wskaźnik awaryjności / cel MTBF) ma zasadnicze znaczenie dla rozwoju udanych (złożonych) systemów.

Wymagania dotyczące łatwości konserwacji dotyczą kosztów napraw, a także czasu naprawy. Wymagania dotyczące testowalności (nie mylić z wymaganiami testowymi) zapewniają powiązanie między niezawodnością a łatwością konserwacji i powinny dotyczyć wykrywalności trybów awarii (na określonym poziomie systemu), poziomów izolacji i tworzenia diagnostyki (procedur). Jak wskazano powyżej, inżynierowie zajmujący się niezawodnością powinni również uwzględniać wymagania dotyczące różnych zadań związanych z niezawodnością i dokumentacji podczas opracowywania, testowania, produkcji i eksploatacji systemu. Wymagania te są na ogół określone w specyfikacji prac w umowie i zależą od tego, jaką swobodę klient chce zapewnić wykonawcy. Zadania związane z niezawodnością obejmują różne analizy, planowanie i raportowanie awarii. Wybór zadania zależy od krytyczności systemu oraz kosztów. System o krytycznym znaczeniu dla bezpieczeństwa może wymagać formalnego zgłaszania awarii i procesu przeglądu w trakcie opracowywania, podczas gdy system niekrytyczny może polegać na końcowych raportach z testów. Najczęstsze zadania programu niezawodności są udokumentowane w standardach programu niezawodności, takich jak MIL-STD-785 i IEEE 1332. Analiza zgłaszania awarii i systemy działań naprawczych są powszechnym podejściem do monitorowania niezawodności produktu/procesu.

Kultura niezawodności / błędy ludzkie / czynniki ludzkie

W praktyce większość niepowodzeń wynika z pewnego rodzaju błędu ludzkiego , na przykład w:

- Decyzje zarządcze (np. dotyczące budżetowania, harmonogramu i wymaganych zadań)

- Inżynieria systemów: badania użytkowania (przypadki obciążeń)

- Inżynieria systemów: analiza/ustawianie wymagań

- Inżynieria systemów: kontrola konfiguracji

- Założenia

- Obliczenia / symulacje / analiza MES

- Projekt

- Rysunki projektowe

- Testowanie (np. nieprawidłowe ustawienie obciążenia lub pomiar awarii)

- Analiza statystyczna

- Produkcja

- Kontrola jakości

- Konserwacja

- Instrukcje konserwacji

- Szkolenie

- Klasyfikacja i porządkowanie informacji

- Informacja zwrotna dotycząca informacji terenowych (np. nieprawidłowa lub zbyt niejasna)

- itp.

Jednak ludzie są również bardzo dobrzy w wykrywaniu takich awarii, korygowaniu ich i improwizowaniu w przypadku wystąpienia nietypowych sytuacji. Dlatego polityki, które całkowicie wykluczają działania człowieka w procesach projektowania i produkcji w celu poprawy niezawodności, mogą nie być skuteczne. Niektóre zadania są lepiej wykonywane przez ludzi, a inne przez maszyny.

Ponadto błędy ludzkie w zarządzaniu; organizacja danych i informacji; lub niewłaściwe użycie lub nadużycie przedmiotów, może również przyczynić się do niewiarygodności. Jest to główny powód, dla którego wysoki poziom niezawodności złożonych systemów można osiągnąć jedynie poprzez przestrzeganie solidnego inżynierii systemów z odpowiednim planowaniem i wykonywaniem zadań walidacji i weryfikacji. Obejmuje to również staranną organizację udostępniania danych i informacji oraz tworzenie „kultury niezawodności”, w taki sam sposób, w jaki posiadanie „kultury bezpieczeństwa” ma ogromne znaczenie w rozwoju systemów o krytycznym znaczeniu dla bezpieczeństwa.

Przewidywanie i poprawa niezawodności

Prognozowanie niezawodności łączy w sobie:

- stworzenie odpowiedniego modelu niezawodnościowego (patrz dalej na tej stronie)

- oszacowanie (i uzasadnienie) parametrów wejściowych dla tego modelu (np. współczynniki awaryjności dla określonego rodzaju awarii lub zdarzenia oraz średni czas naprawy systemu dla określonej awarii)

- oszacowanie parametrów niezawodności wyjściowej na poziomie systemu lub części (tj. dostępność systemu lub częstotliwość konkretnej awarii funkcjonalnej) Nacisk na kwantyfikację i ustalenie celu (np. MTBF) może sugerować, że istnieje granica osiągalnej niezawodności, jednak nie ma nieodłącznego ograniczenia a rozwój wyższej niezawodności nie musi być bardziej kosztowny. Ponadto argumentują, że przewidywanie niezawodności na podstawie danych historycznych może być bardzo mylące, a porównania są ważne tylko dla identycznych projektów, produktów, procesów produkcyjnych i konserwacji przy identycznych obciążeniach operacyjnych i środowiskach użytkowania. Nawet niewielkie zmiany któregokolwiek z nich mogą mieć duży wpływ na niezawodność. Co więcej, najbardziej niewiarygodne i ważne pozycje (tj. najciekawsi kandydaci do badania wiarygodności) najprawdopodobniej zostaną zmodyfikowane i przeprojektowane od czasu zgromadzenia danych historycznych, czyniąc standardowe (reaktywne lub proaktywne) metody statystyczne i procesy stosowane np. w branży medycznej czy ubezpieczeniowej są mniej efektywne. Kolejnym zaskakującym – ale logicznym – argumentem jest to, że aby móc dokładnie przewidzieć niezawodność za pomocą testów, należy znać dokładny mechanizm awarii, a zatem – w większości przypadków – można jej zapobiec! Podążanie niewłaściwą drogą prób ilościowego określenia i rozwiązania złożonego problemu inżynierii niezawodności pod względem MTBF lub prawdopodobieństwa przy użyciu niewłaściwego - na przykład podejścia reaktywnego - jest określane przez Barnarda jako „gra w grę liczbową” i jest uważane jako zła praktyka.

W przypadku istniejących systemów można argumentować, że jakakolwiek próba skorygowania pierwotnej przyczyny wykrytych awarii przez odpowiedzialny program może unieważnić wstępne oszacowanie MTBF, ponieważ należy przyjąć nowe założenia (które same w sobie są obciążone wysokim poziomem błędu) dotyczące efektu tej korekty . Innym praktycznym problemem jest ogólna niedostępność szczegółowych danych o awariach, przy czym te dostępne często charakteryzują się niespójnym filtrowaniem danych o awariach (informacje zwrotne) i ignorowaniem błędów statystycznych (które są bardzo wysokie w przypadku rzadkich zdarzeń, takich jak awarie związane z niezawodnością). Muszą istnieć bardzo jasne wytyczne, aby policzyć i porównać awarie związane z różnymi rodzajami przyczyn źródłowych (np. awarie produkcyjne, konserwacyjne, transportowe, spowodowane przez system lub nieodłączne awarie projektowe). Porównywanie różnych typów przyczyn może prowadzić do błędnych szacunków i błędnych decyzji biznesowych dotyczących tego, na czym należy się skupić.

Przeprowadzenie właściwej ilościowej prognozy niezawodności systemów może być trudne i bardzo kosztowne, jeśli odbywa się za pomocą testów. Na poziomie poszczególnych części wyniki niezawodności często można uzyskać ze stosunkowo dużą pewnością, ponieważ testowanie wielu przykładowych części może być możliwe przy wykorzystaniu dostępnego budżetu na testy. Jednak niestety testy te mogą nie być trafne na poziomie systemu ze względu na założenia przyjęte podczas testowania na poziomie części. Autorzy ci podkreślali znaczenie wstępnego testowania na poziomie części lub systemu aż do awarii oraz wyciągania wniosków z takich awarii w celu ulepszenia systemu lub części. Ogólny wniosek jest taki, że dokładne i bezwzględne przewidywanie – poprzez porównanie danych terenowych lub testowanie – w większości przypadków nie jest możliwe. Wyjątkiem mogą być awarie spowodowane problemami związanymi ze zużyciem, takimi jak awarie zmęczeniowe. We wstępie do MIL-STD-785 napisano, że przewidywanie niezawodności powinno być stosowane z dużą ostrożnością, jeśli nie jest używane wyłącznie do porównań w badaniach kompromisów.

Konstrukcja zapewniająca niezawodność

Projektowanie pod kątem niezawodności (DfR) to proces obejmujący narzędzia i procedury zapewniające, że produkt spełnia wymagania dotyczące niezawodności w środowisku użytkowania przez cały okres jego użytkowania. DfR jest wdrażany na etapie projektowania produktu w celu proaktywnej poprawy niezawodności produktu. DfR jest często używany jako część ogólnej Design for Excellence (DfX) .

Podejście oparte na statystykach (tj. MTBF)

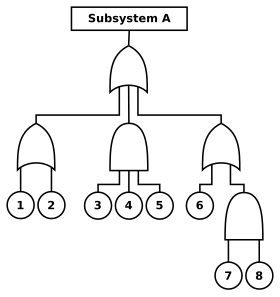

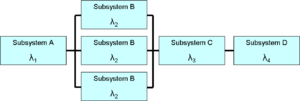

Projektowanie niezawodności rozpoczyna się od opracowania modelu (systemu) . Modele niezawodności i dostępności wykorzystują diagramy blokowe i analizę drzewa błędów w celu zapewnienia graficznego sposobu oceny relacji między różnymi częściami systemu. Modele te mogą zawierać prognozy oparte na wskaźnikach awaryjności zaczerpniętych z danych historycznych. Chociaż prognozy (danych wejściowych) często nie są dokładne w sensie bezwzględnym, są cenne przy ocenie względnych różnic w alternatywnych projektach. Parametry łatwości utrzymania, na przykład średni czas naprawy (MTTR), mogą być również używane jako dane wejściowe dla takich modeli.

Za pomocą narzędzi inżynierskich należy zidentyfikować i przeanalizować najważniejsze podstawowe przyczyny inicjujące i mechanizmy awarii. Projektantom należy zapewnić zróżnicowany zestaw praktycznych wskazówek dotyczących wydajności i niezawodności, aby mogli tworzyć projekty i produkty o niskim obciążeniu, które chronią lub są chronione przed uszkodzeniami i nadmiernym zużyciem. Może być potrzebna właściwa walidacja obciążeń wejściowych (wymagań), oprócz weryfikacji „wydajności” niezawodności za pomocą testów.

Jedną z najważniejszych technik projektowania jest redundancja . Oznacza to, że jeśli jedna część systemu ulegnie awarii, istnieje alternatywna ścieżka sukcesu, na przykład system zapasowy. Powód, dla którego jest to ostateczny wybór projektowy, jest związany z faktem, że wysoce wiarygodne dowody niezawodności dla nowych części lub systemów są często niedostępne lub ich uzyskanie jest niezwykle kosztowne. Łącząc redundancję z wysokim poziomem monitorowania awarii i unikaniem awarii o wspólnej przyczynie; nawet system o stosunkowo słabej niezawodności pojedynczego kanału (części) może być wysoce niezawodny na poziomie systemu (aż do niezawodności krytycznej). W tym celu nie trzeba przeprowadzać testów niezawodności. W połączeniu z redundancją stosowanie odmiennych projektów lub procesów produkcyjnych (np. za pośrednictwem różnych dostawców podobnych części) dla pojedynczych niezależnych kanałów może zapewnić mniejszą wrażliwość na kwestie jakości (np. awarie we wczesnym dzieciństwie u jednego dostawcy), umożliwiając bardzo wysokie poziomy niezawodności, które należy osiągnąć we wszystkich momentach cyklu rozwojowego (od wczesnych lat życia do długoterminowego). Redundancję można również zastosować w inżynierii systemów poprzez podwójne sprawdzanie wymagań, danych, projektów, obliczeń, oprogramowania i testów w celu przezwyciężenia systematycznych awarii.

Innym skutecznym sposobem radzenia sobie z problemami z niezawodnością jest wykonywanie analiz przewidujących degradację, umożliwiających zapobieganie nieplanowanym przestojom/awariom. Można do tego celu wykorzystać programy RCM (Reliability Centered Maintenance).

Podejście oparte na fizyce awarii

W przypadku zespołów elektronicznych nastąpiła coraz większa zmiana w kierunku innego podejścia zwanego fizyką awarii . Technika ta opiera się na zrozumieniu fizycznych, statycznych i dynamicznych mechanizmów awarii. Uwzględnia zmienność obciążenia, wytrzymałości i naprężeń, które prowadzą do awarii, przy wysokim poziomie szczegółowości, co jest możliwe dzięki zastosowaniu nowoczesnych programów wykorzystujących metodę elementów skończonych (MES), które mogą obsługiwać złożone geometrie i mechanizmy, takie jak pełzanie, relaksacja naprężeń , zmęczenie i probabilistyczny plan ( Metody Monte Carlo /ŁANIA). Materiał lub komponent można przeprojektować, aby zmniejszyć prawdopodobieństwo awarii i uczynić go bardziej odpornym na takie zmiany. Inną powszechną techniką projektowania jest obniżanie parametrów znamionowych komponentów : tj. wybieranie komponentów, których specyfikacje znacznie przekraczają oczekiwane poziomy naprężeń, na przykład przy użyciu przewodów elektrycznych o większej grubości, niż można by normalnie określić dla oczekiwanego prądu elektrycznego .

Wspólne narzędzia i techniki

Wiele zadań, technik i analiz stosowanych w inżynierii niezawodności jest specyficznych dla określonych branż i zastosowań, ale często mogą obejmować:

- Fizyka awarii (PoF)

- Wbudowany autotest (BIT) (analiza testowalności)

- Analiza przyczyn i skutków awarii (FMEA)

- Analiza zagrożeń niezawodności

- Analiza schematu blokowego niezawodności

- Dynamiczna analiza schematu blokowego niezawodności

- Analiza drzewa błędów

- Analiza przyczyn

- Inżynieria statystyczna, projektowanie eksperymentów – np. na symulacjach / modelach MES lub z testowaniem

- Analiza obwodów podstępnych

- Testy przyspieszone

- Analiza wzrostu niezawodności (niezawodność reaktywna)

- Weibulla (do testowania lub głównie niezawodności „reaktywnej”)

- Analiza termiczna metodą elementów skończonych (MES) i/lub pomiar

- cieplnego, uderzeniowego i wibracyjnego metodą MES i/lub pomiarem

- Analiza elektromagnetyczna

- Unikanie pojedynczego punktu awarii (SPOF)

- Analiza funkcjonalna i analiza awarii funkcjonalnych (np. funkcja FMEA, FHA lub FFA)

- Konserwacja predykcyjna i zapobiegawcza: analiza konserwacji zorientowanej na niezawodność (RCM).

- Analiza testowalności

- Analiza diagnostyki awarii (zwykle również uwzględniona w FMEA)

- Analiza błędów ludzkich

- Analiza zagrożeń operacyjnych

- Optymalizacja konserwacji zapobiegawczej/planowej (PMO)

- Ręczne sprawdzanie

- Zintegrowane wsparcie logistyczne

Wyniki tych metod są prezentowane podczas przeglądów projektu części lub systemu oraz logistyki. Niezawodność to tylko jedno z wielu wymagań stawianych złożonej części lub systemowi. Inżynieryjne badania kompromisów są wykorzystywane do określenia optymalnej równowagi między wymaganiami dotyczącymi niezawodności a innymi ograniczeniami.

Znaczenie języka

Inżynierowie zajmujący się niezawodnością, niezależnie od tego, czy używają metod ilościowych, czy jakościowych do opisania awarii lub zagrożenia, polegają na języku, aby wskazać ryzyko i umożliwić rozwiązanie problemów. Zastosowany język musi pomóc w stworzeniu uporządkowanego opisu funkcji/przedmiotu/systemu i jego złożonego otoczenia w odniesieniu do awarii tych funkcji/przedmiotów/systemów. Inżynieria systemów polega w dużej mierze na znalezieniu odpowiednich słów do opisania problemu (i związanych z nim zagrożeń), tak aby można je było łatwo rozwiązać za pomocą rozwiązań inżynierskich. Jack Ring powiedział, że zadaniem inżyniera systemowego jest „język projektu”. (Ring i in. 2000) W przypadku awarii części/systemu inżynierowie zajmujący się niezawodnością powinni bardziej skoncentrować się na „dlaczego i jak”, a nie na przewidywaniu „kiedy”. Zrozumienie „dlaczego” wystąpiła awaria (np. z powodu nadmiernie obciążonych komponentów lub problemów produkcyjnych) z większym prawdopodobieństwem doprowadzi do udoskonalenia stosowanych projektów i procesów niż określenie ilościowe „kiedy” awaria może wystąpić (np. poprzez określenie MTBF ). Aby to zrobić, należy najpierw sklasyfikować i uporządkować zagrożenia niezawodności związane z częścią/systemem (w miarę możliwości w oparciu o jakąś formę logiki jakościowej i ilościowej), aby umożliwić skuteczniejszą ocenę i ewentualną poprawę. Odbywa się to częściowo czystym językiem i propozycji , ale także oparta na doświadczeniu z podobnymi przedmiotami. Można to zobaczyć na przykład w opisach zdarzeń w analizie drzewa błędów , analizie FMEA i dziennikach zagrożeń (śledzenia). W tym sensie język i poprawna gramatyka (część analizy jakościowej) odgrywa ważną rolę w inżynierii niezawodności, podobnie jak ma to miejsce w inżynierii bezpieczeństwa czy ogólnie w inżynierii systemów .

Prawidłowe użycie języka może być również kluczem do zidentyfikowania lub zmniejszenia ryzyka błędu ludzkiego , który często jest podstawową przyczyną wielu niepowodzeń. Może to obejmować odpowiednie instrukcje w instrukcjach konserwacji, instrukcjach obsługi, procedurach awaryjnych i innych, aby zapobiec systematycznym błędom ludzkim, które mogą skutkować awariami systemu. Powinny one być napisane przez przeszkolonych lub doświadczonych autorów technicznych, używając tak zwanego uproszczonego języka angielskiego lub uproszczonego technicznego języka angielskiego , gdzie słowa i struktura są specjalnie dobrane i stworzone tak, aby zmniejszyć dwuznaczność lub ryzyko pomyłki (np. „wymiana starej części” może niejednoznacznie odnosić się do zamiany zużytej części na niezużytą lub wymiany część z częścią wykorzystującą nowszy i miejmy nadzieję ulepszony projekt).

Modelowanie niezawodności

Modelowanie niezawodności to proces przewidywania lub zrozumienia niezawodności komponentu lub systemu przed jego wdrożeniem. Dwa rodzaje analiz, które są często używane do modelowania zachowania dostępności całego systemu, w tym skutków problemów logistycznych, takich jak dostarczanie części zamiennych, transport i siła robocza, to analiza drzewa usterek i diagramy blokowe niezawodności . Na poziomie komponentu te same typy analiz mogą być używane razem z innymi. Dane wejściowe dla modeli mogą pochodzić z wielu źródeł, w tym z testów; wcześniejsze doświadczenie operacyjne; dane terenowe; a także podręczniki danych z podobnych lub pokrewnych branż. Niezależnie od źródła, wszystkie dane wejściowe modelu muszą być używane z dużą ostrożnością, ponieważ prognozy są ważne tylko w przypadkach, gdy ten sam produkt został użyty w tym samym kontekście. W związku z tym prognozy są często używane tylko do porównywania alternatyw.

W przypadku prognoz na poziomie części wspólne są dwa oddzielne obszary badań:

- fizyce uszkodzeń wykorzystuje zrozumienie fizycznych mechanizmów uszkodzeń, takich jak propagacja pęknięć mechanicznych lub degradacja lub uszkodzenie spowodowane korozją chemiczną;

- Podejście do modelowania naprężeń części jest empiryczną metodą przewidywania opartą na liczeniu liczby i rodzaju elementów systemu oraz naprężeń, którym podlegają podczas eksploatacji.

Teoria niezawodności

Niezawodność definiuje się jako prawdopodobieństwo , że urządzenie będzie wykonywać swoją zamierzoną funkcję w określonym czasie w określonych warunkach. Matematycznie można to wyrazić jako:

gdzie funkcją gęstości prawdopodobieństwa jest długością czasu (który zakłada się, że zaczyna się od czasu

Istnieje kilka kluczowych elementów tej definicji:

- Niezawodność opiera się na „zamierzonej funkcji”: ogólnie przyjmuje się, że oznacza to działanie bez awarii. Jednak nawet jeśli żadna pojedyncza część systemu nie zawiedzie, ale system jako całość nie działa zgodnie z przeznaczeniem, to i tak jest to obciążone niezawodnością systemu. Specyfikacja wymagań systemowych jest kryterium, według którego mierzona jest niezawodność.

- Niezawodność dotyczy określonego okresu czasu. W praktyce oznacza to, że system ma określoną szansę, że będzie działał bezawaryjnie przed Inżynieria niezawodności zapewnia, że komponenty i materiały spełnią wymagania w określonym czasie. Należy zauważyć, że czasami mogą być używane jednostki inne niż czas (np. „misja”, „cykle operacji”).

- Niezawodność jest ograniczona do działania w określonych (lub wyraźnie zdefiniowanych) warunkach. To ograniczenie jest konieczne, ponieważ niemożliwe jest zaprojektowanie systemu dla nieograniczonych warunków. Łazik marsjański będzie miał inne określone warunki niż samochód rodzinny. Podczas projektowania i testowania należy uwzględnić środowisko operacyjne. Ten sam łazik może wymagać działania w różnych warunkach, co wymaga dodatkowej kontroli.

- Dwa godne uwagi odniesienia dotyczące teorii niezawodności oraz jej matematycznych i statystycznych podstaw to Barlow, RE i Proschan, F. (1982) oraz Samaniego, FJ (2007).

Ilościowe parametry niezawodności systemu — teoria

Wymagania ilościowe określane są za pomocą parametrów niezawodnościowych . Najczęstszym parametrem niezawodności jest średni czas do awarii (MTTF), który można również określić jako wskaźnik awaryjności (jest to wyrażone jako częstotliwość lub funkcja gęstości prawdopodobieństwa warunkowego (PDF)) lub liczba awarii w danym okresie. Parametry te mogą być przydatne w systemach wyższych poziomów i systemach, które są często eksploatowane (tj. pojazdy, maszyny i sprzęt elektroniczny). Niezawodność wzrasta wraz ze wzrostem MTTF. MTTF jest zwykle podawany w godzinach, ale może być również używany z innymi jednostkami miary, takimi jak mile lub cykle. Używanie wartości MTTF na niższych poziomach systemu może być bardzo mylące, zwłaszcza jeśli nie określają powiązanych trybów i mechanizmów awarii (F w MTTF).

W innych przypadkach niezawodność jest określana jako prawdopodobieństwo powodzenia misji. Na przykład niezawodność zaplanowanego lotu statku powietrznego można określić jako bezwymiarowe prawdopodobieństwo lub procent, co jest często stosowane w inżynierii bezpieczeństwa systemów .

Szczególnym przypadkiem powodzenia misji jest jednostrzałowe urządzenie lub system. Są to urządzenia lub systemy, które pozostają względnie uśpione i działają tylko raz. Przykłady obejmują samochodowe poduszki powietrzne , baterie termiczne i pociski . Niezawodność pojedynczego strzału jest określana jako prawdopodobieństwo jednorazowego sukcesu lub jest zawarta w powiązanym parametrze. Niezawodność pocisku jednostrzałowego można określić jako wymóg dotyczący prawdopodobieństwa trafienia. W przypadku takich systemów prawdopodobieństwo awarii na żądanie (PFD) to miara niezawodności – w rzeczywistości jest to liczba „niedostępności”. PFD pochodzi ze wskaźnika awaryjności (częstotliwości występowania) i czasu misji dla systemów nienaprawialnych.

W przypadku systemów naprawialnych jest on uzyskiwany na podstawie wskaźnika awaryjności, średniego czasu naprawy (MTTR) i interwału testów. Miara ta może nie być unikalna dla danego systemu, ponieważ miara ta zależy od rodzaju zapotrzebowania. Oprócz wymagań na poziomie systemu, wymagania dotyczące niezawodności mogą być określone dla podsystemów krytycznych. W większości przypadków parametry niezawodności są określone z odpowiednimi statystycznymi przedziałami ufności .

Testy niezawodności

Celem testowania niezawodności jest wykrycie potencjalnych problemów z projektem tak wcześnie, jak to możliwe, a ostatecznie uzyskanie pewności, że system spełnia wymagania dotyczące niezawodności.

Testy niezawodności można przeprowadzać na kilku poziomach i istnieją różne rodzaje testów. Złożone systemy mogą być testowane na poziomie komponentów, płytek drukowanych, jednostek, zespołów, podsystemów i systemów. (Nomenklatura poziomów testów różni się w zależności od aplikacji). Na przykład przeprowadzanie przesiewowych warunków środowiskowych na niższych poziomach, takich jak części lub małe zespoły, wychwytuje problemy, zanim spowodują awarie na wyższych poziomach. Testowanie przebiega na każdym poziomie integracji poprzez pełne testowanie systemu, testowanie rozwojowe i testowanie operacyjne, zmniejszając w ten sposób ryzyko związane z programem. Jednak testowanie nie zmniejsza ryzyka zawodności.

W przypadku każdego testu można popełnić błąd statystyczny zarówno typu 1, jak i typu 2, i zależy to od wielkości próby, czasu testu, założeń i wymaganego współczynnika dyskryminacji. Istnieje ryzyko błędnego zaakceptowania złego projektu (błąd 1. rodzaju) oraz ryzyko błędnego odrzucenia dobrego projektu (błąd 2. rodzaju).

Nie zawsze jest możliwe przetestowanie wszystkich wymagań systemowych. Testowanie niektórych systemów jest zbyt drogie; obserwacja niektórych trybów awarii może zająć lata; niektóre złożone interakcje skutkują ogromną liczbą możliwych przypadków testowych; a niektóre testy wymagają użycia ograniczonych zakresów testowych lub innych zasobów. W takich przypadkach można zastosować różne podejścia do testowania, takie jak (wysoce) przyspieszone testy trwałości, projektowanie eksperymentów i symulacje .

Pożądany poziom pewności statystycznej również odgrywa rolę w testowaniu niezawodności. Pewność statystyczną zwiększa się, zwiększając czas testu lub liczbę testowanych elementów. Plany testów niezawodności mają na celu osiągnięcie określonej niezawodności przy określonym poziomie ufności przy minimalnej liczbie jednostek testowych i czasie testowania. Różne plany testów skutkują różnymi poziomami ryzyka dla producenta i konsumenta. Pożądana niezawodność, pewność statystyczna i poziomy ryzyka dla każdej ze stron wpływają na ostateczny plan testów. Klient i programista powinni z góry uzgodnić, w jaki sposób zostaną przetestowane wymagania dotyczące niezawodności.

Kluczowym aspektem testowania niezawodności jest zdefiniowanie „niepowodzenia”. Choć może się to wydawać oczywiste, istnieje wiele sytuacji, w których nie jest jasne, czy awaria jest rzeczywiście winą systemu. Różnice w warunkach testowych, różnice między operatorami, pogoda i nieoczekiwane sytuacje powodują różnice między klientem a twórcą systemu. Jedną ze strategii rozwiązania tego problemu jest użycie procesu konferencji oceniającej. W konferencji oceniającej biorą udział przedstawiciele klienta, dewelopera, organizacji testowej, organizacji zajmującej się niezawodnością, a czasem także niezależni obserwatorzy. Proces konferencji scoringowej jest zdefiniowany w zestawieniu prac. Każdy przypadek testowy jest rozpatrywany przez grupę i „punktowany” jako sukces lub porażka. Ta punktacja jest oficjalnym wynikiem używanym przez inżyniera ds. niezawodności.

W ramach fazy wymagań inżynier ds. niezawodności opracowuje wraz z klientem strategię testów. Strategia testowania zawiera kompromisy między potrzebami organizacji zajmującej się niezawodnością, która chce jak największej ilości danych, a ograniczeniami, takimi jak koszt, harmonogram i dostępne zasoby. Dla każdego testu niezawodności opracowywane są plany i procedury testów, a wyniki są dokumentowane.

Testy niezawodności są powszechne w branży fotoniki. Przykładami testów niezawodności laserów są testy żywotności i wypalania . Testy te polegają na bardzo przyspieszonym starzeniu, w kontrolowanych warunkach, grupy laserów. Dane zebrane z tych testów żywotności służą do przewidywania oczekiwanej żywotności lasera przy zamierzonych parametrach operacyjnych.

Wymagania testu niezawodności

Wymagania dotyczące testu niezawodności mogą wynikać z dowolnej analizy, dla której należy uzasadnić pierwsze oszacowanie prawdopodobieństwa awarii, rodzaju awarii lub skutku. Dowody mogą być generowane z pewnym poziomem pewności poprzez testowanie. W przypadku systemów opartych na oprogramowaniu prawdopodobieństwo jest połączeniem awarii oprogramowania i sprzętu. Testowanie wymagań niezawodności jest problematyczne z kilku powodów. Pojedynczy test jest w większości przypadków niewystarczający do wygenerowania wystarczającej ilości danych statystycznych. Wielokrotne testy lub testy długotrwałe są zwykle bardzo drogie. Niektóre testy są po prostu niepraktyczne, a warunki środowiskowe mogą być trudne do przewidzenia w całym cyklu życia systemu.

Inżynieria niezawodności jest wykorzystywana do zaprojektowania realistycznego i niedrogiego programu testowego, który dostarcza empirycznych dowodów na to, że system spełnia wymagania dotyczące niezawodności. W celu rozwiązania niektórych z tych problemów stosuje się statystyczne poziomy ufności . Określony parametr jest wyrażany wraz z odpowiednim poziomem ufności: na przykład MTBF wynoszący 1000 godzin przy 90% poziomie ufności. Na podstawie tej specyfikacji inżynier ds. niezawodności może na przykład zaprojektować test z wyraźnymi kryteriami dotyczącymi liczby godzin i liczby awarii do momentu spełnienia lub niepowodzenia wymagania. Możliwe są różne rodzaje testów.

Połączenie wymaganego poziomu niezawodności i wymaganego poziomu ufności ma ogromny wpływ na koszty rozwoju i ryzyko zarówno dla klienta, jak i producenta. Należy zachować ostrożność, aby wybrać najlepszą kombinację wymagań — np. opłacalność. Testy niezawodności można przeprowadzać na różnych poziomach, takich jak moduł, podsystem i system . Ponadto podczas testowania i eksploatacji należy wziąć pod uwagę wiele czynników, takich jak ekstremalna temperatura i wilgotność, wstrząsy, wibracje lub inne czynniki środowiskowe (takie jak utrata sygnału, chłodzenia lub zasilania; lub inne katastrofy, takie jak pożar, powodzie, nadmierne ciepło, fizyczne lub naruszenia bezpieczeństwa lub inne niezliczone formy uszkodzeń lub degradacji). W przypadku systemów, które muszą działać przez wiele lat, mogą być potrzebne przyspieszone testy żywotności.

Testy przyspieszone

Celem przyspieszonego testowania żywotności (test ALT) jest wywołanie awarii w terenie w laboratorium w znacznie szybszym tempie poprzez zapewnienie ostrzejszego, ale mimo to reprezentatywnego środowiska. W takim teście oczekuje się, że produkt zawiedzie w laboratorium, tak jak zawiódłby w terenie — ale w znacznie krótszym czasie. Głównym celem przyspieszonego testu jest jedno z poniższych:

- Aby odkryć tryby awarii

- Aby przewidzieć normalne życie w terenie na podstawie życia w warunkach dużego stresu w laboratorium

Przyspieszony program testowania można podzielić na następujące kroki:

- Zdefiniuj cel i zakres testu

- Zbierz wymagane informacje o produkcie

- Zidentyfikuj stres(y)

- Określ poziom stresu(ów)

- Przeprowadź przyspieszony test i przeanalizuj zebrane dane.

Typowe sposoby określania związku stresu życiowego to:

- modelu Arrheniusa

- modelu Eyringa

- Model odwrotnego prawa potęgowego

- Model temperatura-wilgotność

- Model temperaturowy nietermiczny

Niezawodność oprogramowania

Niezawodność oprogramowania jest szczególnym aspektem inżynierii niezawodności. Koncentruje się na podstawach i technikach zwiększania niezawodności oprogramowania, tj. odporności na błędy. Niezawodność systemu z definicji obejmuje wszystkie części systemu, w tym sprzęt, oprogramowanie, infrastrukturę wspierającą (w tym krytyczne interfejsy zewnętrzne), operatorów i procedury. Tradycyjnie inżynieria niezawodności koncentruje się na krytycznych elementach sprzętowych systemu. Od czasu powszechnego stosowania cyfrowych układów scalonych technologia, oprogramowanie staje się coraz bardziej krytyczną częścią większości elektroniki, a co za tym idzie, prawie wszystkich współczesnych systemów. Dlatego niezawodność oprogramowania zyskała na znaczeniu w dziedzinie niezawodności systemu.

Istnieją jednak znaczne różnice w zachowaniu oprogramowania i sprzętu. Większość zawodności sprzętu wynika z awarii elementu lub materiału, w wyniku której system nie wykonuje zamierzonej funkcji. Naprawa lub wymiana elementu sprzętowego przywraca system do pierwotnego stanu operacyjnego. Jednak oprogramowanie nie zawodzi w tym samym sensie, w jakim zawodzi sprzęt. Zamiast tego, zawodność oprogramowania jest wynikiem nieoczekiwanych wyników działania oprogramowania. Nawet stosunkowo małe programy mogą mieć astronomicznie duże kombinacje wejść i stanów, których nie da się wyczerpująco przetestować. Przywracanie oprogramowania do jego pierwotnego stanu działa tylko do momentu, gdy ta sama kombinacja danych wejściowych i stanów skutkuje tym samym niezamierzonym rezultatem. Inżynieria niezawodności oprogramowania musi to uwzględniać.

Pomimo tej różnicy w źródle awarii między oprogramowaniem a sprzętem, zaproponowano kilka modeli niezawodności oprogramowania opartych na statystykach, aby określić ilościowo to, czego doświadczamy z oprogramowaniem: im dłużej oprogramowanie jest uruchomione, tym większe jest prawdopodobieństwo, że ostatecznie zostanie użyte w nieprzetestowanym sposób i wykazują ukrytą wadę, która skutkuje awarią (Shooman 1987), (Musa 2005), (Denney 2005).

Podobnie jak w przypadku sprzętu, niezawodność oprogramowania zależy od dobrych wymagań, projektu i wdrożenia. Inżynieria niezawodności oprogramowania w dużej mierze opiera się na zdyscyplinowanym inżynierii oprogramowania , który pozwala przewidywać i projektować zabezpieczenia przed niezamierzonymi konsekwencjami . Inżynieria jakości oprogramowania i inżynieria niezawodności oprogramowania bardziej się pokrywają niż jakość sprzętu i niezawodność. Dobry plan rozwoju oprogramowania jest kluczowym aspektem programu niezawodności oprogramowania. Plan rozwoju oprogramowania opisuje standardy projektowe i kodowania, wzajemne recenzje , testy jednostkowe , zarządzanie konfiguracją , metryki oprogramowania i modele oprogramowania do wykorzystania podczas tworzenia oprogramowania.

Powszechną miarą niezawodności jest liczba błędów oprogramowania na linię kodu (FLOC), zwykle wyrażana jako liczba błędów na tysiąc linii kodu. Ta miara, wraz z czasem wykonania oprogramowania, jest kluczem do większości modeli i szacunków niezawodności oprogramowania. Teoria głosi, że niezawodność oprogramowania wzrasta wraz ze spadkiem liczby błędów (lub gęstości błędów). Ustanowienie bezpośredniego związku między gęstością błędów a średnim czasem między awariami jest jednak trudne ze względu na sposób, w jaki błędy oprogramowania są rozmieszczone w kodzie, ich dotkliwość oraz prawdopodobieństwo kombinacji danych wejściowych niezbędnych do napotkania błędu. Niemniej jednak gęstość uszkodzeń służy jako użyteczny wskaźnik dla inżyniera ds. niezawodności. Wykorzystywane są również inne metryki oprogramowania, takie jak złożoność. Ta miara pozostaje kontrowersyjna, ponieważ zmiany w praktykach tworzenia i weryfikacji oprogramowania mogą mieć dramatyczny wpływ na ogólne wskaźniki defektów.

Testowanie oprogramowania jest ważnym aspektem niezawodności oprogramowania. Nawet najlepszy proces tworzenia oprogramowania powoduje, że niektóre błędy oprogramowania są prawie niewykrywalne, dopóki nie zostaną przetestowane. Oprogramowanie testowane jest na kilku poziomach, począwszy od pojedynczych jednostek , poprzez integrację , aż po pełne testy systemowe . Wszystkie fazy testowania, błędy oprogramowania są wykrywane, poprawiane i ponownie testowane. Szacunki niezawodności są aktualizowane na podstawie gęstości błędów i innych metryk. Na poziomie systemu można gromadzić dane dotyczące średniego czasu między awariami i wykorzystywać je do szacowania niezawodności. W przeciwieństwie do sprzętu, wykonanie dokładnie tego samego testu na dokładnie tej samej konfiguracji oprogramowania nie zapewnia zwiększonej pewności statystycznej. Zamiast tego niezawodność oprogramowania wykorzystuje różne wskaźniki, takie jak pokrycie kodem .

Model dojrzałości zdolności Software Engineering Institute jest powszechnym sposobem oceny całego procesu tworzenia oprogramowania pod kątem niezawodności i jakości.

Niezawodność strukturalna

Niezawodność konstrukcji lub niezawodność konstrukcji polega na zastosowaniu teorii niezawodności do zachowania konstrukcji . Znajduje zastosowanie zarówno przy projektowaniu, jak i konserwacji różnego rodzaju konstrukcji, w tym konstrukcji betonowych i stalowych. W badaniach niezawodności konstrukcji zarówno obciążenia, jak i opory są modelowane jako zmienne probabilistyczne. Za pomocą tego podejścia oblicza się prawdopodobieństwo zniszczenia konstrukcji.

Porównanie z inżynierią bezpieczeństwa

Niezawodność dla bezpieczeństwa i niezawodność dla dostępności są często ściśle ze sobą powiązane. Utrata dostępności systemu inżynierskiego może kosztować. Jeśli system metra jest niedostępny, operator metra traci pieniądze za każdą godzinę awarii systemu. Operator metra straci więcej pieniędzy, jeśli zostanie naruszone bezpieczeństwo. Definicja niezawodności związana jest z prawdopodobieństwem nie napotkania awarii. Awaria może spowodować utratę bezpieczeństwa, utratę dostępności lub jedno i drugie. Utrata bezpieczeństwa lub dostępności w krytycznym systemie jest niepożądana.

Inżynieria niezawodności dotyczy ogólnej minimalizacji awarii, które mogą prowadzić do strat finansowych dla podmiotu odpowiedzialnego, podczas gdy inżynieria bezpieczeństwa koncentruje się na minimalizacji określonego zestawu rodzajów awarii, które ogólnie mogą prowadzić do utraty życia, obrażeń ciała lub uszkodzenia sprzętu.

Zagrożenia niezawodności mogą przekształcić się w incydenty prowadzące do utraty przychodów dla firmy lub klienta, na przykład z powodu kosztów bezpośrednich i pośrednich związanych z: utratą produkcji z powodu niedostępności systemu; niespodziewanie wysokie lub niskie zapotrzebowanie na części zamienne; koszty naprawy; roboczogodziny; przeprojektowania lub przerwy w normalnej produkcji.

Inżynieria bezpieczeństwa jest często bardzo specyficzna i odnosi się tylko do niektórych ściśle regulowanych branż, zastosowań lub obszarów. Skupia się przede wszystkim na zagrożeniach bezpieczeństwa systemu, które mogą prowadzić do poważnych wypadków, w tym: utraty życia; zniszczenie sprzętu; lub szkody w środowisku. W związku z tym wymagania dotyczące niezawodności funkcjonalnej systemu są często bardzo wysokie. Chociaż zajmuje się niepożądanymi awariami w takim samym sensie, jak inżynieria niezawodności, to jednak w mniejszym stopniu koncentruje się na kosztach bezpośrednich i nie zajmuje się naprawami po awarii. Kolejną różnicą jest poziom wpływu awarii na społeczeństwo, co prowadzi do tendencji do ścisłej kontroli ze strony rządów lub organów regulacyjnych (np. przemysł jądrowy, lotniczy, obronny, kolejowy i naftowy).

Tolerancja błędów

Bezpieczeństwo można zwiększyć za pomocą redundantnego systemu sprawdzania krzyżowego 2oo2. Dostępność można zwiększyć, stosując redundancję „1oo2” (1 z 2) na poziomie części lub systemu. Jeśli oba redundantne elementy nie zgadzają się, element bardziej liberalny zmaksymalizuje dostępność. Nigdy nie należy polegać na systemie 1oo2 ze względu na bezpieczeństwo. Systemy odporne na błędy często opierają się na dodatkowej redundancji (np. logika głosowania 2oo3 ), w której wiele redundantnych elementów musi uzgodnić potencjalnie niebezpieczną akcję przed jej wykonaniem. Zwiększa to zarówno dostępność, jak i bezpieczeństwo na poziomie systemu. Jest to powszechna praktyka w systemach lotniczych, które wymagają ciągłej dostępności i nie mają awaryjny . Na przykład statek powietrzny może wykorzystywać potrójną redundancję modułową dla komputerów pokładowych i powierzchni sterowych (w tym czasami różne tryby działania, np. elektryczne/mechaniczne/hydrauliczne), ponieważ muszą one zawsze działać ze względu na fakt, że nie ma „bezpiecznych” pozycji domyślnych powierzchni sterowych, takich jak stery lub lotki, gdy statek powietrzny leci.

Podstawowa niezawodność i niezawodność misji

Powyższy przykład systemu odpornego na uszkodzenia 2oo3 zwiększa zarówno niezawodność misji, jak i bezpieczeństwo. Jednak „podstawowa” niezawodność systemu będzie w tym przypadku nadal niższa niż systemu nieredundantnego (1oo1) lub 2oo2. Podstawowa inżynieria niezawodności obejmuje wszystkie awarie, w tym te, które mogą nie skutkować awarią systemu, ale powodują dodatkowe koszty z powodu: czynności konserwacyjnych, naprawczych; Logistyka; części zamienne itp. Na przykład wymiana lub naprawa 1 uszkodzonego kanału w systemie głosowania 2oo3 (system nadal działa, chociaż z jednym uszkodzonym kanałem faktycznie stał się systemem 2oo2) przyczynia się do podstawowej zawodności, ale nie do zawodności misji. Na przykład awaria tylnego światła samolotu nie uniemożliwi lotu samolotu (a zatem nie jest uważana za niepowodzenie misji), ale należy temu zaradzić (co wiąże się z kosztami, a zatem przyczynia się do podstawowe poziomy zawodności).

Wykrywalność i awarie spowodowane wspólną przyczyną

Podczas korzystania z systemów odpornych na awarie (redundantnych) lub systemów wyposażonych w funkcje zabezpieczające, wykrywalność awarii i unikanie awarii o wspólnej przyczynie staje się sprawą nadrzędną dla bezpiecznego funkcjonowania i/lub niezawodności misji.

Niezawodność a jakość (Six Sigma)

Jakość często koncentruje się na wadach produkcyjnych w fazie gwarancyjnej. Niezawodność dotyczy intensywności awarii w całym okresie eksploatacji produktu lub systemu inżynieryjnego, od uruchomienia do wycofania z eksploatacji. Six Sigma ma swoje korzenie w statystycznej kontroli jakości produkcji. Inżynieria niezawodności jest specjalną częścią inżynierii systemów. Proces inżynierii systemów jest procesem odkrywania, który często różni się od procesu produkcyjnego. Proces produkcyjny często koncentruje się na powtarzalnych czynnościach, które zapewniają wysoką jakość produktów przy minimalnych kosztach i czasie.

Codzienny termin „jakość produktu” jest luźno rozumiany jako jego nieodłączny stopień doskonałości. W przemyśle stosowana jest bardziej precyzyjna definicja jakości jako „zgodność z wymaganiami lub specyfikacjami na początku użytkowania”. Zakładając, że specyfikacja produktu końcowego odpowiednio oddaje pierwotne wymagania i potrzeby klienta/systemu, poziom jakości można zmierzyć jako ułamek wysłanych jednostek produktu, które spełniają specyfikacje. Jakość wytwarzanych towarów często koncentruje się na liczbie roszczeń gwarancyjnych w okresie gwarancyjnym.

Jakość jest migawką na początku życia przez okres gwarancji i jest związana z kontrolą specyfikacji produktu niższego poziomu. Obejmuje to defekty bezczasowe, tj. takie, w których błędy produkcyjne uniknęły końcowej kontroli jakości. Teoretycznie poziom jakości można opisać pojedynczym ułamkiem wadliwych produktów. Niezawodność, jako część inżynierii systemów, działa raczej jako ciągła ocena wskaźników awaryjności na przestrzeni wielu lat. Teoretycznie wszystkie elementy ulegną awarii w nieskończonym okresie czasu. Defekty, które pojawiają się w miarę upływu czasu, określane są mianem opadu niezawodności. Do opisania opadu niezawodności potrzebny jest model prawdopodobieństwa opisujący ułamkowy opad w czasie. Jest to znane jako model dystrybucji życia. Niektóre z tych problemów z niezawodnością mogą wynikać z nieodłącznych problemów konstrukcyjnych, które mogą występować nawet wtedy, gdy produkt jest zgodny ze specyfikacjami. Nawet produkty, które są produkowane perfekcyjnie, z czasem ulegną awarii z powodu jednego lub kilku mechanizmów awarii (np. z powodu błędu ludzkiego lub czynników mechanicznych, elektrycznych i chemicznych). Na te problemy z niezawodnością mogą również wpływać akceptowalne poziomy zmienności podczas początkowej produkcji.

Jakość i niezawodność są zatem związane z produkcją. Niezawodność jest bardziej ukierunkowana na klientów, którzy skupiają się na awariach przez cały okres użytkowania produktu, takich jak wojsko, linie lotnicze czy koleje. Przedmioty, które nie są zgodne ze specyfikacją produktu, generalnie wypadną gorzej pod względem niezawodności (mając niższy MTTF), ale nie zawsze tak musi być. Pełna matematyczna kwantyfikacja (w modelach statystycznych) tej złożonej relacji jest na ogół bardzo trudna lub wręcz niemożliwa. W przypadkach, w których odchylenia produkcyjne można skutecznie zmniejszyć, narzędzia Six Sigma okazały się przydatne w znajdowaniu optymalnych rozwiązań procesowych, które mogą zwiększyć jakość i niezawodność. Six Sigma może również pomóc w projektowaniu produktów, które są bardziej odporne na awarie wywołane produkcją i wady związane ze śmiertelnością niemowląt w systemach inżynieryjnych i wytwarzanym produkcie.

W przeciwieństwie do Six Sigma, rozwiązania z zakresu inżynierii niezawodności są generalnie znajdowane poprzez skupienie się na testowaniu niezawodności i projektowaniu systemu. Rozwiązania można znaleźć na różne sposoby, na przykład poprzez uproszczenie systemu, aby umożliwić zrozumienie większej liczby mechanizmów awarii; wykonanie szczegółowych obliczeń poziomów naprężeń materiałowych pozwalających na określenie odpowiednich współczynników bezpieczeństwa; znalezienie możliwych nienormalnych warunków obciążenia systemu i wykorzystanie ich do zwiększenia odporności projektu na mechanizmy awarii związane z wariancjami produkcyjnymi. Ponadto inżynieria niezawodności wykorzystuje rozwiązania na poziomie systemu, takie jak projektowanie systemów redundantnych i odpornych na awarie w sytuacjach wymagających wysokiej dostępności (zob. inżynieria niezawodności a inżynieria bezpieczeństwa powyżej).

Uwaga: „Wada” w literaturze dotyczącej sześciu sigma/jakości nie jest tym samym, co „awaria” (awaria w terenie | np. pęknięty element) pod względem niezawodności. Six-sigma/wada jakości odnosi się generalnie do niezgodności z wymaganiami (np. podstawową funkcjonalnością lub kluczowym wymiarem). Elementy mogą jednak z czasem ulec awarii, nawet jeśli wszystkie te wymagania zostaną spełnione. Jakość generalnie nie dotyczy zadawania kluczowego pytania „czy wymagania są rzeczywiście poprawne?”, podczas gdy niezawodność tak.

Operacyjna ocena niezawodności

Po wyprodukowaniu systemów lub części inżynieria niezawodności próbuje monitorować, oceniać i korygować braki. Monitoring obejmuje elektroniczną i wizualną obserwację krytycznych parametrów zidentyfikowanych na etapie projektowania analizy drzewa błędów. Zbieranie danych w dużym stopniu zależy od charakteru systemu. Większość dużych organizacji ma kontroli jakości , które zbierają dane o awariach pojazdów, sprzętu i maszyn. Awarie produktów konsumenckich są często śledzone na podstawie liczby zwrotów. W przypadku systemów w stanie uśpienia lub w stanie gotowości konieczne jest ustanowienie formalnego programu nadzoru w celu kontroli i testowania losowych próbek. Wszelkie zmiany w systemie, takie jak modernizacje w terenie lub naprawy związane z wycofaniem, wymagają dodatkowych testów niezawodności w celu zapewnienia niezawodności modyfikacji. Ponieważ nie jest możliwe przewidzenie wszystkich trybów awarii danego systemu, zwłaszcza tych z udziałem człowieka, awarie będą się pojawiać. Program niezawodności obejmuje również systematykę analiza przyczyn źródłowych , która identyfikuje związki przyczynowe związane z awarią, tak aby można było wdrożyć skuteczne działania naprawcze. Jeśli to możliwe, awarie systemu i działania naprawcze są zgłaszane do organizacji zajmującej się inżynierią niezawodności.

Niektóre z najczęstszych metod stosowanych do oceny operacyjnej niezawodności to systemy zgłaszania awarii, analizy i działania naprawcze (FRACAS). To systematyczne podejście rozwija ocenę niezawodności, bezpieczeństwa i logistyki w oparciu o zgłaszanie awarii/incydentów, zarządzanie, analizę oraz działania korygujące/zapobiegawcze. Dzisiejsze organizacje przyjmują tę metodę i wykorzystują systemy komercyjne (takie jak internetowe aplikacje FRACAS), które umożliwiają im tworzenie repozytorium danych o awariach/incydentach, z którego można uzyskać statystyki w celu przeglądania dokładnych i autentycznych wskaźników niezawodności, bezpieczeństwa i jakości.

Niezwykle ważne jest, aby organizacja przyjęła wspólny system FRACAS dla wszystkich elementów końcowych. Powinien również umożliwiać uchwycenie wyników testów w praktyczny sposób. Brak przyjęcia jednego, łatwego w użyciu (pod względem łatwości wprowadzania danych dla inżynierów terenowych i warsztatowych) i łatwego w utrzymaniu zintegrowanego systemu prawdopodobnie doprowadzi do niepowodzenia samego programu FRACAS.

Niektóre z typowych danych wyjściowych z systemu FRACAS obejmują Field MTBF, MTTR, zużycie części zamiennych, wzrost niezawodności, rozkład awarii/incydentów według rodzaju, lokalizacji, numeru części, numeru seryjnego i objawu.

Wykorzystanie danych z przeszłości do przewidywania niezawodności nowych porównywalnych systemów/elementów może wprowadzać w błąd, ponieważ niezawodność jest funkcją kontekstu użytkowania i mogą na nią wpływać niewielkie zmiany w projekcie/produkcji.

Organizacje niezawodności

firma komercyjna lub agencja rządowa . Organizacja inżynierii niezawodności musi być spójna ze strukturą organizacyjną firmy . W przypadku małych, niekrytycznych systemów inżynieria niezawodności może być nieformalna. Wraz ze wzrostem złożoności pojawia się potrzeba formalnej funkcji niezawodności. Ponieważ niezawodność jest ważna dla klienta, klient może nawet określić pewne aspekty organizacji niezawodności.

Istnieje kilka typowych typów organizacji niezawodności. Kierownik projektu lub główny inżynier może bezpośrednio zatrudnić jednego lub więcej inżynierów niezawodności. W większych organizacjach zwykle istnieje organizacja ds. zapewnienia produktu lub specjalistyczna organizacja inżynierska , która może obejmować niezawodność, łatwość konserwacji , jakość , bezpieczeństwo, czynnik ludzki , logistykę itp. W takim przypadku inżynier ds. niezawodności podlega kierownikowi ds. zapewnienia produktu lub kierownikowi ds. inżynierii specjalistycznej .

W niektórych przypadkach firma może chcieć ustanowić niezależną organizację zajmującą się niezawodnością. Jest to pożądane, aby zapewnić, że niezawodność systemu, która jest często kosztowna i czasochłonna, nie zostanie nadmiernie zlekceważona z powodu presji budżetowej i harmonogramowej. W takich przypadkach inżynier ds. niezawodności pracuje na co dzień nad projektem, ale w rzeczywistości jest zatrudniony i opłacany przez oddzielną organizację w firmie.

Ponieważ inżynieria niezawodności ma kluczowe znaczenie dla wczesnego projektowania systemu, stało się powszechne, że inżynierowie niezawodności pracują jako część zintegrowanego zespołu produktowego .

Edukacja

Niektóre uniwersytety oferują stopnie naukowe z inżynierii niezawodności. Inni specjaliści od niezawodności zazwyczaj mają dyplom z fizyki uzyskany na uniwersytecie lub w college'u. Wiele programów inżynierskich oferuje kursy niezawodności, a niektóre uniwersytety mają całe programy inżynierii niezawodności. Inżynier ds. niezawodności musi być prawnie zarejestrowany jako inżynier zawodowy przez stan lub prowincję, ale nie wszyscy specjaliści ds. niezawodności są inżynierami. Inżynierowie niezawodności są potrzebni w systemach, w których bezpieczeństwo publiczne jest zagrożone. Istnieje wiele profesjonalnych konferencji i branżowych programów szkoleniowych dostępnych dla inżynierów zajmujących się niezawodnością. Istnieje kilka organizacji zawodowych dla inżynierów niezawodności, w tym American Society for Quality Reliability Division (ASQ-RD), the Towarzystwo Niezawodności IEEE , Amerykańskie Towarzystwo Jakości (ASQ) oraz Towarzystwo Inżynierów Niezawodności (SRE).

Grupa inżynierów przygotowała listę przydatnych narzędzi do inżynierii niezawodności. Należą do nich: oprogramowanie PTC Windchill, oprogramowanie RAM Commander, oprogramowanie RelCalc, Military Handbook 217 (Mil-HDBK-217), 217Plus oraz instrukcja NAVMAT P-4855-1A. Analiza niepowodzeń i sukcesów w połączeniu z procesem standardów jakości dostarcza również usystematyzowanych informacji do tworzenia świadomych projektów inżynierskich.

Zobacz też

- Niezawodność – Miara w inżynierii systemów

- Współczynnik bezpieczeństwa — Wytrzymałość systemu poza zamierzonym obciążeniem

- Poważne niepowodzenie — niepowodzenie z katastrofalnym wynikiem lub bez ostrzeżenia

- Analiza przyczyn i skutków awarii ( FMEA ) – Analiza potencjalnych awarii systemu

- Mechanika pękania - Dziedzina mechaniki badająca propagację pęknięć w materiałach

- Wysoce przyspieszony test żywotności — metodologia testów warunków skrajnych w celu zwiększenia niezawodności produktu

- Wysoce przyspieszony test warunków skrajnych

- Niezawodność człowieka — czynnik bezpieczeństwa, ergonomii i odporności systemu

- Inżynieria przemysłowa – Dział inżynierii zajmujący się optymalizacją złożonych procesów lub systemów

- Instytut Inżynierów Przemysłowych i Systemowych - Towarzystwo zawodowe wspierające zawód inżyniera przemysłowego

- Inżynieria logistyczna - Dziedzina inżynierii organizacji zakupów, transportu, magazynowania, dystrybucji i magazynowania

- Inżynieria wydajności – obejmuje techniki stosowane podczas cyklu życia rozwoju systemów oraz Wskaźnik wydajności – pomiar, który ocenia sukces organizacji

- Certyfikacja produktu – Zapewnienie wydajności i jakości

- Ogólna efektywność sprzętu — miara tego, jak dobrze wykorzystywana jest operacja produkcyjna

- RAMS – Inżynierska charakterystyka produktu lub systemu

- Niezawodność, dostępność i użyteczność – Jakość solidności sprzętu komputerowego

- Teoria niezawodności starzenia się i długowieczności – teoria biofizyki

- Inspekcja oparta na ryzyku — optymalny proces biznesowy konserwacji stosowany do sprawdzania sprzętu, takiego jak zbiorniki ciśnieniowe, wymienniki ciepła i rurociągi w zakładach przemysłowych

- Walidacja solidności

- Inżynieria bezpieczeństwa - proces włączania kontroli bezpieczeństwa do systemu informatycznego

- Testy niezawodności oprogramowania

- Mechanika ciał stałych – dział mechaniki zajmujący się materiałami stałymi i ich zachowaniem

- Fałszywy poziom wyłączenia – miara fałszywych aktywacji systemu bezpieczeństwa lub alarmowego

- Wytrzymałość materiałów – Zachowanie się ciał stałych poddawanych naprężeniom i odkształceniom

- Analiza naprężeniowo-wytrzymałościowa – narzędzie w inżynierii niezawodności; analiza wytrzymałości materiałów i interferencji naprężeń wywieranych na materiały, gdzie „materiały” niekoniecznie oznaczają surowce lub części, ale mogą być całym systemem Strony wyświetlające opisy danych wiki jako rozwiązanie

- Mechanika pęknięć strukturalnych - Dziedzina inżynierii budowlanej

- Cykle temperaturowe

- Rozkład Weibulla – Ciągły rozkład prawdopodobieństwa

-

N. Diaz, R. Pascual, F. Ruggeri, E. López Droguett (2017). „Modelowanie zasad zastępowania wieku w wielu skalach czasowych i stochastycznych profilach użytkowania”. Międzynarodowy Dziennik Ekonomiki Produkcji . 188 : 22–28. doi : 10.1016/j.ijpe.2017.03.009 .

{{ cite journal }}: CS1 maint: wiele nazwisk: lista autorów ( link )

Dalsza lektura

- Barlow, RE i Proscan, F. (1981) Statystyczna teoria niezawodności i testowania życia, na początek Press, Silver Springs, MD.

- Blanchard, Benjamin S. (1992), Logistics Engineering and Management (czwarte wydanie), Prentice-Hall, Inc., Englewood Cliffs, New Jersey.

- Breitler, Alan L. and Sloan, C. (2005), Proceedings of the American Institute of Aeronautics and Astronautics (AIAA) Air Force T&E Days Conference, Nashville, TN, grudzień 2005: Prognozowanie niezawodności systemu: w kierunku ogólnego podejścia za pomocą Sieć neuronowa.

- Ebeling, Charles E., (1997), Wprowadzenie do inżynierii niezawodności i łatwości konserwacji , McGraw-Hill Companies, Inc., Boston.

- Denney, Richard (2005) Sukces dzięki przypadkom użycia: inteligentna praca w celu zapewnienia jakości. Wydawnictwo Addison-Wesley Professional. ISBN. Omawia wykorzystanie inżynierii niezawodności oprogramowania w tworzeniu oprogramowania opartego na przypadkach użycia .

- Gano, Dean L. (2007), „Analiza przyczyn źródłowych Apollo” (wydanie trzecie), Apollonian Publications, LLC., Richland, Waszyngton

- Holmes, Oliver Wendell Sr. Arcydzieło diakona

- Horsburgh, Peter (2018), „5 nawyków niezwykłego inżyniera niezawodności”, Sieć niezawodności

- Kapur, KC i Lamberson, LR, (1977), Niezawodność w projektowaniu inżynierskim , John Wiley & Sons, Nowy Jork.