METEOR

METEOR ( Metric for Evaluation of Translation with Explicit ORdering ) to metryka służąca do oceny wyników tłumaczenia maszynowego . Metryka opiera się na średniej harmonicznej precyzji i przypominania jednogramowego , z wagą przypominania ważoną wyżej niż precyzja. Ma również kilka funkcji, których nie można znaleźć w innych metrykach, takich jak stemming i dopasowywanie synonimów , wraz ze standardowym dokładnym dopasowywaniem słów. Metryka została zaprojektowana w celu rozwiązania niektórych problemów występujących w bardziej popularnym BLEU metryki, a także zapewniają dobrą korelację z ludzką oceną na poziomie zdania lub segmentu. Różni się to od metryki BLEU tym, że BLEU szuka korelacji na poziomie korpusu.

Przedstawiono wyniki, które dają korelację do 0,964 z ludzką oceną na poziomie korpusu, w porównaniu z osiągnięciem BLEU na poziomie 0,817 na tym samym zbiorze danych . Na poziomie zdania maksymalna osiągnięta korelacja z ludzką oceną wyniosła 0,403.

Algorytm

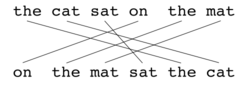

Podobnie jak w przypadku BLEU , podstawową jednostką oceny jest zdanie, algorytm najpierw tworzy wyrównanie ( patrz ilustracje) między dwoma zdaniami , kandydującym ciągiem tłumaczeniowym i referencyjnym ciągiem tłumaczeniowym. Wyrównanie to zestaw mapowań między unigramami . Odwzorowanie można traktować jako linię między unigramem w jednym łańcuchu a unigramem w innym łańcuchu. Ograniczenia są następujące; każdy unigram w tłumaczeniu kandydującym musi być odwzorowany na zero lub jeden unigram w referencji. Odwzorowania są wybierane w celu wytworzenia wyrównanie , jak zdefiniowano powyżej. Jeśli istnieją dwie linie trasowania z taką samą liczbą mapowań, wybierana jest linia trasowania z najmniejszą liczbą krzyżyków , to znaczy z mniejszą liczbą przecięć dwóch mapowań. Z dwóch pokazanych linii trasowania, w tym momencie wybrana zostanie linia trasowania (a). Etapy przebiegają kolejno, a każdy etap dodaje do wyrównania tylko te unigramy, które nie zostały dopasowane w poprzednich etapach. Po obliczeniu ostatecznego wyrównania wynik jest obliczany w następujący sposób: Precyzja Unigrama P jest obliczana jako:

| Moduł | Kandydat | Odniesienie | Mecz |

|---|---|---|---|

| Dokładny | Dobry | Dobry | Tak |

| Stemmer | Dobra | Dobry | Tak |

| Synonimia | Dobrze | Dobry | Tak |

Gdzie m to liczba unigramów w tłumaczeniu kandydującym, które znajdują się również w tłumaczeniu referencyjnym, a w tłumaczeniu kandydującym. Przywołanie Unigrama R jest obliczane jako:

Gdzie m jest powyżej, a unigramów w tłumaczeniu referencyjnym. Precyzja i przypominanie są łączone przy użyciu średniej harmonicznej w następujący sposób, z wagą przypominania 9 razy większą niż precyzja:

Środki, które zostały wprowadzone do tej pory, uwzględniają zgodność tylko w odniesieniu do pojedynczych słów, ale nie w odniesieniu do większych segmentów, które pojawiają się zarówno w zdaniu referencyjnym, jak i kandydującym. Aby to uwzględnić, do obliczenia kary p za wyrównanie stosuje się dłuższe dopasowania n -gramowe. Im więcej jest odwzorowań, które nie sąsiadują ze sobą w odwołaniu i zdaniu kandydującym, tym wyższa będzie kara.

Aby obliczyć tę karę, unigramy są pogrupowane w jak najmniejszą liczbę fragmentów , przy czym fragment jest zdefiniowany jako zestaw unigramów, które sąsiadują ze sobą w hipotezie iw referencji. Im dłuższe są sąsiednie odwzorowania między kandydatem a referencją, tym mniej fragmentów. Tłumaczenie, które jest identyczne z odniesieniem, da tylko jeden fragment. Kara p jest obliczana w następujący sposób:

Gdzie c to liczba kawałków, a zmapowanych unigramów Końcowy wynik segmentu jest obliczany jako M poniżej. Kara skutkuje zmniejszeniem ma bigramu lub dłuższych

Aby obliczyć wynik w całym korpusie lub zbiorze segmentów, brane są zagregowane wartości P , R i p , a następnie łączone przy użyciu tego samego wzoru. Algorytm działa również przy porównywaniu tłumaczenia kandydującego z więcej niż jednym tłumaczeniem referencyjnym. W tym przypadku algorytm porównuje kandydata z każdą z referencji i wybiera najwyższą punktację.

Przykłady

| Odniesienie | the | kot | siedział | NA | the | mata |

|---|---|---|---|---|---|---|

| Hipoteza | NA | the | mata | siedział | the | kot |

| Wynik | ||||||

| Średnia | ||||||

| Kara | ||||||

| Podział | ||||||

| Odniesienie | the | kot | siedział | NA | the | mata |

|---|---|---|---|---|---|---|

| Hipoteza | the | kot | siedział | NA | the | mata |

| Wynik | ||||||

| Średnia | ||||||

| Kara | ||||||

| Podział | ||||||

| Odniesienie | the | kot | siedział | NA | the | mata | |

|---|---|---|---|---|---|---|---|

| Hipoteza | the | kot | był | siedział | NA | the | mata |

| Wynik | |||||||

| Średnia | |||||||

| Kara | |||||||

| Podział | |||||||

Zobacz też

- NIEBIESKI

- Pomiar F

- NIST (metryczny)

- RÓŻOWY (metryczny)

- Współczynnik błędów słów (WER)

- LEPOR

- Dzielenie fraz rzeczownikowych

Notatki

- ^ Banerjee, S. i Lavie, A. (2005)

- Banerjee, S. and Lavie, A. (2005) „METEOR: An Automatic Metric for MT Evaluation with Improved Correlation with Human Judgments” w Proceedings of Workshop on Intrinsic and Extrinsic Evaluation Measures for MT i/lub Podsumowanie na 43. dorocznym spotkaniu Association of Computational Linguistics (ACL-2005), Ann Arbor, Michigan, czerwiec 2005

- Lavie, A., Sagae, K. i Jayaraman, S. (2004) „Znaczenie wycofania w automatycznych metrykach oceny MT” w Proceedings of AMTA 2004, Washington DC. wrzesień 2004 r

Linki zewnętrzne

- System automatycznej oceny tłumaczenia maszynowego METEOR (wraz z linkiem do pobrania)