Wygładzanie jądra

Wygładzanie jądra to technika statystyczna do oszacowania funkcji rzeczywistych ważonej sąsiednich zaobserwowanych Waga jest określana przez jądro , tak że bliższe punkty mają większą wagę. Oszacowana funkcja jest gładka, a poziom gładkości jest ustalany przez jeden parametr. Wygładzanie jądra jest rodzajem ważonej średniej kroczącej .

Definicje

Niech będzie jądrem zdefiniowanym przez

Gdzie:

- jest normą euklidesową

- jest parametrem (promień jądra)

- 0 D ( t ) jest zazwyczaj dodatnią funkcją o wartościach rzeczywistych, której wartość maleje (lub nie rośnie) wraz ze wzrostem odległości między X a X .

Popularne jądra używane do wygładzania obejmują jądra paraboliczne (Epanechnikov), Tricube i Gaussa .

Niech będzie ciągłą funkcją X . Dla każdego średnia ważona jądrem Nadarayi-Watsona (gładkie oszacowanie Y ( X )) jest zdefiniowana przez

Gdzie:

- N to liczba obserwowanych punktów

- Y ( X i ) to obserwacje w punktach X i .

W poniższych sekcjach opisujemy niektóre szczególne przypadki wygładzania jądra.

Wygładzanie jądra Gaussa

Jądro Gaussa jest jednym z najczęściej używanych jąder i jest wyrażone za pomocą poniższego równania.

Tutaj b jest skalą długości dla przestrzeni wejściowej.

Najbliższy sąsiad gładszy

00 Idea wygładzania najbliższego sąsiada jest następująca. Dla każdego punktu X weź m najbliższych sąsiadów i oszacuj wartość Y ( X ) przez uśrednienie wartości tych sąsiadów.

Formalnie , gdzie jest m- tym najbliższym X sąsiadem i 0

Przykład:

00 W tym przykładzie X jest jednowymiarowe. Dla każdego X średnią 16 najbliższych X punktów (oznaczonych Wynik nie jest wystarczająco gładki.

Jądro średnio płynniejsze

000 Idea przeciętnego wygładzenia jądra jest następująca. Dla każdego punktu danych X wybierz stały rozmiar odległości λ ( promień jądra lub szerokość okna dla p = 1 wymiar) oblicz średnią ważoną dla wszystkich punktów danych, które są bliżej niż ( bliżej X punktów uzyskują wyższe wagi).

Formalnie i D ( t ) jest jednym z popularnych jąder .

Przykład:

000 Dla każdego X szerokość okna jest stała, a waga każdego punktu w oknie jest schematycznie oznaczona żółtą cyfrą na wykresie. Można zauważyć, że estymacja jest gładka, ale punkty brzegowe są obciążone. Powodem tego jest nierówna liczba punktów (od prawej i od lewej do X ) w oknie, gdy X jest wystarczająco blisko granicy.

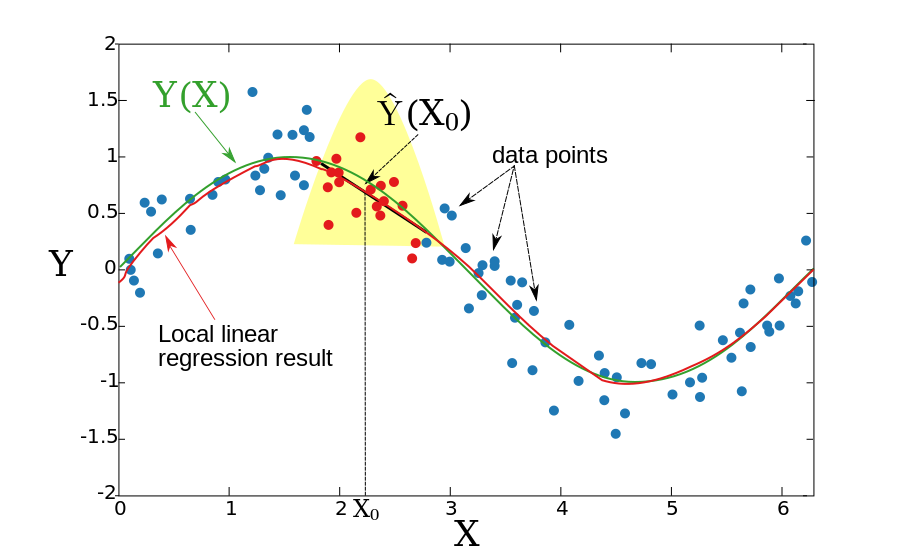

Lokalna regresja liniowa

00 W dwóch poprzednich sekcjach założyliśmy, że podstawowa funkcja Y(X) jest lokalnie stała, dlatego mogliśmy użyć średniej ważonej do oszacowania. Ideą lokalnej regresji liniowej jest dopasowanie lokalnie linii prostej (lub hiperpłaszczyzny dla większych wymiarów), a nie stałej (linia pozioma). linii oszacowanie tej linii w X. Powtarzając tę procedurę dla każdego X , można otrzymać funkcję estymacji . Podobnie jak w poprzedniej sekcji, szerokość okna jest stała Formalnie lokalna regresja liniowa jest obliczana przez rozwiązanie ważonego problemu najmniejszych kwadratów.

Dla jednego wymiaru ( p = 1):

Rozwiązanie w postaci zamkniętej jest podane przez:

Gdzie:

Przykład:

Wynikowa funkcja jest gładka, a problem z obciążonymi punktami granicznymi jest zmniejszony.

Lokalną regresję liniową można zastosować do przestrzeni dowolnej wymiarowej, chociaż pytanie, czym jest lokalne sąsiedztwo, staje się bardziej skomplikowane. Często stosuje się k punktów treningowych najbliższych punktowi testowemu, aby dopasować lokalną regresję liniową. Może to prowadzić do dużej zmienności dopasowanej funkcji. Aby ograniczyć wariancję, zestaw punktów treningowych powinien zawierać punkt testowy w ich wypukłym kadłubie (patrz odnośnik Gupta i in.).

Lokalna regresja wielomianowa

Zamiast dopasowywać lokalnie funkcje liniowe, można dopasować funkcje wielomianowe.

Dla p=1 należy zminimalizować:

z

W przypadku ogólnym (p>1) należy minimalizować:

Zobacz też

- Li, Q. i JS Racine. Ekonometria nieparametryczna: teoria i praktyka . Princeton University Press, 2007, ISBN 0-691-12161-3 .

- T. Hastie, R. Tibshirani i J. Friedman, Elementy uczenia się statystycznego , rozdział 6, Springer, 2001. ISBN 0-387-95284-5 ( strona z książką towarzyszącą ).

- M. Gupta, E. Garcia i E. Chin, „Adaptive Local Linear Regression with Application to Printer Color Management”, IEEE Trans. Przetwarzanie obrazu 2008.

![h_{m}(X_{0})=\left\|X_{0}-X_{{[m]}}\right\|](https://wikimedia.org/api/rest_v1/media/math/render/svg/e649a2d186d0ff66a1aa6c00792a3f263293049d)

![X_{{[m]}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/c375afa1c3ce963071818546bfa67b2b846585ee)