Odporna regresja i wykrywanie wartości odstających

Robust Regression and Outlier Detection to książka o solidnych statystykach , skupiająca się w szczególności na punkcie załamania metod solidnej regresji . Został napisany przez Petera Rousseeuw i Annick M. Leroy i opublikowany w 1987 roku przez Wiley.

Tło

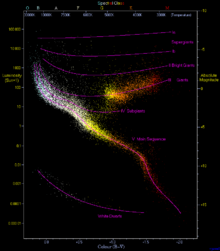

Regresja liniowa to problem wnioskowania o liniowej zależności funkcjonalnej między zmienną zależną a jedną lub kilkoma zmiennymi niezależnymi na podstawie zbiorów danych, w których zależność ta została przesłonięta przez szum. Zwyczajna metoda najmniejszych kwadratów zakłada, że wszystkie dane leżą blisko linii lub płaszczyzny dopasowania, ale odbiegają od niej przez dodanie wartości resztkowych o rozkładzie normalnym . W przeciwieństwie do tego solidne metody regresji działają nawet wtedy, gdy niektóre punkty danych są wartościami odstającymi które nie mają żadnego związku z linią dopasowania lub płaszczyzną, prawdopodobnie dlatego, że dane pochodzą z różnych źródeł lub prawdopodobnie dlatego, że przeciwnik próbuje uszkodzić dane, aby metoda regresji dała niedokładny wynik. Typowe zastosowanie, omówione w książce, obejmuje diagram typów gwiazd Hertzsprunga-Russella , w którym chce się dopasować krzywą przez główną sekwencję gwiazd bez odrzucania dopasowania przez odległe olbrzymy i białe karły . Punkt załamania solidnej metody regresji to ułamek danych odstających, które może tolerować, pozostając dokładnymi. W przypadku tego stylu analizy wyższe punkty załamania są lepsze. Punkt załamania dla zwykłych najmniejszych kwadratów jest bliski zeru (pojedyncza wartość odstająca może sprawić, że dopasowanie stanie się arbitralnie dalekie od pozostałych nieuszkodzonych danych), podczas gdy niektóre inne metody mają punkty załamania nawet do 50%. Chociaż metody te wymagają niewielu założeń dotyczących danych i działają dobrze w przypadku danych, których szum nie jest dobrze zrozumiany, mogą mieć nieco niższą wydajność niż zwykłe metody najmniejszych kwadratów (wymagające większej liczby danych dla danej dokładności dopasowania), a ich implementacja może być złożona i powolny.

Tematy

Książka ma siedem rozdziałów. Pierwszy jest wprowadzający; opisuje prostą regresję liniową (w której jest tylko jedna zmienna niezależna), omawia możliwość wystąpienia wartości odstających, które mogą uszkodzić zmienną zależną lub niezależną, podaje przykłady, w których wartości odstające dają mylące wyniki, definiuje punkt załamania i pokrótce przedstawia kilka metod dla solidnej prostej regresji, w tym powtarzanej regresji medianowej . Rozdziały drugi i trzeci analizują bardziej szczegółowo metodę najmniejszych median kwadratów dla regresji (w której poszukuje się dopasowania, które minimalizuje medianę kwadratów reszt ) i najmniej przyciętych kwadratów metoda (w której dąży się do zminimalizowania sumy kwadratów reszt, które są poniżej mediany). Obie te metody mają punkt załamania 50% i można je zastosować zarówno do regresji prostej (rozdział drugi), jak i regresji wielowymiarowej (rozdział trzeci). Chociaż najmniejsza mediana ma atrakcyjny opis geometryczny (jak znalezienie paska o minimalnej wysokości zawierającego połowę danych), jej niska wydajność prowadzi do zalecenia, aby zamiast tego używać najmniej przyciętych kwadratów; najmniej przycięte kwadraty można również interpretować jako wykorzystujące metodę najmniejszej mediany do znajdowania i eliminowania wartości odstających, a następnie stosującą prostą regresję dla pozostałych danych i zbliżającą się do prostej regresji pod względem wydajności. Oprócz opisu tych metod i analizy ich właściwości statystycznych, rozdziały te opisują również, jak używać oprogramowania autorów do implementacji tych metod. Rozdział trzeci zawiera również opisy niektórych estymatorów alternatywnych z wysokimi punktami załamania.

Czwarty rozdział opisuje jednowymiarowe oszacowanie parametru lokalizacji lub tendencji centralnej oraz implementację oprogramowania, a rozdział piąty zawiera bardziej szczegółowe informacje na temat algorytmów używanych przez oprogramowanie do wydajnego obliczania tych oszacowań. Rozdział szósty dotyczy wykrywania wartości odstających , porównywania metod identyfikacji punktów danych jako wartości odstających w oparciu o solidne statystyki z innymi szeroko stosowanymi metodami, a ostatni rozdział dotyczy wielowymiarowych problemów lokalizacyjnych, a także analizy szeregów czasowych i problemów dopasowania elipsoidy lub macierz kowariancji do danych. Oprócz wykorzystania punktu załamania do porównania metod statystycznych, książka przygląda się również ich równoważności : dla których rodzin przekształceń danych dopasowanie przekształconych danych jest równe przekształconej wersji dopasowania oryginalnych danych?

Zgodnie z koncentracją książki na zastosowaniach, zawiera ona wiele przykładów analiz przeprowadzonych przy użyciu solidnych metod, porównując uzyskane oszacowania z szacunkami uzyskanymi za pomocą standardowych metod nieodpornych. Materiał teoretyczny jest uwzględniony, ale odłożony na bok, aby czytelnicy mniej zorientowani teoretycznie mogli go łatwo pominąć. Autorzy stoją na stanowisku, że solidne metody mogą być stosowane zarówno do sprawdzania stosowalności regresji zwykłej (gdy wyniki obu metod są zgodne), jak i zastępowania ich w przypadkach, gdy wyniki się nie zgadzają.

Publiczność i odbiór

Książka jest skierowana do statystyków stosowanych, a jej celem jest przekonanie ich do stosowania opisanych w niej solidnych metod. W przeciwieństwie do poprzednich prac nad solidną statystyką, sprawia, że solidne metody są zarówno zrozumiałe dla praktyków, jak i (poprzez powiązane oprogramowanie) dostępne dla praktyków. Nie jest wymagana żadna wcześniejsza znajomość solidnych statystyk, chociaż zakłada się pewne doświadczenie w podstawowych technikach statystycznych. Książka mogłaby być również używana jako podręcznik, chociaż recenzent PJ Laycock nazywa możliwość takiego wykorzystania „odważną i postępową”, a recenzenci Seheult i Green zwracają uwagę, że jest mało prawdopodobne, aby taki kurs pasował do brytyjskich programów statystycznych.

Recenzenci Seheult i Green narzekają, że zbyt duża część książki działa jak przewodnik użytkownika po oprogramowaniu autorów i powinna była zostać przycięta. Jednak recenzent Gregory F. Piepel pisze, że „prezentacja jest bardzo dobra” i poleca książkę każdemu użytkownikowi metod statystycznych. Sugerując zmianę kolejności niektórych materiałów, Karen Kafadar zdecydowanie poleca tę książkę jako podręcznik dla doktorantów i punkt odniesienia dla profesjonalistów. A recenzent AC Atkinson zwięźle podsumowuje książkę jako „interesującą i ważną”.

Powiązane książki

Było wiele poprzednich książek na temat niezawodnej regresji i wykrywania wartości odstających, w tym:

- Identyfikacja wartości odstających przez DM Hawkinsa (1980)

- Solidne statystyki autorstwa Petera J. Hubera (1981)

- Wprowadzenie do odpornych i quasi-odpornych metod statystycznych autorstwa WJJ Rey (1983)

- Zrozumienie solidnej i eksploracyjnej analizy danych autorstwa Davida C. Hoaglina, Fredericka Mostellera i Johna Tukeya (1983)

- Solidne statystyki autorstwa Hampela, Ronchettiego, Rousseeuwa i Stahela (1986)

Dla porównania, solidna regresja i wykrywanie wartości odstających łączą w sobie zarówno solidność, jak i wykrywanie wartości odstających. Jest mniej teoretyczny, bardziej skoncentrowany na danych i oprogramowaniu, a bardziej na punkcie awarii niż na innych miarach odporności. Dodatkowo jako pierwszy podkreśla znaczenie „dźwigni”, zjawiska polegającego na tym, że próbki z wartościami odstającymi zmiennej niezależnej mogą mieć silniejszy wpływ na dopasowanie niż próbki, w których zmienna niezależna ma wartość centralną.