Problem z płaskością

Problem płaskości ( znany również jako problem starości ) jest kosmologicznym problemem dostrajania w modelu Wielkiego Wybuchu . Takie problemy wynikają z obserwacji, że niektóre warunki początkowe Wszechświata wydają się być precyzyjnie dostrojone do bardzo „specjalnych” wartości i że niewielkie odchylenia od tych wartości miałyby ekstremalny wpływ na wygląd Wszechświata w obecnym czasie.

W przypadku problemu płaskości parametrem, który wydaje się być precyzyjnie dostrojony, jest gęstość materii i energii we wszechświecie . Ta wartość wpływa na zakrzywienie czasoprzestrzeni, przy czym dla płaskiego wszechświata wymagana jest bardzo specyficzna wartość krytyczna . Obserwuje się, że obecna gęstość Wszechświata jest bardzo bliska tej wartości krytycznej. Ponieważ każde odstępstwo całkowitej gęstości od wartości krytycznej gwałtownie wzrastałoby w czasie kosmicznym , wczesny Wszechświat musiał mieć gęstość jeszcze bliższą gęstości krytycznej, odchodząc od niej o jedną część na 10 62 lub mniej. Prowadzi to kosmologów do pytania, w jaki sposób początkowa gęstość została tak dokładnie dostrojona do tej „specjalnej” wartości.

Problem ten został po raz pierwszy wspomniany przez Roberta Dicke'a w 1969 roku. Najbardziej powszechnie akceptowanym przez kosmologów rozwiązaniem jest inflacja kosmiczna , koncepcja, że Wszechświat przeszedł przez krótki okres niezwykle szybkiej ekspansji w pierwszej ułamku sekundy po Wielkim Wybuchu; wraz z problemem monopolu i problemem horyzontu , problem płaskości jest jedną z trzech głównych motywacji teorii inflacji.

Gęstość energii i równanie Friedmanna

Zgodnie z równaniami pola ogólnej teorii względności Einsteina na strukturę czasoprzestrzeni wpływa obecność materii i energii. W małych skalach przestrzeń wydaje się płaska – podobnie jak powierzchnia Ziemi, jeśli spojrzeć na mały obszar. Jednak w dużych skalach przestrzeń jest zakrzywiona przez grawitacyjne oddziaływanie materii. Ponieważ teoria względności wskazuje, że materia i energia są równoważne , efekt ten jest również wytwarzany przez obecność energii (takiej jak światło i inne promieniowanie elektromagnetyczne) oprócz materii. Wielkość wygięcia (lub krzywizny ) wszechświata zależy od gęstości obecnej materii/energii.

Zależność tę można wyrazić pierwszym równaniem Friedmanna . We wszechświecie bez stałej kosmologicznej jest to:

Tutaj parametrem , miarą tempa rozszerzania się wszechświata. \ to całkowita gęstość masy i energii we wszechświecie, skali (zasadniczo „rozmiar” wszechświata), a krzywizna to parametr — czyli miara zakrzywienia czasoprzestrzeni. Dodatnia, zerowa lub ujemna wartość odpowiednio zamkniętemu, płaskiemu lub otwartemu wszechświatowi Stałe i są odpowiednio Newtona i .

Kosmologowie często upraszczają to równanie, definiując gęstość krytyczną. . Dla danej wartości jest to zdefiniowane jako gęstość wymagana dla płaskiego wszechświata, tj. . Zatem powyższe równanie implikuje

- .

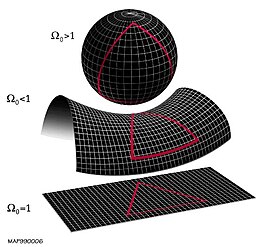

Ponieważ znana jest stała tempo ekspansji można zmierzyć obserwując prędkość, z jaką oddalają się od nas odległe galaktyki, { być zdeterminowanym. Jego wartość wynosi obecnie około 10 −26 kg m −3 . Stosunek rzeczywistej gęstości do tej wartości krytycznej nazywa się Ω, a jego różnica od 1 określa geometrię wszechświata: Ω > 1 odpowiada gęstości większej niż krytyczna, , a zatem zamknięty wszechświat . Ω < 1 daje wszechświat otwarty o małej gęstości , a Ω równy dokładnie 1 daje wszechświat płaski .

Równanie Friedmanna,

można przearanżować

po rozłożeniu na czynniki do ρ

Prawa strona ostatniego wyrażenia powyżej zawiera tylko stałe i dlatego lewa strona musi pozostać stała przez całą ewolucję wszechświata.

Gdy wszechświat się rozszerza, współczynnik skali ale gęstość , gdy materia (lub energia) ulega rozproszeniu W przypadku standardowego modelu wszechświata swojej historii zawiera głównie materię i promieniowanie, szybciej niż , więc współczynnik zmniejszy się. Od czasów ery Plancka , krótko po Wielkim Wybuchu, termin ten zmniejszył się około i tak musiała wzrosnąć o podobną kwotę, aby zachować stałą wartość swojego produktu.

Bieżąca wartość Ω

Pomiar

0 Wartość Ω w chwili obecnej jest oznaczona jako Ω . Wartość tę wywnioskować mierząc krzywiznę czasoprzestrzeni (ponieważ lub , jest definiowana jako gęstość, dla której krzywizna k = 0 . Krzywiznę można wywnioskować z wielu obserwacji.

Jedną z takich obserwacji jest anizotropia (czyli zmiany kierunku - patrz poniżej) w kosmicznym mikrofalowym promieniowaniu tła (CMB). CMB to promieniowanie elektromagnetyczne , które wypełnia wszechświat, pozostałość po wczesnym etapie jego historii, kiedy był wypełniony fotonami i gorącą, gęstą plazmą . Ta plazma ochładzała się wraz z rozszerzaniem się wszechświata, a kiedy ostygła na tyle, by utworzyć stabilne atomy , nie absorbowała już fotonów. Fotony obecne na tym etapie propagują się od tamtej pory, stając się coraz słabsze i mniej energetyczne w miarę rozprzestrzeniania się po stale rozszerzającym się wszechświecie.

0 Temperatura tego promieniowania jest prawie taka sama we wszystkich punktach nieba, ale istnieje niewielka różnica (około jednej części na 100 000) między temperaturą odbieraną z różnych kierunków. Skala kątowa tych fluktuacji – typowy kąt między plamą gorącą a plamą zimną na niebie – zależy od krzywizny Wszechświata, która z kolei zależy od jego gęstości, jak opisano powyżej. Zatem pomiary tej skali kątowej pozwalają oszacować Ω .

0 0 Inną sondą Ω jest częstotliwość supernowych typu Ia w różnych odległościach od Ziemi. Te supernowe, eksplozje zdegenerowanych białych karłów, są rodzajem świecy standardowej ; oznacza to, że procesy rządzące ich wewnętrzną jasnością są dobrze poznane, więc miara pozornej jasności widzianej z Ziemi może być wykorzystana do uzyskania dokładnych pomiarów odległości dla nich (pozorna jasność zmniejsza się proporcjonalnie do kwadratu odległości - patrz odległość jasności ). Porównanie tej odległości z czerwieni supernowych daje miarę tempa rozszerzania się Wszechświata w różnych momentach historii. Ponieważ tempo ekspansji ewoluuje różnie w czasie w kosmologiach o różnych gęstościach całkowitych, Ω można wywnioskować z danych dotyczących supernowych.

0 Dane z Wilkinson Microwave Anisotropy Probe (pomiar anizotropii CMB) w połączeniu z danymi z Sloan Digital Sky Survey i obserwacjami supernowych typu Ia ograniczają Ω do 1 w granicach 1%. Innymi słowy, termin |Ω − 1| jest obecnie mniejszy niż 0,01, a zatem musiał być mniejszy niż 10-62 w erze Plancka .

Implikacja

Ta niewielka wartość jest sednem problemu płaskości. Gdyby początkowa gęstość wszechświata mogła przyjąć jakąkolwiek wartość, niezwykle zaskakujące byłoby znalezienie jej tak „precyzyjnie dostrojonej” . Rzeczywiście, bardzo małe odchylenie Ω od 1 we wczesnym wszechświecie zostałoby powiększone podczas miliardów lat ekspansji, tworząc gęstość prądu bardzo daleką od krytycznej. W przypadku nadmiernej gęstości doprowadziłoby przeciwieństwo do powstania wszechświata tak gęstego, że przestałby się rozszerzać i zapadł w ( Wielkiego Wybuchu w którym cała materia i energia wracają do bardzo gęstego stanu w ciągu kilku lat lub mniej; w przypadku niedogęszczenia ) silna się tak szybko i stałby się tak rzadki, że wkrótce wydawałby się zasadniczo pusty, a wystarczająco w porównaniu spowodować zapadanie się materii i tworzenie galaktyk . W obu przypadkach wszechświat nie zawierałby złożonych struktur, takich jak galaktyki, gwiazdy, planety i jakiekolwiek formy życia.

Ten problem z modelem Wielkiego Wybuchu został po raz pierwszy wskazany przez Roberta Dicke'a w 1969 roku i zmotywował go do poszukiwania jakiegoś powodu, dla którego gęstość powinna przyjmować tak specyficzną wartość.

Rozwiązania problemu

Niektórzy kosmolodzy zgodzili się z Dicke, że problem płaskości jest poważny i wymaga fundamentalnego powodu bliskości gęstości do krytyczności. Ale była też szkoła myślenia, która zaprzeczała istnieniu problemu do rozwiązania, argumentując zamiast tego, że skoro wszechświat musi mieć pewną gęstość, równie dobrze może mieć gęstość bliską ρ do r ja t {\ Displaystyle jak najdalej od tego, a spekulowanie na temat przyczyny jakiejkolwiek szczególnej wartości było „poza domeną nauki”. Jest to jednak pogląd mniejszości, nawet wśród sceptyków co do istnienia problemu płaskości. Kilku kosmologów argumentowało, że z różnych powodów problem płaskości opiera się na nieporozumieniu, ale wydaje się, że jest to powszechnie ignorowane. Jednak wystarczająca liczba kosmologów uznała problem za realny, aby zaproponować różne rozwiązania.

Zasada antropiczna

Jednym z rozwiązań problemu jest odwołanie się do zasady antropicznej , która mówi, że człowiek, spekulując na temat przyczyn właściwości wszechświata, powinien brać pod uwagę warunki niezbędne do jego istnienia. Jeśli dwa typy wszechświata wydają się równie prawdopodobne, ale tylko jeden nadaje się do ewolucji inteligentnego życia , zasada antropiczna sugeruje, że znalezienie się w tym wszechświecie nie jest niespodzianką: gdyby zamiast tego istniał inny wszechświat, nie byłoby obserwatorów, którzy mogliby zauważyć fakt.

Zasadę można zastosować do rozwiązania problemu płaskości na dwa nieco różne sposoby. Pierwsza (zastosowanie „silnej zasady antropicznej”) została zaproponowana przez CB Collinsa i Stephena Hawkinga , którzy w 1973 roku rozważali istnienie nieskończonej liczby wszechświatów, tak że każda możliwa kombinacja właściwości początkowych była utrzymywana przez jakiś wszechświat. Argumentowali, że w takiej sytuacji tylko te wszechświaty, których gęstość jest dokładnie odpowiednia do formowania się galaktyk i gwiazd, dałyby początek inteligentnym obserwatorom, takim jak ludzie: dlatego fakt, że obserwujemy, że Ω jest tak bliski 1, byłby „po prostu odbiciem naszego własnego istnienia”.

Alternatywne podejście, wykorzystujące „słabą zasadę antropiczną”, polega na założeniu, że wszechświat ma nieskończoną wielkość, ale gęstość jest różna w różnych miejscach (tj. wszechświat niejednorodny ) . W związku z tym niektóre regiony będą zbyt gęste (Ω > 1) , a niektóre zbyt gęste (Ω < 1) . Regiony te mogą być bardzo od siebie oddalone - być może tak daleko, że światło nie miało czasu na podróż z jednego do drugiego w epoce wszechświata (to znaczy leżą one poza swoimi kosmologicznymi horyzontami ). Dlatego każdy region zachowywałby się zasadniczo jak oddzielny wszechświat: gdybyśmy przypadkiem żyli w dużym skrawku o gęstości prawie krytycznej, nie mielibyśmy możliwości dowiedzenia się o istnieniu odległych skrawków o zbyt małej lub zbyt gęstej gęstości, ponieważ żadne światło nie lub inny sygnał od nich do nas dotarł. Można zatem odwołać się do zasady antropicznej, argumentując, że inteligentne życie powstałoby tylko w tych obszarach, w których Ω jest bardzo bliskie 1, a zatem nasze życie w takim skrawku nie jest zaskakujące.

Ten ostatni argument wykorzystuje wersję zasady antropicznej, która jest „słabsza” w tym sensie, że nie wymaga spekulacji na temat wielu wszechświatów ani prawdopodobieństwa istnienia różnych różnych wszechświatów zamiast obecnego. Wymaga tylko jednego wszechświata, który jest nieskończony – lub wystarczająco duży, aby mogło powstać wiele niepołączonych fragmentów – i aby gęstość była różna w różnych regionach (co z pewnością ma miejsce w przypadku mniejszych skal, powodujących powstawanie gromad galaktycznych i pustek ) .

Jednak zasada antropiczna była krytykowana przez wielu naukowców. Na przykład w 1979 r. Bernard Carr i Martin Rees argumentowali, że zasada „jest całkowicie post hoc: nie została jeszcze wykorzystana do przewidywania jakiejkolwiek cechy Wszechświata”. Inni sprzeciwiali się jej filozoficznym podstawom, a Ernan McMullin napisał w 1994 r., Że „słaba zasada antropiczna jest trywialna… a silna zasada antropiczna jest nie do obrony”. Ponieważ wielu fizyków i filozofów nauki nie uważa tej zasady za zgodną z metodą naukową , potrzebne było inne wyjaśnienie problemu płaskości.

Inflacja

problemu płaskości , proces, w się wykładniczo szybko ( , dla pewnej stałej okresie w jego wczesnej historii. Teoria inflacji została po raz pierwszy zaproponowana w 1979 roku i opublikowana w 1981 roku przez Alana Gutha . Jego dwiema głównymi motywacjami do tego były problem płaskości i problem horyzontu , kolejny problem precyzyjnego dostrojenia kosmologii fizycznej. Jednak „w grudniu 1980 r., kiedy Guth opracowywał swój model inflacji, nie próbował rozwiązać problemu płaskości ani horyzontu. Rzeczywiście w tamtym czasie nie wiedział nic o problemie horyzontu i nigdy nie obliczył ilościowo problemu płaskości”. Był fizykiem cząstek elementarnych, który próbował rozwiązać problem monopolu magnetycznego.

Proponowaną przyczyną inflacji jest pole , które przenika przestrzeń i napędza ekspansję. Pole zawiera pewną gęstość energii, ale w przeciwieństwie do gęstości materii lub promieniowania obecnych w późnym wszechświecie, które zmniejszają się z czasem, gęstość pola inflacyjnego pozostaje mniej więcej stała w miarę rozszerzania się przestrzeni. Dlatego termin gdy współczynnik . Przywołując równanie Friedmanna

- ,

oraz fakt, że prawa strona tego wyrażenia jest stała, wyraz musi zatem zmniejszać się z czasem.

Zatem jeśli początkowo przyjmuje dowolną dowolną wartość, okres inflacji może zmusić ją do zera i pozostawić bardzo małą - około zgodnie z powyższymi wymaganiami, na przykład. Późniejsza ewolucja wszechświata spowoduje wzrost wartości, doprowadzając ją do obecnie obserwowanej wartości około 0,01. W ten sposób usunięto czułą zależność od początkowej wartości Ω: duża, a zatem „nie zaskakująca” wartość początkowa nie musi być wzmacniana i prowadzić do bardzo zakrzywionego Wszechświata bez możliwości tworzenia galaktyk i innych struktur.

Ten sukces w rozwiązaniu problemu płaskości jest uważany za jedną z głównych motywacji teorii inflacji.

Po inflacji

Chociaż uważa się, że teoria inflacji odniosła duży sukces, a dowody na to są przekonujące, nie jest ona powszechnie akceptowana: kosmologowie dostrzegają, że w teorii wciąż istnieją luki i są otwarci na możliwość, że przyszłe obserwacje ją obalą. W szczególności, wobec braku jakichkolwiek niezbitych dowodów na to, jakie powinno być pole napędzające inflację, zaproponowano wiele różnych wersji tej teorii. Wiele z nich zawiera parametry lub warunki początkowe, które same wymagają dostrojenia w podobny sposób, jak wczesna gęstość bez inflacji.

Z tych powodów wciąż trwają prace nad alternatywnymi rozwiązaniami problemu płaskości. Obejmowały one niestandardowe interpretacje wpływu ciemnej energii i grawitacji, produkcję cząstek w oscylującym wszechświecie oraz wykorzystanie statystycznego bayesowskiego do argumentowania, że problem nie istnieje. Ten ostatni argument, sugerowany na przykład przez Evrarda i Colesa, utrzymuje, że pomysł, że Ω bliskie 1 jest „mało prawdopodobne”, opiera się na założeniach dotyczących prawdopodobnego rozkładu parametru, które niekoniecznie są uzasadnione. Pomimo tych ciągłych prac inflacja pozostaje zdecydowanie dominującym wyjaśnieniem problemu płaskości. Powstaje jednak pytanie, czy nadal jest to dominujące wyjaśnienie, ponieważ jest najlepszym wyjaśnieniem, czy też dlatego, że społeczność nie jest świadoma postępów w tej kwestii. W szczególności, oprócz idei, że Ω nie jest odpowiednim parametrem w tym kontekście, przedstawiono inne argumenty przeciwko problemowi płaskości: jeśli wszechświat zapadnie się w przyszłości, to problem płaskości „istnieje”, ale tylko przez stosunkowo krótki czas, więc typowy obserwator nie spodziewałby się, że zmierzy Ω znacznie różni się od 1; w przypadku wszechświata, który rozszerza się w nieskończoność z dodatnią stałą kosmologiczną, konieczne jest precyzyjne dostrojenie nie po to, aby osiągnąć (prawie) płaski wszechświat, ale także po to, aby go uniknąć.

Teoria Einsteina-Cartana

Problem płaskości jest naturalnie rozwiązywany przez teorię grawitacji Einsteina-Cartana-Sciamy-Kibble'a , bez egzotycznej formy materii wymaganej w teorii inflacji. Teoria ta rozszerza ogólną teorię względności, usuwając ograniczenie symetrii połączenia afinicznego i uznając jego antysymetryczną część, tensor torsyjny , za zmienną dynamiczną. Nie ma wolnych parametrów. Uwzględnienie skręcania daje prawidłowe prawo zachowania dla całkowitego (orbitalnego i wewnętrznego) momentu pędu materii w obecności grawitacji. Minimalne sprzężenie między spinorami skrętnymi a spinorami Diraca, zgodne z nieliniowym równaniem Diraca, generuje interakcję spin-spin, która jest znacząca w materii fermionowej przy ekstremalnie dużych gęstościach. Taka interakcja odwraca niefizyczną osobliwość Wielkiego Wybuchu, zastępując ją odbiciem przy skończonym minimalnym współczynniku skali, przed którym Wszechświat się kurczył. Gwałtowna ekspansja bezpośrednio po dużym odbiciu wyjaśnia, dlaczego obecny Wszechświat w największych skalach wydaje się przestrzennie płaski, jednorodny i izotropowy. Wraz ze spadkiem gęstości Wszechświata efekty skręcania słabną i Wszechświat płynnie wkracza w erę zdominowaną przez promieniowanie.