Rozpoznawanie obiektów 3D

| Wykrywanie cech Wykrywanie |

|---|

| krawędzi |

| Wykrywanie narożników |

| Wykrywanie kropel |

| Detekcja grzbietu |

| Transformata Hougha |

| Tensor struktury |

| Wykrywanie niezmiennych cech afinicznych |

| Opis funkcji |

| Skaluj przestrzeń |

W wizji komputerowej rozpoznawanie obiektów 3D polega na rozpoznawaniu i określaniu informacji 3D, takich jak ułożenie , objętość lub kształt wybranych przez użytkownika obiektów 3D na zdjęciu lub skanie zakresu . Zazwyczaj przykładowy obiekt do rozpoznania jest prezentowany systemowi wizyjnemu w kontrolowanym środowisku, a następnie dla dowolnego wejścia, takiego jak strumień wideo , system lokalizuje wcześniej prezentowany obiekt. Można to zrobić w trybie offline lub w czasie rzeczywistym . Algorytmy , które działają na ogólnych klasach obiektów, takich jak systemy rozpoznawania twarzy lub ogólne rozpoznawanie obiektów 3D. Ze względu na niski koszt i łatwość pozyskiwania fotografii, rozpoznawaniu obiektów 3D na fotografiach poświęcono znaczną ilość badań.

Rozpoznawanie pojedynczych obiektów 3D na zdjęciach

Sposób rozpoznawania obiektu 3D zależy od właściwości obiektu. Dla uproszczenia wiele istniejących algorytmów skupiało się na rozpoznawaniu sztywnych obiektów składających się z jednej części, to znaczy obiektów, których transformacja przestrzenna jest ruchem euklidesowym . Przyjęto dwa ogólne podejścia do problemu: rozpoznawania wzorców wykorzystują informacje o wyglądzie obrazu niskiego poziomu do zlokalizowania obiektu, podczas gdy metody geometryczne oparte na cechach konstruują model rozpoznawanego obiektu i dopasowują model do fotografii.

Podejścia do rozpoznawania wzorców

Metody te wykorzystują informacje o wyglądzie zebrane z wcześniej przechwyconych lub wstępnie obliczonych projekcji obiektu w celu dopasowania obiektu w potencjalnie zaśmieconej scenie. Jednak podczas dopasowywania nie biorą pod uwagę ograniczeń geometrycznych 3D obiektu i zazwyczaj nie obsługują okluzji ani podejść opartych na cechach. Patrz [Murase i Nayar 1995] oraz [Selinger i Nelson 1999].

Podejścia geometryczne oparte na cechach

Podejścia oparte na cechach dobrze sprawdzają się w przypadku obiektów, które mają charakterystyczne cechy . Jak dotąd udało się rozpoznać obiekty, które mają dobre cechy krawędzi lub plamy ; na przykład algorytmy wykrywania, patrz odpowiednio detektor regionu afinicznego Harrisa i SIFT . Ze względu na brak odpowiednich detektorów cech obiekty bez teksturowanych, gładkich powierzchni nie mogą być obecnie obsługiwane za pomocą tego podejścia.

Rozpoznawanie obiektów oparte na cechach zazwyczaj polega na wstępnym przechwytywaniu szeregu ustalonych widoków obiektu, który ma być rozpoznany, wyodrębnianiu cech z tych widoków, a następnie w procesie rozpoznawania, dopasowywaniu tych cech do sceny i wymuszaniu ograniczeń geometrycznych.

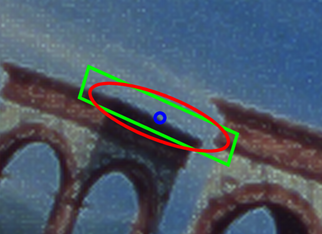

Jako przykład prototypowego systemu przyjmującego takie podejście przedstawimy zarys metody zastosowanej przez [Rothganger et al. 2004], pomijając pewne szczegóły. Metoda zaczyna się od założenia, że obiekty podlegają globalnie sztywnym przekształceniom. Ponieważ gładkie powierzchnie są lokalnie płaskie, niezmienne cechy afiniczne są odpowiednie do dopasowania: artykuł wykrywa obszary zainteresowania w kształcie elipsy, używając zarówno cech podobnych do krawędzi, jak i kropel, i zgodnie z [Lowe 2004] znajduje dominujący kierunek gradientu elipsa, konwertuje elipsę na równoległobok i pobiera deskryptor SIFT na powstałym równoległoboku. Informacje o kolorze są również wykorzystywane do poprawy rozróżniania samych funkcji SIFT.

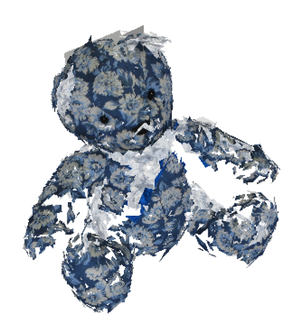

Następnie, biorąc pod uwagę liczbę widoków kamery obiektu (24 w artykule), metoda konstruuje model 3D obiektu, zawierający położenie przestrzenne 3D i orientację każdej cechy. Ponieważ liczba widoków obiektu jest duża, zwykle każda cecha występuje w kilku sąsiednich widokach. Punkty środkowe takich pasujących cech odpowiadają, a wykryte cechy są wyrównane wzdłuż dominującego kierunku gradientu, więc punkty w (1, 0) w lokalnym układzie współrzędnych równoległoboku cechy również odpowiadają, podobnie jak punkty (0, 1) we współrzędnych lokalnych równoległoboku. Zatem dla każdej pary pasujących obiektów w pobliskich widokach znane są trzy odpowiedniki par punktów. Biorąc pod uwagę co najmniej dwie pasujące cechy, wielowidokowa struktura afiniczna z algorytmu ruchu (patrz [Tomasi i Kanade 1992]) może być wykorzystana do skonstruowania oszacowania pozycji punktów (aż do dowolnej transformacji afinicznej). Artykuł Rothgangera i in. dlatego wybiera dwa sąsiednie widoki, używa do RANSAC , aby wybrać dwie odpowiadające sobie pary obiektów i dodaje nowe obiekty do częściowego modelu zbudowanego przez RANSAC, o ile są objęte błędem. Zatem dla dowolnej pary sąsiednich widoków algorytm tworzy cząstkowy model wszystkich cech widocznych w obu widokach.

Aby stworzyć ujednolicony model, artykuł bierze największy model częściowy i stopniowo wyrównuje do niego wszystkie mniejsze modele częściowe. Globalna minimalizacja jest stosowana w celu zmniejszenia błędu, a następnie uaktualnienie euklidesowe jest używane do zmiany pozycji elementu modelu od unikalnych współrzędnych 3D do transformacji afinicznej do współrzędnych 3D, które są unikalne aż do ruchu euklidesowego . Na koniec tego kroku mamy model obiektu docelowego, składający się z cech rzutowanych na wspólną przestrzeń 3D.

Aby rozpoznać obiekt na dowolnym obrazie wejściowym, papier wykrywa cechy, a następnie wykorzystuje RANSAC do znalezienia macierzy projekcji afinicznej, która najlepiej pasuje do ujednoliconego modelu obiektu do sceny 2D. Jeśli to podejście RANSAC ma wystarczająco niski błąd, to w przypadku sukcesu algorytm zarówno rozpoznaje obiekt, jak i podaje jego pozę w postaci projekcji afinicznej. W założonych warunkach metoda zazwyczaj osiąga współczynniki rozpoznawalności na poziomie około 95%.

- Murase, H. i SK Nayar: 1995, Visual Learning and Recognition of 3-D Objects from Appearance . International Journal of Computer Vision 14, 5–24. [1]

- Selinger, A. i R. Nelson: 1999, Percepcyjna hierarchia grupowania do rozpoznawania obiektów 3D na podstawie wyglądu. Wizja komputerowa i zrozumienie obrazu 76 (1), 83–92. [2]

- Rothganger, F; S. Lazebnik, C. Schmid i J. Ponce: 2004. Modelowanie i rozpoznawanie obiektów 3D przy użyciu lokalnych niezmiennych deskryptorów obrazu i wielowidokowych ograniczeń przestrzennych , ICCV. [3]

- Lowe, D.: 2004, Charakterystyczne cechy obrazu z niezmiennych w skali punktów kluczowych. International Journal of Computer Vision . W prasie. [4]

- Tomasi, C. i T. Kanade: 1992, Kształt i ruch ze strumieni obrazu: metoda faktoryzacji. International Journal of Computer Vision 9 (2), 137–154. [5]