Homogenizacja (klimat)

Homogenizacja w badaniach klimatu oznacza usunięcie zmian nieklimatycznych. Oprócz zmian w samym klimacie , surowe zapisy klimatyczne zawierają również skoki i zmiany pozaklimatyczne, na przykład w wyniku przemieszczeń lub zmian w oprzyrządowaniu. Najczęściej stosowaną zasadą usuwania tych niejednorodności jest podejście homogenizacji względnej, w którym kandydująca stacja jest porównywana z referencyjnymi szeregami czasowymi opartymi na jednej lub kilku sąsiednich stacjach. W ten sposób można zidentyfikować i usunąć stacje kandydujące i referencyjne doświadczające tego samego klimatu, zmiany niezwiązane z klimatem, które zachodzą tylko w jednej stacji.

Obserwacje klimatyczne

Aby badać zmiany i zmienność klimatu , niezbędne są długie instrumentalne zapisy klimatu, ale najlepiej nie używać ich bezpośrednio. Te zbiory danych są niezbędne, ponieważ stanowią podstawę między innymi do oceny trendów w skali stulecia lub do badania naturalnej (długookresowej) zmienności klimatu. Wartość tych zestawów danych jest jednak silnie uzależniona od jednorodności podstawowych szeregów czasowych. Homogeniczny zapis klimatu to taki, w którym zmiany są spowodowane jedynie zmianami pogody i klimatu. Długie nagrania instrumentalne rzadko, jeśli w ogóle, są jednorodne.

Wyniki homogenizacji instrumentalnych zachodnich zapisów klimatycznych wskazują, że wykryte niejednorodności w seriach średniej temperatury występują z częstotliwością około 15 do 20 lat. Należy pamiętać, że większość pomiarów nie została wykonana specjalnie do celów klimatycznych, ale raczej na potrzeby prognozowania pogody, rolnictwa i hydrologii. Co więcej, typowa wielkość przerw jest często tego samego rzędu, co sygnał zmian klimatycznych w XX wieku. Niejednorodności są zatem istotnym źródłem niepewności przy szacowaniu trendów sekularnych i zmienności w skali dekady.

Gdyby wszystkie niejednorodności były czysto przypadkowymi zaburzeniami zapisów klimatycznych, ich łączny wpływ na średni globalny sygnał klimatyczny byłby znikomy. Jednak pewne zmiany są typowe dla pewnych okresów i wystąpiły na wielu stacjach, są to najważniejsze przyczyny, ponieważ łącznie mogą one prowadzić do sztucznych odchyleń w trendach klimatycznych w dużych regionach.

Przyczyny niejednorodności

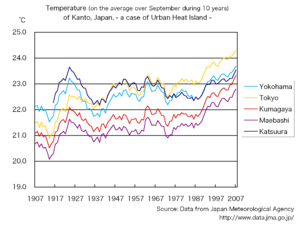

Najbardziej znaną niejednorodnością jest efekt miejskiej wyspy ciepła . Temperatura w miastach może być wyższa niż na wsi, zwłaszcza w nocy. Tak więc wraz z rozwojem miast można spodziewać się wzrostu temperatur mierzonych w miastach. Z drugiej strony, wraz z pojawieniem się lotnictwa, wiele biur meteorologicznych, a tym samym ich stacje, często było przenoszonych z miast do pobliskich, zwykle chłodniejszych lotnisk.

Inne zmiany niezwiązane z klimatem mogą być spowodowane zmianami metod pomiarowych. Instrumenty meteorologiczne są zwykle instalowane na ekranie, aby chronić je przed bezpośrednim słońcem i wilgocią. W XIX wieku powszechne było stosowanie metalowego ekranu przed oknem na północnej ścianie. Jednak budynek może nagrzewać ekran, co prowadzi do wyższych pomiarów temperatury. Kiedy ten problem został zauważony, wprowadzono ekran Stevensona , zwykle instalowany w ogrodach, z dala od budynków. To wciąż najbardziej typowy ekran pogodowy z charakterystycznym podwójnym żaluzjem drzwi i ściany do wentylacji. Historyczne ekrany Montsouri i Wilds były używane około 1900 roku i są otwarte na północ i do dołu. Poprawia to wentylację, ale stwierdzono, że promieniowanie podczerwone z ziemi może wpływać na pomiar w słoneczne i spokojne dni. Dlatego nie są już używane. Obecnie automatyczne stacje pogodowe , które obniżają koszty pracy; chronią termometr kilkoma białymi plastikowymi stożkami. Wymagało to zmiany z ręcznie rejestrowanych termometrów cieczowych i szklanych na automatyczne elektryczne termometry rezystancyjne, co zmniejszyło rejestrowane wartości temperatury w USA.

Również inne elementy klimatu cierpią z powodu niejednorodności. Ilości opadów obserwowane we wczesnym okresie instrumentalnym, mniej więcej przed rokiem 1900, są tendencyjne i są o 10% niższe niż obecnie, ponieważ pomiary opadów były często wykonywane na dachu. W tamtym czasie instrumenty instalowano na dachach, aby instrument nigdy nie był osłonięty przed deszczem, ale później stwierdzono, że ze względu na turbulentny przepływ wiatru na dachach, niektóre kropelki deszczu, a zwłaszcza płatki śniegu, nie wpadały do otwarcie. W związku z tym pomiary są obecnie wykonywane bliżej ziemi.

Inne typowe przyczyny niejednorodności to zmiana miejsca pomiaru; wiele obserwacji, zwłaszcza opadów atmosferycznych, wykonują wolontariusze w swoim ogródku lub w miejscu pracy. Często nie da się uniknąć zmian w otoczeniu, np. zmian w roślinności, zasklepieniu powierzchni terenu oraz ciepłe i dające schronienie budynki w pobliżu. Zmieniają się również procedury pomiarowe, takie jak sposób obliczania średniej dziennej temperatury (za pomocą temperatur minimalnych i maksymalnych, uśredniania z 3 lub 4 odczytów dziennie lub na podstawie danych 10-minutowych). Również zmiany czasów obserwacji mogą prowadzić do niejednorodności. Niedawny przegląd Trewina koncentrował się na przyczynach niejednorodności.

Niejednorodności nie zawsze są błędami. Jest to najbardziej widoczne w przypadku stacji dotkniętych ociepleniem z powodu efektu miejskiej wyspy ciepła. Z punktu widzenia globalnego ocieplenia takie lokalne skutki są niepożądane, ale do badania wpływu klimatu na zdrowie takie pomiary są w porządku. Inne niejednorodności wynikają z kompromisów, jakie należy poczynić między wentylacją a ochroną przed słońcem i wilgocią przy projektowaniu schronienia przed czynnikami atmosferycznymi. Próba ograniczenia jednego rodzaju błędu (dla określonych warunków pogodowych) w projekcie często prowadzi do większej liczby błędów z innych czynników. Pomiary meteorologiczne nie są wykonywane w laboratorium. Małe błędy są nieuniknione i mogą nie mieć znaczenia dla celów meteorologicznych, ale jeśli taki błąd się zmieni, może to oznaczać niejednorodność dla klimatologii.

Homogenizacja

Aby wiarygodnie zbadać rzeczywisty rozwój klimatu, należy usunąć zmiany inne niż klimatyczne. Data zmiany jest często dokumentowana (tzw. metadane: dane o danych), ale nie zawsze. Metadane są często dostępne tylko w lokalnym języku. W najlepszym przypadku są to równoległe pomiary z oryginalnym i nowym ustawieniem przez kilka lat. To jest WMO ( Światowa Organizacja Meteorologiczna ). Dokonując równoległych pomiarów z replikami historycznych instrumentów, ekranów itp., niektóre z tych niejednorodności można nadal badać.

Ponieważ nigdy nie masz pewności, że Twoje metadane (historia stacji) są kompletne, zawsze należy również stosować homogenizację statystyczną. Najczęściej stosowaną zasadą statystyczną do wykrywania i usuwania skutków sztucznych zmian jest homogenizacja względna, która zakłada, że pobliskie stacje są wystawione na prawie ten sam sygnał klimatyczny, a zatem różnice między pobliskimi stacjami można wykorzystać do wykrycia niejednorodności. Patrząc na szeregi czasowe różnicy, usuwa się zmienność klimatu z roku na rok, a także regionalne trendy klimatyczne. W takiej różnicy szeregów czasowych można łatwo wykryć wyraźny i trwały skok, np. o 1°C, który może być spowodowany jedynie zmianami warunków pomiaru.

Jeśli w różnicowym szeregu czasowym występuje przeskok (przerwa), to nie jest jeszcze jasne, do której z dwóch stacji należy. Ponadto szeregi czasowe zazwyczaj mają więcej niż jeden skok. Te dwie cechy sprawiają, że statystyczna homogenizacja jest trudnym i pięknym problemem statystycznym. Algorytmy homogenizacji zazwyczaj różnią się sposobem rozwiązywania tych dwóch podstawowych problemów.

W przeszłości zwyczajem było obliczanie złożonego szeregu czasowego odniesienia obliczonego z wielu pobliskich stacji, porównywanie tego odniesienia z szeregiem kandydującym i zakładanie, że wszelkie znalezione skoki wynikają z szeregu kandydującego. To ostatnie założenie działa, ponieważ przy użyciu wielu stacji jako odniesienia wpływ niejednorodności na odniesienie jest znacznie zmniejszony. Jednak współczesne algorytmy nie zakładają już, że odniesienie jest jednorodne i może w ten sposób osiągnąć lepsze wyniki. Można to zrobić na dwa główne sposoby. Możesz obliczyć wiele złożonych szeregów czasowych odniesienia z podzbiorów otaczających stacji i przetestować również te odniesienia pod kątem jednorodności. Alternatywnie możesz użyć tylko par stacji i porównując wszystkie pary ze sobą, określ, która stacja najprawdopodobniej jest tą z przerwą. Jeśli w 1950 r. nastąpiła przerwa w parze A&B i B&C, ale nie w A&C, przerwa jest prawdopodobna w stacji B; przy większej liczbie par taki wniosek można wyciągnąć z większą pewnością.

Jeśli w szeregu czasowym występuje wiele przerw, liczba kombinacji łatwo staje się bardzo duża i wypróbowanie ich wszystkich staje się niemożliwe. Na przykład w przypadku pięciu przerw ( k = 5) w ciągu 100 lat danych rocznych ( n = 100) liczba kombinacji wynosi około 100 5 =10 10 lub 10 miliardów. Ten problem jest czasami rozwiązywany iteracyjnie/hierarchicznie, najpierw szukając największego skoku, a następnie powtarzając wyszukiwanie w obu podsekcjach, aż będą za małe. Nie zawsze daje to dobre rezultaty. Bezpośrednim sposobem rozwiązania problemu jest wydajna metoda optymalizacji tzw programowanie dynamiczne .

Czasami nie ma innych stacji w tym samym regionie klimatycznym. W tym przypadku czasami stosuje się homogenizację absolutną i wykrywa się niejednorodności w szeregach czasowych jednej stacji. Jeśli w pewnym momencie nastąpi wyraźna i duża przerwa, można ją skorygować, ale mniejszych skoków i stopniowo pojawiających się niejednorodności (miejska wyspa ciepła czy rosnąca roślinność) nie da się odróżnić od rzeczywistej naturalnej zmienności i zmian klimatu. Dane ujednolicone w ten sposób nie mają oczekiwanej jakości i należy ich używać z dużą ostrożnością.

Niejednorodności danych klimatycznych

Dzięki ujednoliceniu zbiorów danych klimatycznych stwierdzono, że czasami niejednorodności mogą powodować tendencyjne trendy w surowych danych; że homogenizacja jest niezbędna do uzyskania wiarygodnych trendów regionalnych lub globalnych. Na przykład dla regionu wielkoalpejskiego stwierdzono odchylenie trendu temperatury między latami 70. a 80. XIX wieku o pół stopnia, co wynikało ze zmniejszającej się urbanizacji sieci i systematycznych zmian w czasie obserwacji. Zapisy opadów z wczesnego okresu instrumentalnego są obciążone o -10% ze względu na systematyczną wyższą instalację mierników w tym czasie. Innymi możliwymi źródłami odchyleń są nowe typy schronów pogodowych, przejście z termometrów płynnych i szklanych na elektryczne termometry rezystancyjne, a także tendencja do zastępowania obserwatorów automatycznymi stacjami pogodowymi, efekt miejskiej wyspy ciepła i przeniesienie wielu stacji miejskich na lotniska.

Ponadto wykazano, że najnowocześniejsze algorytmy homogenizacji względnej opracowane do pracy z niejednorodnym wzorcem działają najlepiej. Badanie (z EGU) wykazało, że algorytmy automatyczne mogą działać równie dobrze, jak algorytmy ręczne.

Zobacz też

- Zmiany klimatyczne (współczesne)

- Zmiana klimatu (koncepcja ogólna)