Uczciwość (uczenie maszynowe)

Uczciwość w uczeniu maszynowym odnosi się do różnych prób korygowania błędów algorytmicznych w zautomatyzowanych procesach decyzyjnych opartych na modelach uczenia maszynowego. Decyzje podejmowane przez komputery po procesie uczenia maszynowego mogą zostać uznane za niesprawiedliwe, jeśli opierają się na zmiennych uznawanych za wrażliwe . Przykładami tego rodzaju zmiennych są płeć , pochodzenie etniczne , orientacja seksualna , niepełnosprawność i inne. Podobnie jak w przypadku wielu koncepcji etycznych, definicje sprawiedliwości i stronniczości zawsze budzą kontrowersje. Ogólnie rzecz biorąc, sprawiedliwość i stronniczość są uważane za istotne, gdy proces decyzyjny wpływa na życie ludzi. W uczeniu maszynowym problem błędu algorytmicznego jest dobrze znany i dobrze zbadany. Wyniki mogą być zniekształcone przez szereg czynników, a zatem mogą zostać uznane za niesprawiedliwe w odniesieniu do niektórych grup lub osób. Przykładem może być sposób, w jaki serwisy społecznościowe dostarczają konsumentom spersonalizowane wiadomości.

Kontekst

Dyskusja na temat uczciwości w uczeniu maszynowym jest stosunkowo nowym tematem. Od 2016 roku nastąpił gwałtowny wzrost badań na ten temat. Wzrost ten można częściowo przypisać wpływowemu raportowi ProPublica , w którym stwierdzono, że oprogramowanie COMPAS , szeroko stosowane w amerykańskich sądach do przewidywania recydywy , było uprzedzone rasowo. Jednym z tematów badań i dyskusji jest definicja sprawiedliwości, ponieważ nie ma uniwersalnej definicji, a różne definicje mogą być ze sobą sprzeczne, co utrudnia ocenę modeli uczenia maszynowego. Inne tematy badawcze obejmują pochodzenie uprzedzeń, rodzaje uprzedzeń i metody zmniejszania uprzedzeń.

W ostatnich latach firmy technologiczne stworzyły narzędzia i podręczniki, jak wykrywać i redukować błędy w uczeniu maszynowym. IBM ma narzędzia dla Pythona i R z kilkoma algorytmami, które zmniejszają stronniczość oprogramowania i zwiększają jego uczciwość. Google opublikował wytyczne i narzędzia do badania i zwalczania uprzedzeń w uczeniu maszynowym. Facebook zgłosił użycie narzędzia Fairness Flow do wykrywania stronniczości w swojej sztucznej inteligencji . Jednak krytycy argumentowali, że wysiłki firmy są niewystarczające, zgłaszając niewielkie wykorzystanie narzędzia przez pracowników, ponieważ nie można go używać we wszystkich ich programach, a nawet jeśli jest to możliwe, korzystanie z narzędzia jest opcjonalne.

Kontrowersje

Wykorzystanie algorytmicznego podejmowania decyzji w systemie prawnym było godnym uwagi obszarem wykorzystania pod kontrolą. W 2014 roku ówczesny prokurator generalny USA Eric Holder wyraził obawy, że metody „oceny ryzyka” mogą nadmiernie skupiać się na czynnikach pozostających poza kontrolą oskarżonego, takich jak poziom wykształcenia lub sytuacja społeczno-ekonomiczna. W raporcie ProPublica z 2016 r. na temat COMPAS stwierdzono, że prawdopodobieństwo błędnego oznaczenia czarnych oskarżonych jako oskarżonych o wyższym ryzyku było prawie dwa razy większe niż białych oskarżonych, podczas gdy w przypadku białych oskarżonych popełniono odwrotny błąd. Twórca COMPAS , Northepointe Inc., zakwestionował raport, twierdząc, że jego narzędzie jest uczciwe, a ProPublica popełniła błędy statystyczne, które następnie zostały ponownie obalone przez ProPublica.

W algorytmach rozpoznawania obrazu odnotowano również uprzedzenia rasowe i płciowe. Stwierdzono, że wykrywanie twarzy i ruchu w kamerach ignoruje lub błędnie oznacza mimikę osób innych niż biała. W 2015 roku stwierdzono, że funkcja automatycznego tagowania zarówno w serwisie Flickr , jak i Zdjęciach Google oznacza osoby czarnoskóre tagami, takimi jak „zwierzę” i „goryl”. Stwierdzono, że międzynarodowy konkurs piękności z 2016 r. oceniany przez algorytm sztucznej inteligencji był stronniczy w stosunku do osób o jaśniejszej skórze, prawdopodobnie z powodu stronniczości danych treningowych. Badanie trzech komercyjnych algorytmów klasyfikacji płci w 2018 roku wykazało, że wszystkie trzy algorytmy były generalnie najdokładniejsze przy klasyfikacji jasnoskórych mężczyzn i najgorsze przy klasyfikacji ciemnoskórych kobiet. wykazano , że narzędzie do przycinania zdjęć z Twittera preferuje twarze o jaśniejszej karnacji. DALL-E , model uczenia maszynowego zamiany tekstu na obraz, wprowadzony na rynek w 2021 r., ma skłonność do tworzenia rasistowskich i seksistowskich obrazów, które wzmacniają społeczne stereotypy, co zostało przyznane przez jego twórców.

Inne obszary, w których stosowane są algorytmy uczenia maszynowego, które okazały się stronnicze, to aplikacje o pracę i pożyczki. Amazon używał oprogramowania do przeglądania seksistowskich podań o pracę, na przykład karząc CV zawierające słowo „kobiety”. W 2019 roku Apple do określania limitów kart kredytowych dla ich nowej karty Apple nadawał znacznie wyższe limity mężczyznom niż kobietom, nawet w przypadku par, które dzieliły swoje finanse. W raporcie The Markup z 2021 r. wykazano, że algorytmy zatwierdzania kredytów hipotecznych używane w USA częściej odrzucają wnioskodawców innych niż biały .

Kryteria uczciwości grupy

W problemach klasyfikacją uczy się funkcji przewidywania cechy dyskretnej zmiennej docelowej, na podstawie znanych cech Modelujemy jako dyskretną zmienną losową , która koduje pewne cechy zawarte lub niejawnie zakodowane w , które uważamy za cechy wrażliwe (płeć, pochodzenie etniczne, orientacja seksualna itp.) końcu oznaczamy przez klasyfikatora . Zdefiniujmy teraz trzy główne kryteria oceny, czy dany klasyfikator jest sprawiedliwy, to znaczy czy na jego przewidywania nie mają wpływu niektóre z tych wrażliwych zmiennych.

Niezależność

Mówimy, że zmienne losowe spełniają niezależność , jeśli wrażliwe cechy statystycznie niezależne od przewidywania i piszemy

Jeszcze inne równoważne wyrażenie na niezależność można podać, korzystając z koncepcji wzajemnej informacji między zmiennymi losowymi , zdefiniowanej jako

Możliwe złagodzenie definicji niezależności obejmuje wprowadzenie dodatniego luzu i jest określone wzorem:

Wreszcie, innym możliwym złagodzeniem jest wymaganie .

Separacja

Mówimy, że spełniają warunki , charakterystyki statystycznie niezależne od pod value i piszemy

Innym równoważnym wyrażeniem, w przypadku binarnego wskaźnika docelowego, jest to, że odsetek wyników prawdziwie dodatnich i odsetek wyników fałszywie dodatnich jest równy (a zatem odsetek wyników fałszywie ujemnych i odsetek wyników prawdziwie ujemnych są równe) dla każdej wartości cech wrażliwych:

wartość różnicy między stawkami była liczbą dodatnią mniejszą dany luz , a nie równą zeru.

W niektórych polach separacja (współczynnik separacji) w macierzy zamieszania jest miarą odległości (przy danym poziomie wyniku prawdopodobieństwa) między przewidywanym skumulowanym procentem ujemnym a przewidywanym skumulowanym procentem dodatnim.

Im większy jest ten współczynnik separacji przy danej wartości punktowej, tym skuteczniejszy jest model w rozróżnianiu zbioru pozytywów i negatywów przy określonej granicy prawdopodobieństwa. Według Mayesa: „W branży kredytowej często obserwuje się, że wybór miar walidacyjnych zależy od podejścia do modelowania. Na przykład, jeśli procedura modelowania jest parametryczna lub półparametryczna, często stosuje się test KS dla dwóch prób . model jest wyprowadzany za pomocą heurystycznych lub iteracyjnych metod wyszukiwania, miarą wydajności modelu jest zwykle dywergencja Trzecią opcją jest współczynnik separacji… Współczynnik separacji, w porównaniu z pozostałymi dwiema metodami, wydaje się najbardziej rozsądny jako miara dla wydajności modelu, ponieważ odzwierciedla wzór separacji modelu”.

Dostateczność

Mówimy, że losowe spełniają wystarczalność jeśli charakterystyki wrażliwe statystycznie niezależne od wartości docelowej, uwagę przewidywanie i piszemy

Relacje między definicjami

Na koniec podsumowujemy niektóre z głównych wyników, które odnoszą się do trzech definicji podanych powyżej:

- Zakładając , że jest binarny, jeśli i nie są statystycznie niezależne , a i nie są statystycznie niezależne , to niezależność i separacja nie mogą jednocześnie istnieć.

- Jeśli jako wspólny rozkład ma dodatnie prawdopodobieństwo dla wszystkich możliwych wartości i nie są statystycznie niezależne , i wtedy separacja i wystarczalność nie mogą jednocześnie obowiązywać.

Matematyczne formułowanie definicji słuszności grupowej

Definicje wstępne

Większość statystycznych miar sprawiedliwości opiera się na różnych metrykach, więc zaczniemy od ich zdefiniowania. Podczas pracy z binarnym zarówno klasa przewidywana, jak i rzeczywista mogą przyjmować dwie wartości: dodatnią i ujemną. Teraz zacznijmy wyjaśniać różne możliwe relacje między przewidywanym a rzeczywistym wynikiem:

- Prawdziwie pozytywne (TP) : Przypadek, w którym zarówno przewidywany, jak i rzeczywisty wynik należą do klasy pozytywnej.

- Prawdziwie negatywny (TN) : Przypadek, w którym zarówno przewidywany wynik, jak i rzeczywisty wynik są przypisane do klasy negatywnej.

- Fałszywie pozytywna (FP) : Przypadek, który według przewidywań trafi do klasy pozytywnej przypisanej w rzeczywistym wyniku, jest przypadkiem negatywnym.

- Fałszywie negatywny (FN) : Przypadek, który przewiduje się w klasie negatywnej z faktycznym wynikiem, jest w pozytywnym.

Relacje te można łatwo przedstawić za pomocą macierzy zamieszania , tabeli opisującej dokładność modelu klasyfikacji. W tej macierzy kolumny i wiersze przedstawiają odpowiednio wystąpienia przewidywanych i rzeczywistych przypadków.

Korzystając z tych relacji, możemy zdefiniować wiele metryk, które można później wykorzystać do pomiaru rzetelności algorytmu:

- Pozytywna przewidywana wartość (PPV) : ułamek przypadków pozytywnych, które zostały prawidłowo przewidziane spośród wszystkich pozytywnych prognoz. Jest to zwykle określane jako precyzja i reprezentuje prawdopodobieństwo prawidłowej pozytywnej prognozy. Podaje się go za pomocą następującego wzoru:

- Współczynnik fałszywych odkryć (FDR) : odsetek pozytywnych prognoz, które w rzeczywistości były negatywne, spośród wszystkich pozytywnych prognoz. Reprezentuje prawdopodobieństwo błędnej pozytywnej prognozy i wyraża się następującym wzorem:

- Przewidywana wartość ujemna (NPV) : ułamek przypadków ujemnych, które zostały prawidłowo przewidziane spośród wszystkich prognoz ujemnych. Reprezentuje prawdopodobieństwo prawidłowej prognozy negatywnej i wyraża się następującym wzorem:

- Wskaźnik fałszywych pominięć (FOR) : odsetek negatywnych prognoz, które były faktycznie pozytywne, spośród wszystkich negatywnych prognoz. Reprezentuje prawdopodobieństwo błędnej prognozy negatywnej i wyraża się następującym wzorem:

- Prawdziwie pozytywny wskaźnik (TPR) : odsetek przypadków dodatnich, które zostały prawidłowo przewidziane spośród wszystkich przypadków dodatnich. Nazywa się to zwykle wrażliwością lub pamięcią i reprezentuje prawdopodobieństwo , że pozytywne osoby zostaną poprawnie sklasyfikowane jako takie. Jest ona dana wzorem:

- Odsetek wyników fałszywie ujemnych (FNR) : odsetek przypadków dodatnich, w przypadku których błędnie przewidywano, że będą ujemne, spośród wszystkich przypadków dodatnich. Reprezentuje prawdopodobieństwo błędnego zaklasyfikowania podmiotów pozytywnych jako negatywnych i wyraża się wzorem:

- Prawdziwie ujemny wskaźnik (TNR) : odsetek przypadków ujemnych, które zostały prawidłowo przewidziane spośród wszystkich przypadków ujemnych. Reprezentuje prawdopodobieństwo , że podmioty negatywne zostaną poprawnie sklasyfikowane jako takie i wyraża się wzorem:

- Odsetek wyników fałszywie dodatnich (FPR) : odsetek przypadków ujemnych, w przypadku których błędnie przewidywano, że będą dodatnie, spośród wszystkich przypadków ujemnych. Reprezentuje prawdopodobieństwo błędnego zaklasyfikowania podmiotów negatywnych jako pozytywnych i wyraża się wzorem:

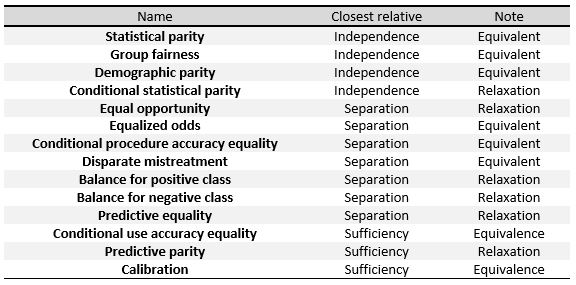

Poniższe kryteria można rozumieć jako miary trzech ogólnych definicji podanych na początku tej sekcji, a mianowicie Niezależność , Separacja i Wystarczalność . W tabeli po prawej stronie widzimy zależności między nimi.

Aby konkretnie zdefiniować te miary, podzielimy je na trzy duże grupy, tak jak zrobili to Verma i in.: definicje oparte na przewidywanym wyniku, na przewidywanych i rzeczywistych wynikach oraz definicje oparte na przewidywanym prawdopodobieństwie i rzeczywistym wyniku.

Będziemy pracować z klasyfikatorem binarnym i następującą notacją: się do wyniku podanego przez klasyfikator, który jest prawdopodobieństwem, że dany podmiot znajdzie się w klasie pozytywnej lub negatywnej reprezentuje ostateczną klasyfikację przewidzianą przez algorytm, a jej wartość jest zwykle wyprowadzana z na przykład będzie dodatnia, gdy przekroczy określony próg. reprezentuje rzeczywisty wynik, to znaczy rzeczywistą klasyfikację jednostki i wreszcie oznacza wrażliwe cechy badanych.

Definicje oparte na przewidywanym wyniku

Definicje w tej sekcji koncentrują się na przewidywanym wyniku różnych przedmiotów . Są to najprostsze i najbardziej intuicyjne pojęcia sprawiedliwości.

- Parytet demograficzny , zwany także parytetem statystycznym , parytetem akceptacji i benchmarkingiem . Klasyfikator spełnia tę definicję, jeśli podmioty w grupach chronionych i niechronionych mają równe prawdopodobieństwo przypisania do dodatniej przewidywanej klasy. Dzieje się tak, jeśli spełniony jest następujący wzór:

- Warunkowy parytet statystyczny . Zasadniczo składa się z powyższej definicji, ale ogranicza się tylko do podzbioru instancji. W notacji matematycznej byłoby to:

Definicje oparte na przewidywanych i rzeczywistych wynikach

nie tylko uwzględniają przewidywany wynik, go z rzeczywistym wynikiem .

- Predykcyjny parytet , zwany także testem wyniku . Klasyfikator spełnia tę definicję, jeśli podmioty w grupach chronionych i niechronionych mają równe PPV. Dzieje się tak, jeśli spełniona jest następująca formuła:

- Matematycznie, jeśli klasyfikator ma równe PPV dla obu grup, będzie miał również równe FDR, spełniając wzór:

- Fałszywie dodatnie saldo stopy błędów , określane również jako predykcyjna równość . Klasyfikator spełnia tę definicję, jeśli badani w grupach chronionych i niechronionych mają równe FPR. Dzieje się tak, jeśli spełniony jest następujący wzór:

- Matematycznie, jeśli klasyfikator ma równy FPR dla obu grup, będzie miał również równy TNR, spełniając wzór:

- Saldo fałszywie ujemnego poziomu błędu , określane również mianem równych szans . Klasyfikator spełnia tę definicję, jeśli badani w grupach chronionych i niechronionych mają równe FNR. Dzieje się tak, jeśli spełniony jest następujący wzór:

- Matematycznie, jeśli klasyfikator ma równy FNR dla obu grup, będzie miał również równy TPR, spełniając wzór:

- Wyrównane szanse , określane również jako procedura warunkowa, dokładność, równość i odmienne traktowanie . Klasyfikator spełnia tę definicję, jeśli podmioty w grupach chronionych i niechronionych mają równe TPR i równe FPR, spełniając wzór:

- Warunkowa równość dokładności użycia . Klasyfikator spełnia tę definicję, jeśli podmioty w grupie chronionej i niechronionej mają równe PPV i równe NPV, spełniające wzór:

- Ogólna równość dokładności . Klasyfikator spełnia tę definicję, jeśli podmiot w grupie chronionej i niechronionej ma taką samą dokładność predykcji, czyli prawdopodobieństwo przypisania do niego podmiotu z jednej klasy. Dzieje się tak, jeśli spełnia następującą formułę:

- Równość traktowania . Klasyfikator spełnia tę definicję, jeśli podmioty w grupach chronionych i niechronionych mają równy stosunek FN i FP, spełniający wzór:

Definicje oparte na przewidywanych prawdopodobieństwach i rzeczywistych wynikach

na rzeczywistym wyniku wyniku prawdopodobieństwa .

- Rzetelność testu , znana również jako kalibracja lub dopasowywanie częstotliwości warunkowych . Klasyfikator spełnia tę definicję, jeśli osoby z tym samym przewidywanym wynikiem prawdopodobieństwa mają takie samo prawdopodobieństwo sklasyfikowania w klasie pozytywnej, gdy należą do grupy chronionej lub niechronionej: S {

- Dobra kalibracja jest rozszerzeniem poprzedniej definicji. Stwierdza, że gdy osoby z grupy chronionej lub spoza niej mają ten sam przewidywany wynik prawdopodobieństwa, mieć takie samo prawdopodobieństwo zaklasyfikowania do klasy pozytywnej, a prawdopodobieństwo to musi być równe :

- Bilans dla klasy pozytywnej . Klasyfikator spełnia tę definicję, jeśli podmioty tworzące klasę pozytywną zarówno z grup chronionych, jak i niechronionych mają równy średni przewidywany . Oznacza to, że oczekiwana wartość wyniku prawdopodobieństwa dla grup chronionych i niechronionych z pozytywnym faktycznym wynikiem jest taka sama, spełniając wzór:

- Saldo dla klasy ujemnej . Klasyfikator spełnia tę definicję, jeśli podmioty stanowiące klasę negatywną zarówno z grup chronionych, jak i niechronionych, mają równy średni przewidywany . Oznacza to, że oczekiwana wartość wyniku prawdopodobieństwa dla grup chronionych i niechronionych z ujemnym rzeczywistym wynikiem jest taka sama, spełniając wzór:

Funkcja pomocy społecznej

Niektórzy uczeni zaproponowali zdefiniowanie sprawiedliwości algorytmicznej w kategoriach funkcji dobrobytu społecznego . Twierdzą, że użycie funkcji opieki społecznej umożliwia projektantowi algorytmu rozważenie uczciwości i dokładności predykcyjnej pod względem korzyści dla osób, na które algorytm ma wpływ. Pozwala również projektantowi na kompromis między wydajnością a sprawiedliwością w pryncypialny sposób. Sendhil Mullainathan stwierdził, że projektanci algorytmów powinni wykorzystywać funkcje opieki społecznej w celu rozpoznania bezwzględnych korzyści dla grup w niekorzystnej sytuacji. Na przykład badanie wykazało, że stosowanie algorytmu decyzyjnego w areszcie tymczasowym zamiast czystego osądu ludzkiego zmniejszyło ogólne wskaźniki zatrzymań dla Czarnych, Latynosów i mniejszości rasowych, nawet przy utrzymaniu stałego wskaźnika przestępczości.

Indywidualne kryteria uczciwości

Ważnym rozróżnieniem między definicjami słuszności jest rozróżnienie między pojęciami grupowymi i indywidualnymi. Z grubsza mówiąc, podczas gdy kryteria sprawiedliwości grupowej porównują ilości na poziomie grupy, zwykle identyfikowane przez wrażliwe atrybuty (np. płeć, pochodzenie etniczne, wiek itp.), kryteria indywidualne porównują jednostki. Innymi słowy, indywidualna sprawiedliwość jest zgodna z zasadą, że „podobne osoby powinny być traktowane w podobny sposób”.

Istnieje bardzo intuicyjne podejście do uczciwości, które zwykle nosi nazwę Uczciwości przez nieświadomość (FTU) lub Zaślepienie , które zaleca, aby nie wykorzystywać jawnie wrażliwych funkcji podczas podejmowania (zautomatyzowanych) decyzji. Jest to w rzeczywistości pojęcie indywidualnej sprawiedliwości, ponieważ dwie osoby różniące się tylko wartościami swoich wrażliwych atrybutów uzyskałyby ten sam wynik.

Jednak ogólnie rzecz biorąc, FTU ma kilka wad, z których główną jest to, że nie bierze pod uwagę możliwych korelacji między atrybutami wrażliwymi a atrybutami niewrażliwymi stosowanymi w procesie podejmowania decyzji. Na przykład agent z (złośliwym) zamiarem dyskryminacji ze względu na płeć mógłby wprowadzić do modelu zmienną zastępczą dla płci (tj. recepta FTU.

Problem tego, które zmienne skorelowane ze zmiennymi wrażliwymi są dość możliwe do zastosowania przez model w procesie podejmowania decyzji, jest kluczowy i ma znaczenie również dla koncepcji grupowych : metryki niezależności wymagają całkowitego usunięcia wrażliwych informacji, podczas gdy metryki oparte na separacji pozwalają na korelację, ale tylko w takim stopniu, w jakim oznaczona zmienna docelowa „uzasadnia” je.

Najbardziej ogólna koncepcja indywidualnej sprawiedliwości została wprowadzona w pionierskiej pracy Cynthii Dwork i współpracowników w 2012 roku i można ją traktować jako matematyczne tłumaczenie zasady, że mapa decyzyjna przyjmująca cechy jako dane wejściowe powinna być zbudowana w taki sposób, aby była w stanie „ mapuj podobne osobniki podobnie”, co jest wyrażone jako warunek Lipschitza na mapie modelu. Nazywają to podejście Fairness Through Awareness (FTA), dokładnie jako kontrapunkt do FTU, ponieważ podkreślają znaczenie wyboru odpowiedniej miary odległości związanej z celem, aby ocenić, które osoby są podobne w określonych sytuacjach. Ponownie, problem ten jest bardzo powiązany z podniesioną powyżej kwestią dotyczącą tego, jakie zmienne można postrzegać jako „uzasadnione” w określonych kontekstach.

Metryki oparte na przyczynowości

Sprawiedliwość przyczynowa mierzy częstotliwość, z jaką dwaj prawie identyczni użytkownicy lub aplikacje różniące się tylko zestawem cech, w odniesieniu do których alokacja zasobów musi być sprawiedliwa, są traktowani identycznie. Cała gałąź badań akademickich nad miarami rzetelności jest poświęcona wykorzystaniu modeli przyczynowych do oceny stronniczości w modelach uczenia maszynowego . Podejście to jest zwykle uzasadnione faktem, że ten sam obserwacyjny rozkład danych może ukrywać różne związki przyczynowe między wchodzącymi w grę zmiennymi, być może z różnymi interpretacjami tego, czy na wynik ma wpływ jakaś forma błędu systematycznego, czy nie.

Kusnera i in. zaproponować zastosowanie scenariusza kontrfaktycznego i zdefiniować proces decyzyjny kontrfaktycznie sprawiedliwy , jeśli dla dowolnej osoby wynik nie zmieni się w scenariuszu kontrfaktycznym, w którym zmienione zostaną wrażliwe atrybuty. Formuła matematyczna brzmi:

: wzięto losową osobę z wrażliwym atrybutem cechami samą osobę, gdyby miała , powinny mieć takie same szanse na przyjęcie. Symbol reprezentuje kontrfaktyczną zmienną losową w scenariuszu, w którym wrażliwy atrybut R ustalona na . Warunkowanie na oznacza, że wymaganie to jest na poziomie indywidualnym, ponieważ warunkowamy wszystkie zmienne identyfikujące pojedynczą obserwację.

Modele uczenia maszynowego są często szkolone na danych, których wynik zależał od decyzji podjętej w danym momencie. Na przykład, jeśli model uczenia maszynowego musi określić, czy osadzony będzie recytował i czy powinien zostać zwolniony wcześniej, wynik może zależeć od tego, czy osadzony został zwolniony wcześniej, czy nie. Mishler i in. zaproponuj wzór na alternatywne wyrównane szanse:

gdzie jest zmienną losową, wynik, biorąc pod uwagę, że decyzja jest wrażliwą .

Strategie łagodzenia uprzedzeń

Uczciwość można zastosować do algorytmów uczenia maszynowego na trzy różne sposoby: wstępne przetwarzanie danych , optymalizacja podczas szkolenia oprogramowania lub wyniki przetwarzania końcowego algorytmu.

Przetwarzanie wstępne

Zwykle klasyfikator nie jest jedynym problemem; zbiór danych jest również stronniczy. Dyskryminację zbioru danych w odniesieniu do grupy można zdefiniować w następujący sposób: re {\ textstyle D

To znaczy przybliżenie różnicy między prawdopodobieństwami przynależności do klasy pozytywnej, biorąc pod uwagę, że podmiot ma chronioną cechę inną niż i równą .

Algorytmy korygujące błąd systematyczny podczas przetwarzania wstępnego usuwają informacje o zmiennych zestawu danych, co może skutkować niesprawiedliwymi decyzjami, jednocześnie starając się zmienić jak najmniej. Nie jest to tak proste, jak usunięcie wrażliwej zmiennej, ponieważ inne atrybuty mogą być skorelowane z chronionym.

Sposobem na to jest mapowanie każdej osoby w początkowym zbiorze danych na reprezentację pośrednią, w której niemożliwe jest określenie, czy należy ona do określonej chronionej grupy przy zachowaniu jak największej ilości informacji. Następnie nowa reprezentacja danych jest dostosowywana, aby uzyskać maksymalną dokładność algorytmu.

W ten sposób osoby są odwzorowywane na nową reprezentację wielu zmiennych, w której prawdopodobieństwo przypisania dowolnego członka grupy chronionej do określonej wartości w nowej reprezentacji jest takie samo jak prawdopodobieństwo osoby, która nie należy do grupy chronionej . Następnie ta reprezentacja jest używana do uzyskania prognozy dla osoby zamiast danych początkowych. Ponieważ reprezentacja pośrednia jest skonstruowana z takim samym prawdopodobieństwem dla osób z grupy chronionej lub spoza niej, atrybut ten jest ukryty dla klasyfikatora.

Przykład wyjaśniono w Zemel et al. gdzie wielomianowa zmienna losowa jest używana jako reprezentacja pośrednia. W tym procesie system jest zachęcany do zachowania wszystkich informacji z wyjątkiem tych, które mogą prowadzić do stronniczych decyzji, oraz do uzyskania jak najdokładniejszej prognozy.

Z jednej strony ta procedura ma tę zaletę, że wstępnie przetworzone dane można wykorzystać do dowolnego zadania uczenia maszynowego. Ponadto klasyfikator nie musi być modyfikowany, ponieważ poprawka jest stosowana do zbioru danych przed przetwarzaniem. Z drugiej strony inne metody uzyskują lepsze wyniki pod względem dokładności i rzetelności.

Ponowne ważenie

Ponowne ważenie jest przykładem algorytmu przetwarzania wstępnego. Chodzi o to, aby przypisać wagę do każdego punktu zestawu danych, tak aby ważona dyskryminacja wynosiła 0 w odniesieniu do wyznaczonej grupy.

Gdyby zbiór danych wrażliwa zmienna docelowa statystycznie niezależne a prawdopodobieństwo łącznego rozkładu byłoby iloczynem prawdopodobieństw w następujący sposób :

W rzeczywistości jednak zbiór danych nie jest obiektywny, a zmienne nie są statystycznie niezależne , więc obserwowane prawdopodobieństwo jest następujące:

Aby zrekompensować odchylenie, oprogramowanie dodaje wagę , niższą dla ulubionych obiektów i wyższą dla nieuprzywilejowanych obiektów. Dla każdego otrzymujemy:

mamy powiązaną wagę, ważoną dyskryminację w odniesieniu do grupy sposób: X {

Można wykazać, że po ponownym zważeniu ta ważona dyskryminacja wynosi 0.

W przetwórstwie

Innym podejściem jest korygowanie odchylenia w czasie treningu. Można to zrobić, dodając ograniczenia do celu optymalizacji algorytmu. Te ograniczenia zmuszają algorytm do poprawy uczciwości, utrzymując te same stawki niektórych miar dla chronionej grupy i pozostałych jednostek. Na przykład, możemy dodać do celu algorytmu warunek , że odsetek wyników fałszywie dodatnich jest taki sam dla osób z grupy chronionej i spoza grupy chronionej.

Główne miary stosowane w tym podejściu to odsetek wyników fałszywie dodatnich, odsetek wyników fałszywie ujemnych i ogólny odsetek błędnych klasyfikacji. Możliwe jest dodanie tylko jednego lub kilku z tych ograniczeń do celu algorytmu. Zauważ, że równość fałszywie ujemnych wskaźników implikuje równość prawdziwie dodatnich stóp, więc implikuje to równość szans. Po dodaniu ograniczeń do problemu może on stać się trudny do rozwiązania, więc konieczne może być złagodzenie ich.

Ta technika daje dobre wyniki w poprawie uczciwości przy zachowaniu wysokiej dokładności i pozwala programiście wybrać miary uczciwości do poprawy. Jednak każde zadanie uczenia maszynowego może wymagać zastosowania innej metody i modyfikacji kodu w klasyfikatorze, co nie zawsze jest możliwe.

Odrzucenie stronniczości

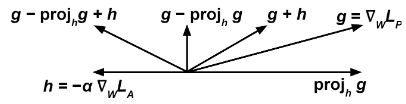

Uczymy jednocześnie dwa klasyfikatory za pomocą pewnej metody opartej na gradiencie (np. Gradient Descent ). Pierwszy, predyktor próbuje wykonać zadanie przewidywania zmiennej docelowej, biorąc pod uwagę , modyfikując jej wagi zminimalizować funkcję . Drugi, próbuje wykonać zadanie przewidzenia wrażliwej zmiennej, biorąc pod jej zminimalizować ZA .

to, że aby poprawnie się propagować, musi odnosić się do surowego wyniku klasyfikatora, a nie do przewidywania dyskretnego na przykład w przypadku sztucznej sieci neuronowej i problemu z klasyfikacją odnosić się do danych wyjściowych .

aktualizujemy , aby zminimalizować zgodnie z i modyfikujemy zgodnie z wyrażeniem:

że chcemy, aby próbował zminimalizować ( termin gdy w tym samym czasie zmaksymalizuj (stąd termin ), aby przeciwnik nie przewidział wrażliwa zmienna z .

Wyrażenie uniemożliwia predyktorowi poruszanie się w kierunku, który pomaga przeciwnikowi zmniejszyć jego funkcję straty.

Można wykazać, że uczenie modelu klasyfikacji predyktorów za pomocą tego algorytmu poprawia parytet demograficzny w odniesieniu do uczenia go bez przeciwnika .

Przetwarzanie końcowe

Ostateczna metoda próbuje poprawić wyniki klasyfikatora, aby osiągnąć rzetelność. W tej metodzie mamy klasyfikator, który zwraca wynik dla każdej osoby i musimy wykonać dla nich prognozę binarną. Wysokie wyniki prawdopodobnie dadzą pozytywny wynik, podczas gdy niskie wyniki prawdopodobnie dadzą wynik negatywny, ale możemy dostosować próg, aby określić, kiedy należy odpowiedzieć tak, zgodnie z życzeniem. Należy zauważyć, że zmiany wartości progowej wpływają na kompromis między współczynnikami prawdziwie dodatnich i prawdziwie ujemnych wyników.

Jeśli funkcja punktacji jest sprawiedliwa w tym sensie, że jest niezależna od chronionego atrybutu, to każdy wybór progu będzie również sprawiedliwy, ale klasyfikatory tego typu są zwykle stronnicze, więc dla każdej chronionej grupy może być wymagany inny próg aby osiągnąć sprawiedliwość. Sposobem na to jest wykreślenie wskaźnika wyników prawdziwie dodatnich w stosunku do wskaźnika wyników fałszywie ujemnych przy różnych ustawieniach progów (nazywa się to krzywą ROC) i znalezienie progu, w którym wskaźniki dla grupy chronionej i innych osób są równe.

Zalety przetwarzania końcowego obejmują to, że technika ta może być stosowana po dowolnych klasyfikatorach, bez ich modyfikowania, i ma dobre wyniki w miarach sprawiedliwości. Wady to konieczność dostępu do chronionego atrybutu w czasie testowym oraz brak wyboru w równowadze między dokładnością a rzetelnością.

Odrzuć klasyfikację opartą na opcjach

Biorąc pod uwagę klasyfikator , niech prawdopodobieństwem obliczonym przez klasyfikatory jako że dodatniej Kiedy jest bliskie 1 lub 0, instancja z dużym stopniem pewności jako należąca odpowiednio do klasy + lub -. Jednak gdy jest bliżej

Mówimy, że jest „odrzuconą instancją”, jeśli pewnym takim, że .

Algorytm „ROC” polega na sklasyfikowaniu instancji nieodrzuconych zgodnie z powyższą regułą i instancji odrzuconych w następujący sposób: jeśli instancja jest przykładem grupy ubogiej ( X ( ZA ) = za { ), a następnie oznacz to jako dodatnie, w przeciwnym razie oznacz jako ujemne.

Możemy zoptymalizować różne miary dyskryminacji (link) jako funkcje optymalne dla każdego problemu i uniknąć dyskryminowania grupy uprzywilejowanej.

Zobacz też

- ^ Caton, Szymon; Haas, chrześcijanin (2020-10-04). „Uczciwość w uczeniu maszynowym: ankieta”. arXiv : 2010.04053 .

- ^ a b Mattu, Julia Angwin, Jeff Larson, Lauren Kirchner, Surya. „Stronniczość maszyny” . ProPublica . Źródło 2022-04-16 .

- ^ Friedler, Sorelle A.; Scheidegger, Carlos; Venkatasubramanian, Suresh (kwiecień 2021). „(Nie) możliwość uczciwości: różne systemy wartości wymagają różnych mechanizmów sprawiedliwego podejmowania decyzji” . Komunikaty ACM . 64 (4): 136–143. doi : 10.1145/3433949 . ISSN 0001-0782 . S2CID 1769114 .

- ^ Mehrabi, Ninareh; Morstatter, Fred; Saxena, Nripsuta; Lerman, Krystyna; Galstyan, Aram (2021-07-13). „Badanie dotyczące uprzedzeń i uczciwości w uczeniu maszynowym” . Ankiety komputerowe ACM . 54 (6): 115:1–115:35. ar Xiv : 1908.09635 . doi : 10.1145/3457607 . ISSN 0360-0300 . S2CID 201666566 .

- ^ „AI Fairness 360” . aif360.mybluemix.net . Źródło 2022-11-18 .

- ^ „Zestaw narzędzi open source IBM AI Fairness 360 dodaje nowe funkcje” . Republika Technologiczna. 4 czerwca 2020 r.

- ^ „Odpowiedzialne praktyki AI” . sztuczna inteligencja Google . Źródło 2022-11-18 .

- ^ Wskaźniki uczciwości , tensorflow, 10.11.2022 , pobrane 18.11.2022

- ^ „Jak używamy Fairness Flow, aby pomóc w budowaniu sztucznej inteligencji, która działa lepiej dla wszystkich” . ai.facebook.com . Źródło 2022-11-18 .

- ^ „Eksperci AI ostrzegają, że narzędzie Facebooka do przeciwdziałania uprzedzeniom jest„ całkowicie niewystarczające ”” . VentureBeat . 2021-03-31 . Źródło 2022-11-18 .

- ^ „Prokurator generalny Eric Holder przemawia na 57. dorocznym spotkaniu National Association of Criminal Defense Lawyers i 13. State Criminal Justice Network Conference” . www.sprawiedliwość.gov . 2014-08-01 . Źródło 2022-04-16 .

- ^ Dieterich, William; Mendoza, Krystyna; Brennan, Tim (2016). „Skale ryzyka COMPAS: demonstrowanie dokładnego kapitału własnego i parytetu przewidywań” (PDF) . Northpointe Inc.

- ^ Angwin, Jeff Larson, Julia. „Reakcja techniczna na Northpointe” . ProPublica . Źródło 2022-11-18 .

- ^ Róża, Adam (22.01.2010). „Czy kamery do wykrywania twarzy są rasistowskie?” . Czas . ISSN 0040-781X . Źródło 2022-11-18 .

- ^ „Google przeprasza za rasistowskie automatyczne tagowanie w aplikacji do zdjęć” . Strażnik . 2015-07-01 . Źródło 2022-04-16 .

- ^ „Konkurs piękności był oceniany przez sztuczną inteligencję, a roboty nie lubiły ciemnej skóry” . Strażnik . 2016-09-08 . Źródło 2022-04-16 .

- ^ Buolamwini, Radość ; Gebru, Timnit (luty 2018). Odcienie płci: przekrojowe różnice w dokładności w komercyjnej klasyfikacji płci (PDF) . Konferencja na temat uczciwości, odpowiedzialności i przejrzystości. Nowy Jork, NY, USA. s. 77–91.

- ^ „Student udowadnia, że algorytm Twittera jest„ nastawiony ”w kierunku jaśniejszych, szczuplejszych, młodszych twarzy” . Strażnik . 2021-08-10 . Źródło 2022-11-18 .

- ^ openai/dalle-2-preview , OpenAI, 17.11.2022 , pobrane 18.11.2022

- ^ „Amazon likwiduje tajne narzędzie rekrutacyjne AI, które wykazywało uprzedzenia wobec kobiet” . Reutera . 2018-10-10 . Źródło 2022-11-18 .

- ^ „Algorytm Apple Card wywołuje zarzuty dotyczące uprzedzeń ze względu na płeć przeciwko Goldman Sachs” . Washington Post . ISSN 0190-8286 . Źródło 2022-11-18 .

- ^ Martinez, Emmanuel; Kirchner, Lauren. „Sekretne odchylenie ukryte w algorytmach zatwierdzania kredytów hipotecznych - znaczniki” . themarkup.org . Źródło 2022-11-18 .

- ^ a b c d Solon Barocas; Moritza Hardta; Arvind Narayanan, Uczciwość i uczenie maszynowe . Źródło 15 grudnia 2019 r.

- ^ Mayes, Elżbieta (2001). Podręcznik punktacji kredytowej . NY, NY, USA: Wydawnictwo Glenlake. P. 282. ISBN 0-8144-0619-X .

- ^ a b c Verma, Sahil i Julia Rubin. „Wyjaśnienie definicji uczciwości”. W 2018 r. międzynarodowe warsztaty IEEE/ACM dotyczące uczciwości oprogramowania (fairware), s. 1-7. IEEE, 2018.

- ^ Chen, Fioletowy (Xinying); Prostytutka, JN (2021). „Uczciwość oparta na dobrobycie poprzez optymalizację”. arXiv : 2102.00311 [ cs.AI ].

-

^

Mullainathan, Sendhil (19 czerwca 2018). Sprawiedliwość algorytmiczna i funkcja opieki społecznej . Przemówienie na 19. Konferencji ACM na temat ekonomii i obliczeń (EC'18) . Youtube. 48 minut.

Innymi słowy, jeśli masz funkcję opieki społecznej, gdzie zależy ci na krzywdzie i troszczysz się o krzywdę Afroamerykanów, proszę bardzo: 12 procent mniej Afroamerykanów w więzieniach z dnia na dzień... Przed wchodzimy w szczegóły krzywdy względnej, funkcja dobrobytu jest zdefiniowana jako krzywda bezwzględna, więc powinniśmy najpierw obliczyć szkodę bezwzględną.

- Bibliografia _ Potaż, Eric; Barocas, Solon; d'Amour, Aleksander; Lum, Kristian (2021). „Uczciwość algorytmiczna: wybory, założenia i definicje” . Roczny przegląd statystyk i ich zastosowanie . 8 (1): 141–163. Bibcode : 2021AnRSA...8..141M . doi : 10.1146/annurev-statistics-042720-125902 . S2CID 228893833 .

- ^ Castelnovo, Alessandro; Crupi, Riccardo; Greco, Greta; Regoli, Daniele; Penco, Ilaria Giuseppina; Cosentini, Andrea Claudio (2022). „Wyjaśnienie niuansów w krajobrazie wskaźników uczciwości” . Raporty naukowe . 12 (1): 4209. arXiv : 2106.00467 . Bibcode : 2022NatSR..12.4209C . doi : 10.1038/s41598-022-07939-1 . PMC 8913820 . PMID 35273279 .

- ^ Mehrabi, Ninareh, Fred Morstatter, Nripsuta Saxena, Kristina Lerman i Aram Galstyan. „Ankieta dotycząca uprzedzeń i uczciwości w uczeniu maszynowym”. ACM Computing Surveys (CSUR) 54, no. 6 (2021): 1-35.

- ^ Dwork, Cynthia; Hardt, Moritz; Pitassi, Toniann; Reingold, Omer; Zemel, Richard (2012). „Sprawiedliwość poprzez świadomość” . Materiały z III Konferencji Innowacje w Informatyce Teoretycznej nt. -ITCS '12 . s. 214–226. doi : 10.1145/2090236.2090255 . ISBN 9781450311151 . S2CID 13496699 .

- Bibliografia _ Brun, Jurij; Meliou, Aleksandra (2017). Testowanie uczciwości: Testowanie oprogramowania pod kątem dyskryminacji . Materiały z 11. wspólnego spotkania Europejskiej Konferencji Inżynierii Oprogramowania i Sympozjum ACM SIGSOFT na temat podstaw inżynierii oprogramowania (ESEC/FSE) . s. 498–510. ar Xiv : 1709.03221 . doi : 10.1145/3106237.3106277 . ISBN 9781450351058 . S2CID 6324652 .

- ^ Kusner, MJ, Loftus, J., Russell, C. i Silva, R. (2017). Sprawiedliwość kontrfaktyczna . Postępy w neuronowych systemach przetwarzania informacji, 30.

- Bibliografia _ Mishler, Alan; Kennedy, Edward H.; Chouldechova, Alexandra (27.01.2020). „Kontrfaktyczne oceny ryzyka, ocena i sprawiedliwość” . Materiały z konferencji 2020 na temat uczciwości, odpowiedzialności i przejrzystości . TŁUSZCZ* '20. Nowy Jork, NY, USA: Association for Computing Machinery: 582–593. doi : 10.1145/3351095.3372851 . ISBN 978-1-4503-6936-7 . S2CID 202539649 .

- Bibliografia _ Kennedy, Edward H.; Chouldechova, Alexandra (2021-03-01). „Uczciwość w instrumentach oceny ryzyka: przetwarzanie końcowe w celu osiągnięcia wyrównanych szans kontrfaktycznych” . Materiały z konferencji ACM 2021 na temat uczciwości, odpowiedzialności i przejrzystości . FAKT '21. Nowy Jork, NY, USA: Association for Computing Machinery: 386–400. doi : 10.1145/3442188.3445902 . ISBN 978-1-4503-8309-7 . S2CID 221516412 .

- Bibliografia _ Yu (Ledell) Wu; Kevina Swerskiego; Toniann Pitassi; Cyntia Dwork, Reprezentacje Targów Nauki . Źródło 1 grudnia 2019 r

- ^ a b c Ziyuan Zhong, Samouczek dotyczący uczciwości w uczeniu maszynowym . Źródło 1 grudnia 2019 r

- ^ Fajsal Kamiran; Toon Calders, Techniki wstępnego przetwarzania danych do klasyfikacji bez dyskryminacji . Źródło 17 grudnia 2019 r

- ^ Muhammad Bilal Zafar; Izabela Walera; Manuela Gómeza Rodrígueza; Krishna P. Gummadi, Sprawiedliwość poza odmiennym traktowaniem i odmiennym wpływem: uczenie się klasyfikacji bez odmiennego złego traktowania . Źródło 1 grudnia 2019 r

- ^ a b Brian Hu Zhang; Blake'a Lemoine'a; Margaret Mitchell, Łagodzenie niepożądanych uprzedzeń za pomocą uczenia się kontradyktoryjnego . Źródło 17 grudnia 2019 r

- ^ Joyce Xu, Algorytmiczne rozwiązania błędu algorytmicznego: przewodnik techniczny . Źródło 17 grudnia 2019 r

- Bibliografia _ _ _ Eric Cena; Nathan Srebro, Równość szans w nauczaniu nadzorowanym . Źródło 1 grudnia 2019 r

- ^ ab ; Fajsal Kamiran Asim Karim; Xiangliang Zhang, Teoria decyzji dla klasyfikacji uwzględniającej dyskryminację . Źródło 17 grudnia 2019 r