Prawo Zipfa

|

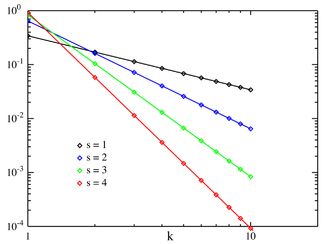

Prawdopodobieństwo funkcji masowej

Zipf PMF dla N = 10 w skali log-log. Oś pozioma to indeks k . (Zauważ, że funkcja jest zdefiniowana tylko dla wartości całkowitych k . Linie łączące nie wskazują ciągłości). | |||

|

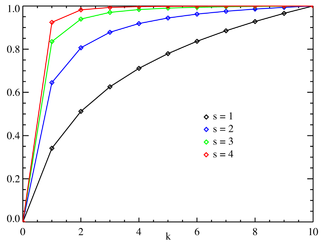

Dystrybuanta

Zipf CDF dla N = 10. Oś pozioma to indeks k . (Zauważ, że funkcja jest zdefiniowana tylko dla wartości całkowitych k . Linie łączące nie wskazują ciągłości). | |||

| Parametry |

( rzeczywisty ) ( liczba całkowita ) |

||

|---|---|---|---|

| Wsparcie | |||

| PMF | gdzie H N, s jest N - tą uogólnioną liczbą harmoniczną | ||

| CDF | |||

| Mieć na myśli | |||

| Tryb | |||

| Zmienność | |||

| Entropia | |||

| MGF | |||

| CF | |||

Prawo Zipfa ( / z ɪ f / , niem. [ts͡ɪpf] ) to prawo empiryczne sformułowane przy użyciu statystyki matematycznej , które odnosi się do faktu, że dla wielu typów danych badanych w naukach fizycznych i społecznych rozkład częstotliwości rang jest odwrotny relacja. Rozkład Zipfiana należy do rodziny pokrewnych rozkładów prawdopodobieństwa opartych na mocy prawa dyskretnego . Jest to związane z rozkład zeta , ale nie jest identyczny.

Prawo Zipfa zostało pierwotnie sformułowane w kategoriach lingwistyki ilościowej , stwierdzając, że przy danym zbiorze wypowiedzi języka naturalnego częstotliwość każdego słowa jest odwrotnie proporcjonalna do jego pozycji w tabeli częstości . Tak więc najczęstsze słowo będzie występowało w przybliżeniu dwa razy częściej niż drugie, trzy razy częściej niż trzecie, itd. Na przykład w tekście Brown Corpus of American English słowo „ the „ jest najczęściej występującym słowem i samo w sobie stanowi prawie 7% wszystkich wystąpień słowa (69 971 z nieco ponad 1 miliona). Zgodnie z prawem Zipfa, drugie miejsce słowa „ z „ stanowi nieco ponad 3,5 % słowa (36 411 wystąpień), a następnie „ i ” (28 852). Tylko 135 elementów słownictwa jest potrzebnych do uwzględnienia połowy Brown Corpus.

Prawo zostało nazwane na cześć amerykańskiego lingwisty George'a Kingsleya Zipfa , który spopularyzował je i starał się je wyjaśnić, chociaż nie twierdził, że jest jego autorem. Wydaje się, że francuski stenograf Jean-Baptiste Estoup zauważył tę prawidłowość przed Zipfem. Odnotował to również w 1913 roku niemiecki fizyk Felix Auerbach .

Prawo jest podobne w koncepcji, choć nie identyczne w dystrybucji, do prawa Benforda .

Inne zestawy danych

Ta sama zależność występuje w wielu innych rankingach systemów stworzonych przez człowieka, takich jak rangi wyrażeń matematycznych lub rangi nut w muzyce, a nawet w niekontrolowanych środowiskach, takich jak wielkość korporacji, rankingi dochodów, rangi liczby osób oglądających tę samą telewizję kanał, transkryptomy komórek i tak dalej. Pojawienie się rozkładu w rankingach miast według ludności po raz pierwszy zauważył Felix Auerbach w 1913 r., co doprowadziło do powstania obszernej literatury prawa Zipfa dla miast. Jednak nowsze badania empiryczne i teoretyczne podważyły znaczenie prawa Zipfa dla miast.

Empirycznie zbiór danych można przetestować, aby sprawdzić, czy prawo Zipfa ma zastosowanie, sprawdzając dopasowanie rozkładu empirycznego do hipotetycznego rozkładu prawa potęgowego za pomocą testu Kołmogorowa – Smirnowa , a następnie porównując (log) iloraz wiarygodności prawa potęgowego dystrybucji do alternatywnych rozkładów, takich jak rozkład wykładniczy lub rozkład logarytmiczno-normalny.

Przegląd teoretyczny

Prawo Zipfa najłatwiej zaobserwować, wykreślając dane na wykresie log-log , gdzie osie są logarytmem rzędu i logarytmem częstotliwości. Na przykład, jak opisano we wstępie, słowo „the” pojawiłoby się przy x = log(1) (pozycja rzędu = 1) i y = log(69 971). Możliwe jest również wykreślenie odwrotności rangi względem częstotliwości lub odwrotności częstotliwości lub interwału międzywyrazowego względem rangi. Dane są zgodne z prawem Zipfa w zakresie, w jakim wykres jest liniowy .

Formalnie zdefiniuj:

- N oznacza liczbę elementów;

- k ich ranga;

- s wartość wykładnika charakteryzującego rozkład ( s co najmniej 1).

Prawo Zipfa przewiduje następnie, że z populacji N elementów element rzędu k ma znormalizowaną częstotliwość f ( k ; s , N ):

Prawo Zipfa obowiązuje, jeśli liczba elementów o danej częstotliwości jest zmienną losową o rozkładzie potęgowym ( f k jest wartością wyrażenia bezpośrednio powyżej).

Twierdzono, że ta reprezentacja prawa Zipfa jest bardziej odpowiednia do testów statystycznych iw ten sposób została przeanalizowana w ponad 30 000 tekstów w języku angielskim. Testy dobroci dopasowania wykazały, że tylko około 15% tekstów jest statystycznie zgodnych z tą postacią prawa Zipfa. Niewielkie różnice w definicji prawa Zipfa mogą zwiększyć ten odsetek do blisko 50%.

Na przykładzie częstości słów w języku angielskim N jest liczbą słów w języku angielskim, a jeśli użyjemy klasycznej wersji prawa Zipfa, wykładnik charakteryzujący s wynosi 1 (minimum możliwe). Wartość f ( k ; s , N ) będzie wtedy ułamkiem czasu, w którym występuje k- te najczęściej spotykane słowo.

Prawo można również zapisać:

gdzie H N,s jest N -tą uogólnioną liczbą harmoniczną .

Najprostszym przypadkiem prawa Zipfa jest funkcja „ 1 / f ”, gdzie s = 1 . Biorąc , pod uwagę zestaw częstotliwości o rozkładzie Zipf, posortowanych od najpowszechniejszych do najrzadziej występujących, druga najczęstsza częstotliwość będzie występować o połowę rzadziej niż pierwsza, trzecia najczęstsza częstotliwość będzie występować 1/3 tak często jak pierwsza a n -ta najczęstsza częstotliwość wystąpi 1 / n tak często jak pierwszy. Jednak nie może to być dokładne: ponieważ elementy muszą wystąpić całkowitą liczbę razy, nie może być 2,5 wystąpień słowa. Niemniej jednak, w dość szerokich zakresach iz dość dobrym przybliżeniem, wiele zjawisk naturalnych jest zgodnych z prawem Zipfa.

W językach ludzkich częstość występowania słów ma rozkład z bardzo dużymi ogonami i dlatego można ją dość dobrze modelować za pomocą rozkładu Zipfa o wartości s bliskiej 1.

Dopóki wykładnik s przekracza 1, takie prawo może obowiązywać przy nieskończenie wielu słowach, ponieważ jeśli s > 1 , to

gdzie ζ jest funkcją zeta Riemanna .

Wyjaśnienie statystyczne

Chociaż prawo Zipfa dotyczy wszystkich języków, nawet tych nienaturalnych, jak esperanto , przyczyna wciąż nie jest dobrze poznana. Można to jednak częściowo wyjaśnić analizą statystyczną losowo generowanych tekstów. Wentian Li wykazał, że w dokumencie, w którym każdy znak został wybrany losowo z jednolitego rozkładu wszystkich liter (plus znak spacji), „słowa” o różnej długości podążają za makrotrendem prawa Zipfa (tym bardziej prawdopodobne, że słowa są najkrótsze z równym prawdopodobieństwem). Vitold Belevitch w artykule pt On the Statistical Laws of Linguistic Distribution oferuje wyprowadzenie matematyczne. Wziął dużą klasę dobrze wychowanych rozkładów statystycznych (nie tylko rozkład normalny ) i wyraził je w postaci rang. Następnie rozwinął każde wyrażenie w szereg Taylora . W każdym przypadku Belevitch uzyskał niezwykły wynik, że skrócenie szeregu pierwszego rzędu dało prawo Zipfa. Co więcej, obcięcie drugiego rzędu szeregu Taylora dało prawo Mandelbrota .

zasada najmniejszego wysiłku : sam Zipf zaproponował, że ani mówcy, ani słuchacze używający danego języka nie chcą pracować ciężej niż to konieczne, aby osiągnąć zrozumienie, a proces, który skutkuje mniej więcej równym rozkładem wysiłku, prowadzi do obserwowanego rozkładu Zipf .

Podobnie wykazano, że preferencyjne przywiązanie (intuicyjnie „bogaci stają się bogatsi” lub „sukces rodzi sukces”), które skutkuje rozkładem Yule-Simon, lepiej pasuje do częstotliwości słów w porównaniu z rangą w języku i populacji w porównaniu z rangą miasta niż prawo Zipfa. Pierwotnie został wyprowadzony w celu wyjaśnienia populacji w zależności od rangi gatunku przez Yule i zastosowany do miast przez Simona.

Wyjaśnienie matematyczne

Modele Atlas to układy wymiennych procesów dyfuzji o wartościach dodatnich, których parametry dryfu i wariancji zależą tylko od rangi procesu. Wykazano matematycznie, że prawo Zipfa obowiązuje dla modeli Atlas, które spełniają określone warunki naturalnej prawidłowości. Modele Atlas mogą być używane do reprezentowania systemów empirycznych zależnych od czasu danych wielowymiarowych, w tym np. częstości występowania słów w języku pisanym lub wielkości firm. Model Atlas, który reprezentuje system empiryczny, będzie miał taki sam rozkład stacjonarny jak system empiryczny, więc jeśli model Atlas jest zgodny z prawem Zipfa, system również będzie przestrzegał prawa Zipfa. Ponieważ modele Atlas, które spełniają warunki naturalnej regularności, są zgodne z prawem Zipfa, wyjaśnia to ich uniwersalność.

Na powyższym rysunku 10 milionów słów z Wikipedii wykresy log-log nie są dokładnie liniami prostymi, ale raczej lekko wklęsłymi krzywymi ze styczną o nachyleniu -1 w pewnym punkcie wzdłuż krzywej. Takie rozkłady są zwykle określane jako quasi-Zipfiańskie , a większość systemów danych empirycznych zależnych od czasu, o których mówi się, że są zgodne z prawem Zipfa, jest w rzeczywistości quasi-Zipfianem. Systemy quasi-Zipfiańskie mogą być reprezentowane przez modele quasi-atlasowe , a modele quasi-atlasowe można traktować matematycznie podobnie jak w przypadku prawa Zipfa.

Powiązane prawa

Prawo Zipfa w rzeczywistości odnosi się bardziej ogólnie do rozkładów częstotliwości „danych rangi”, w których względna częstość n - tej pozycji jest określona przez rozkład zeta , 1/( n s ζ ( s )), gdzie parametr s > 1 indeksuje członków tej rodziny rozkładów prawdopodobieństwa . Rzeczywiście, prawo Zipfa jest czasami synonimem „rozkładu zeta”, ponieważ rozkłady prawdopodobieństwa są czasami nazywane „prawami”. Ta dystrybucja jest czasami nazywana Zipfian .

Uogólnieniem prawa Zipfa jest prawo Zipfa-Mandelbrota , zaproponowane przez Benoit Mandelbrot , którego częstotliwości to:

„Stała” jest odwrotnością funkcji zeta Hurwitza obliczonej przy s . W praktyce, jak łatwo zaobserwować na wykresach rozkładu dla dużych korpusów, obserwowany rozkład można dokładniej modelować jako sumę oddzielnych rozkładów dla różnych podzbiorów lub podtypów słów, które są zgodne z różnymi parametryzacjami rozkładu Zipfa-Mandelbrota, w szczególności klasa zamknięta słów funkcjonalnych wykazuje s mniejsze niż 1, podczas gdy wzrost słownictwa otwartego wraz z rozmiarem dokumentu i rozmiarem korpusu wymaga s większego niż 1 dla zbieżności Uogólniony szereg harmoniczny .

Rozkłady Zipfiana można uzyskać z rozkładów Pareto przez wymianę zmiennych.

Rozkład Zipfa jest czasami nazywany dyskretnym rozkładem Pareto , ponieważ jest analogiczny do ciągłego rozkładu Pareto w taki sam sposób, w jaki dyskretny rozkład jednorodny jest analogiczny do ciągłego rozkładu jednorodnego .

Częstotliwości ogona rozkładu Yule-Simona wynoszą w przybliżeniu

dla dowolnego wyboru ρ > 0.

W parabolicznym rozkładzie fraktalnym logarytm częstotliwości jest kwadratowym wielomianem logarytmu rangi. Może to znacznie poprawić dopasowanie w stosunku do prostej relacji potęgowej. Podobnie jak wymiar fraktalny, możliwe jest obliczenie wymiaru Zipf, który jest parametrem przydatnym w analizie tekstów.

Argumentowano, że prawo Benforda jest szczególnym przypadkiem ograniczonym prawa Zipfa, przy czym związek między tymi dwoma prawami jest wyjaśniony tym, że oba wywodzą się z niezmiennych w skali relacji funkcjonalnych z fizyki statystycznej i zjawisk krytycznych. Stosunki prawdopodobieństw w prawie Benforda nie są stałe. Wiodące cyfry danych spełniających prawo Zipfa z s = 1 spełniają prawo Benforda.

|

Prawo Benforda: |

||

|---|---|---|

| 1 | 0,30103000 | |

| 2 | 0,17609126 | −0,7735840 |

| 3 | 0,12493874 | −0,8463832 |

| 4 | 0,09691001 | −0,8830605 |

| 5 | 0,07918125 | −0,9054412 |

| 6 | 0,06694679 | −0,9205788 |

| 7 | 0,05799195 | −0,9315169 |

| 8 | 0,05115252 | −0,9397966 |

| 9 | 0,04575749 | −0,9462848 |

Aplikacje

W teorii symbol , zawiera _ Zipfa naturalnych jest bitów informacji. Aby dodać informacje symbolu prawdopodobieństwa liczbie naturalnej powinniśmy przejść do , równoważnie . mielibyśmy optymalne rozkład prawdopodobieństwa. Użycie [[asymetrycznego systemu liczbowego] s] rodziny entropijnego w kompresji danych których rozkład stanu to podlega również prawu Zipfa.

Prawo Zipfa zostało wykorzystane do wyodrębnienia równoległych fragmentów tekstów z porównywalnych korpusów. Prawo Zipfa zostało również wykorzystane przez Laurance'a Doyle'a i innych w Instytucie SETI w ramach poszukiwań inteligencji pozaziemskiej .

Manuskrypt Voynicha , który jest XV-wiecznym kodeksem, również jest zgodny z prawem Zipfa, wskazując, że tekst najprawdopodobniej nie jest mistyfikacją, ale raczej napisany niejasnym językiem lub szyfrem.

Zobacz też

- Zasada 1% (kultura internetowa)

- Prawo Benforda

- Prawo Bradforda

- Prawo zwięzłości

- Grawitacja demograficzna

- Lista częstotliwości

- Prawo Gibrata

- Hapax legomenon

- Prawo kupy

- Efekt króla

- Krzywa Lorenza

- Prawo Lotki

- Prawo Menzeratha

- Dystrybucja Pareto

- Zasada Pareto , znana również jako „reguła 80–20”

- Prawo Price'a

- Zasada najmniejszego wysiłku

- Rozkład wielkości rang

- Prawo eponimii Stiglera

- Długi ogon

Dalsza lektura

Podstawowy:

- George K. Zipf (1949) Ludzkie zachowanie i zasada najmniejszego wysiłku . Addison-Wesley. „Tekst online [1] ”

- George K. Zipf (1935) Psychobiologia języka . Houghton-Mifflin.

Wtórny:

- Alexander Gelbukh i Grigori Sidorov (2001) „Współczynniki praw Zipfa i Heapsa zależą od języka” . proc. CICLing -2001, Konferencja na temat inteligentnego przetwarzania tekstu i lingwistyki komputerowej , 18–24 lutego 2001 r., Meksyk. Notatki z wykładów z informatyki N 2004, ISSN 0302-9743 , ISBN 3-540-41687-0 , Springer-Verlag: 332–335.

- Damián H. Zanette (2006) „ Prawo Zipfa a tworzenie kontekstu muzycznego ”, Musicae Scientiae 10 : 3–18.

- Frans J. Van Droogenbroeck (2016), Obsługa dystrybucji Zipf w skomputeryzowanym przypisywaniu autorstwa

- Frans J. Van Droogenbroeck (2019), Niezbędne przeformułowanie prawa Zipfa-Mandelbrota w celu rozwiązania aplikacji przypisania autorstwa za pomocą statystyk Gaussa

- Kali R. (2003) „Miasto jako gigantyczny składnik: podejście losowego wykresu do prawa Zipfa”, Applied Economics Letters 10 : 717–720 (4)

- Gabaix, Xavier (sierpień 1999). „Prawo Zipfa dla miast: wyjaśnienie” (PDF) . Kwartalnik Ekonomii . 114 (3): 739–67. CiteSeerX 10.1.1.180.4097 . doi : 10.1162/003355399556133 . ISSN 0033-5533 . Zarchiwizowane (PDF) od oryginału w dniu 21.12.2008.

- Axtell, Robert L.; Dystrybucja Zipf rozmiarów firm w USA , Science, 293, 5536, 1818, 2001, American Association for the Advancement of Science

- Ramu Chenna, Toby'ego Gibsona; Ocena przydatności modelu luki Zipfiana do dopasowania sekwencji par , Międzynarodowa konferencja na temat biologii obliczeniowej bioinformatyki: 2011.

- Szykło A. (2017); Proste wyjaśnienie tajemnicy Zipfa poprzez nową dystrybucję udziału w rankingu, wywodzącą się z kombinatoryki procesu rankingowego , dostępne na SSRN: https://ssrn.com/abstract=2918642 .

Linki zewnętrzne

|

Zasoby biblioteczne dotyczące prawa Zipfa |

- Strogatz, Steven (2009-05-29). „Kolumna gościnna: matematyka i miasto” . New York Timesa . Zarchiwizowane od oryginału w dniu 2015-09-27 . Źródło 2009-05-29 . — Artykuł o prawie Zipfa zastosowanym do populacji miast

- Widząc za rogiem (Sztuczne społeczeństwa ujawniają prawo Zipfa)

- Artykuł PlanetMath na temat prawa Zipfa

- Dystrybucje typu „fractal parabolique” dans la Nature (francuski, ze streszczeniem w języku angielskim) Zarchiwizowane 2004-10-24 w Wayback Machine

- Analiza dystrybucji dochodów

- Zipf Lista francuskich słów zarchiwizowana 2007-06-23 w Wayback Machine

- Lista Zipf dla języka angielskiego, francuskiego, hiszpańskiego, włoskiego, szwedzkiego, islandzkiego, łaciny, portugalskiego i fińskiego z Gutenberg Project i kalkulator online do uszeregowania słów w tekstach Zarchiwizowane 2011-04-08 w Wayback Machine

- Cytaty i prawo Zipfa-Mandelbrota

- Przykłady i modelowanie prawa Zipfa (1985)

- Systemy złożone: prawo rozpakowywania Zipfa (2011)

- Prawo Benforda, prawo Zipfa i rozkład Pareto autorstwa Terence'a Tao.

- „Prawo Zipf” , Encyklopedia matematyki , EMS Press , 2001 [1994]

![{\displaystyle \ f(k;s,N)~=~{\frac {\left[{\frac {1}{\ k^{s}\ }}\right]}{\ \left[\ \sum \limits _{n=1}^{N}{\frac {1}{\ n^{s}\ }}\ \right]\ \ }}~\equiv ~f_{k}\ .}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e37d1b337f543409b7a0a0cab6606d2e44e0f342)

![{\displaystyle f(k;N,q,s)={\frac {[{\text{constant}}]}{(k+q)^{s}}}.\,}](https://wikimedia.org/api/rest_v1/media/math/render/svg/fa491882940976898252010592e6c19ce6092ba9)

![{\displaystyle f(k;\rho )\approx {\frac {[{\text{constant}}]}{k^{\rho +1}}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/78fb2a5a8523f03c5e11716e40fd9627c18ff49f)