Rozkład dwumianowy

|

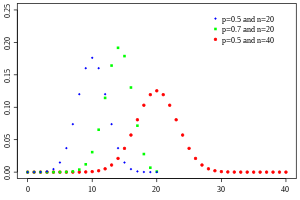

Funkcja masy prawdopodobieństwa

| |||

|

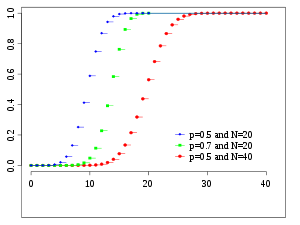

Funkcja dystrybucji skumulowanej

| |||

| Notacja | |||

|---|---|---|---|

| Parametry |

- liczba prób - prawdopodobieństwo sukcesu dla każdej próby |

||

| Wsparcie | - liczba sukcesów | ||

| PMF | |||

| CDF | ( uregulowana niekompletna funkcja beta ) | ||

| Mieć na myśli | |||

| Mediana | lub | ||

| Tryb | lub | ||

| Zmienność | |||

| Skośność | |||

| Były. kurtoza | |||

| Entropia |

w shannons . W przypadku nat użyj dziennika naturalnego w dzienniku. |

||

| MGF | |||

| CF | |||

| PGF | |||

| Informacje Fishera |

(dla ustalonego ) |

||

| Część serii poświęconej statystyce |

| Teoria prawdopodobieństwa |

|---|

|

W teorii prawdopodobieństwa i statystyce rozkład dwumianowy z parametrami n i p jest dyskretnym rozkładem prawdopodobieństwa liczby sukcesów w sekwencji n niezależnych eksperymentów , z których każdy zadaje pytanie tak-nie i każdy ma własny wynik o wartości logicznej : sukces (z prawdopodobieństwem p ) lub porażka (z prawdopodobieństwem ). Pojedynczy sukces / porażka jest również nazywany próbą Bernoulliego lub eksperymentem Bernoulliego, a sekwencja wyników nazywana jest procesem Bernoulliego ; dla pojedynczej próby, tj. n = 1, rozkład dwumianowy jest rozkładem Bernoulliego . Rozkład dwumianowy jest podstawą popularnego dwumianowego testu istotności statystycznej .

Rozkład dwumianowy jest często używany do modelowania liczby sukcesów w próbie o rozmiarze n , wylosowanej ze zwracaniem z populacji o rozmiarze N. Jeśli losowanie odbywa się bez zwracania, losowania nie są niezależne, a zatem otrzymany rozkład jest rozkładem hipergeometrycznym , a nie dwumianowym. Jednak dla N znacznie większych niż n rozkład dwumianowy pozostaje dobrym przybliżeniem i jest szeroko stosowany.

Definicje

Prawdopodobieństwo funkcji masowej

Ogólnie, jeśli zmienna losowa X ma rozkład dwumianowy z parametrami i p ∈ [ ], piszemy X ~ B ( n , p . Prawdopodobieństwo uzyskania dokładnie k sukcesów w n niezależnych próbach Bernoulliego wyraża funkcja masy prawdopodobieństwa :

dla k = 0, 1, 2, ..., n , gdzie

jest współczynnikiem dwumianowym , stąd nazwa rozkładu. Formułę można rozumieć następująco: k sukcesów występuje z prawdopodobieństwem p k i n - k niepowodzeń występuje z prawdopodobieństwem . Jednak k sukcesów może wystąpić w dowolnym miejscu spośród i różne sposoby dystrybucji k w sekwencji n .

Tworząc tabele referencyjne dla prawdopodobieństwa rozkładu dwumianowego, zwykle tabelę wypełnia się do wartości n /2. Dzieje się tak, ponieważ dla k > n /2 prawdopodobieństwo można obliczyć za pomocą jego uzupełnienia jako

Patrząc na wyrażenie f ( k , n , p ) jako funkcję k , istnieje wartość k , która je maksymalizuje. Tę k można znaleźć za pomocą obliczeń

i porównując to z 1. Zawsze istnieje liczba całkowita M , która spełnia

f ( k , n , p ) jest monotonicznie rosnący dla k < M i monotonicznie malejący dla k > M , z wyjątkiem przypadku, gdy ( n + 1) p jest liczbą całkowitą. W tym przypadku istnieją dwie wartości, dla których f jest maksymalne: ( n + 1) p i ( n + 1) p - 1. M jest najbardziej prawdopodobnym wynikiem (czyli najbardziej prawdopodobnym, chociaż nadal może być mało prawdopodobny ogólnie) prób Bernoulliego i nazywa się trybem .

Przykład

Załóżmy, że w rzucie monetą z odchyleniem wypadnie orzeł z prawdopodobieństwem 0,3. Prawdopodobieństwo trafienia dokładnie 4 orłów w 6 rzutach wynosi

Dystrybuanta

Skumulowaną funkcję dystrybucji można wyrazić jako:

gdzie jest „piętrem” pod k , tj. największą liczbą całkowitą mniejszą lub równą k .

Można to również przedstawić za pomocą uregulowanej niepełnej funkcji beta w następujący sposób:

F jest równoważne skumulowanej funkcji dystrybucji rozkładu :

Poniżej podano niektóre granice postaci zamkniętej dla funkcji dystrybucji skumulowanej .

Nieruchomości

Oczekiwana wartość i wariancja

Jeśli X ~ B ( n , p ), czyli X jest zmienną losową o rozkładzie dwumianowym, gdzie n oznacza całkowitą liczbę eksperymentów, a p prawdopodobieństwo, że każdy eksperyment zakończy się sukcesem, to oczekiwana wartość X wynosi :

Wynika to z liniowości wartości oczekiwanej oraz z faktu, że X jest sumą n identycznych zmiennych losowych Bernoulliego, z których każda ma wartość oczekiwaną p . Innymi słowy, jeśli Bernoulliego z parametrem p , to i

Wariancja to :

Podobnie wynika to z faktu, że wariancja sumy niezależnych zmiennych losowych jest sumą wariancji.

Wyższe chwile

Pierwsze 6 centralnych momentów , zdefiniowanych jako , są podane przez

Niecentralne momenty satysfakcjonują

i na ogół

gdzie to liczby Stirlinga drugiego rodzaju i ) spadająca potęga k . Prosta granica następuje przez ograniczenie momentów dwumianowych przez wyższe momenty Poissona :

, że jeśli mi Displaystyle jest co najwyżej stałym czynnikiem oddalonym od

Tryb

Zwykle tryb rozkładu dwumianowego B ( n , p ) jest równy , gdzie ⌊ to funkcja podłogi . Jednak gdy ( n + 1) p jest liczbą całkowitą, a p nie jest ani 0, ani 1, wówczas rozkład ma dwa tryby: ( n + 1) p i ( n + 1) p - 1. Kiedy p jest równe 0 lub 1, tryb będzie odpowiednio 0 i n . Przypadki te można podsumować w następujący sposób:

Dowód: Niech

p tylko ma wartość różną od zera z . p znajdujemy i dla . Dowodzi to że tryb wynosi 0 dla i dla .

Niech . Znaleźliśmy

- .

Z tego wynika

Więc kiedy jest liczbą całkowitą, to i jest trybem. W przypadku, gdy , to tylko jest trybem.

Mediana

Ogólnie rzecz biorąc, nie ma jednego wzoru na znalezienie mediany dla rozkładu dwumianowego, a nawet może on nie być unikalny. Ustalono jednak kilka wyników specjalnych:

- Jeśli np jest liczbą całkowitą, to średnia, mediana i tryb pokrywają się i są równe np .

- Każda mediana m musi leżeć w przedziale ⌊ np ⌋ ≤ m ≤ ⌈ np ⌉.

- Mediana m nie może leżeć zbyt daleko od średniej: | m − np | ≤ min{ ln 2, max{ p , 1 - p } }.

- Mediana jest unikalna i równa m = round ( np ), gdy | m − np | ≤ min{ p , 1 − p } (z wyjątkiem przypadku, gdy p = 1 / 2 i n jest nieparzyste).

- Kiedy p jest liczbą wymierną (z wyjątkiem p = 1/2 i n nieparzystych), mediana jest niepowtarzalna.

- Gdy p = 1/2 i n 1/2 jest jest 1/2 nieparzyste , dowolna liczba m z przedziału ( n - 1) ≤ m ≤ ( n + 1) medianą rozkładu dwumianowego. Jeśli p = 1/2 i n jest parzyste, to m = n /2 jest jednoznaczną medianą.

Granice ogona

Dla k ≤ np , górne granice można wyprowadzić dla dolnego ogona skumulowanej funkcji dystrybucji , prawdopodobieństwo, że jest co najwyżej k sukcesów. Pr te granice można również zobaczyć jako granice górnego ogona funkcji dystrybucji skumulowanej dla k ≥ np .

Nierówność Hoeffdinga daje prostą granicę

co jednak nie jest zbyt ciasne. W szczególności dla p = 1 mamy to, że F ( k ; n , p ) = 0 (dla ustalonego k , n z k < n ), ale granica Hoeffdinga daje dodatnią stałą.

Ostrzejszą granicę można uzyskać z granicy Chernoffa :

gdzie D ( a || p ) jest względną entropią (lub dywergencją Kullbacka-Leiblera) między monetą a a monetą p (tj. między rozkładem Bernoulliego ( a ) i Bernoulliego ( p )):

Asymptotycznie ta granica jest dość wąska; zobacz szczegóły.

Można również granice , koncentracji Można to wykazać, przybliżając współczynnik dwumianu wzorem Stirlinga

co implikuje prostszą, ale luźniejszą granicę

Dla p = 1/2 i k ≥ 3 n /8 dla parzystego n można uczynić mianownik stałym:

Wnioskowanie statystyczne

Szacowanie parametrów

Gdy znane jest n , parametr p można oszacować na podstawie proporcji sukcesów:

Ten estymator znajduje się za pomocą estymatora największej wiarygodności , a także metody momentów . Ten estymator jest nieobciążony i jednorodny z minimalną wariancją , udowodniony za pomocą twierdzenia Lehmanna-Scheffégo , ponieważ jest oparty na minimalnej statystyce wystarczającej i pełnej (tj.: x ). Jest również spójny zarówno pod względem prawdopodobieństwa, jak i MSE .

Estymator Bayesa w postaci zamkniętej dla p istnieje również w przypadku używania rozkładu Beta jako sprzężonego rozkładu a priori . Używając jako priori późniejszej

Estymator Bayesa jest asymptotycznie wydajny i gdy wielkość próby zbliża się do nieskończoności ( n → ∞), zbliża się do rozwiązania MLE . Estymator Bayesa jest obciążony (ile zależy od a priori), dopuszczalny i spójny w prawdopodobieństwie.

W szczególnym przypadku użycia standardowego rozkładu jednorodnego jako nieinformacyjnego wcześniejszego , , estymator średniej późniejszej przyjmuje postać:

( Tryb późniejszy powinien po prostu prowadzić do estymatora standardowego). Ta metoda nazywa się regułą sukcesji , którą wprowadził w XVIII wieku Pierre-Simon Laplace .

Podczas szacowania p z bardzo rzadkimi zdarzeniami i małym n (np. Jeśli x = 0), użycie standardowego estymatora prowadzi do co czasami jest nierealne i niepożądany. W takich przypadkach istnieją różne alternatywne estymatory. Jednym ze sposobów jest użycie estymatora Bayesa, co prowadzi do:

Inną metodą jest wykorzystanie górnej granicy przedziału ufności uzyskanego za pomocą reguły trzech :

Przedziały ufności

Nawet dla dość dużych wartości n rzeczywisty rozkład średniej jest znacząco nienormalny. Z powodu tego problemu zaproponowano kilka metod szacowania przedziałów ufności.

W poniższych równaniach dla przedziałów ufności zmienne mają następujące znaczenie:

- n 1 to liczba sukcesów z n , całkowita liczba prób

- to odsetek sukcesów

- jest kwantylem standardowego rozkładu normalnego (tj. probit ) odpowiadającego docelowemu poziomowi błędów . Na przykład dla 95% poziomu ufności błąd = 0,05, więc = 0,975 i = 1,96.

Metoda Walda

Można dodać poprawkę ciągłości 0,5/ n . [ wymagane wyjaśnienie ]

Metoda Agrestiego-Coull'a

Tutaj oszacowanie p jest modyfikowane do

Ta metoda działa dobrze dla i . Zobacz tutaj . Dla użyj poniższej metody Wilsona (wynik).

Metoda arcsine

Metoda Wilsona (punktacja).

Oznaczenie w poniższym wzorze różni się od poprzednich wzorów pod dwoma względami:

- Po pierwsze, z x ma nieco inną interpretację w poniższym wzorze: ma swoje zwykłe znaczenie „ x -tego kwantyla standardowego rozkładu normalnego”, a nie jest skrótem dla „(1 − x )-tego kwantyla”.

- Po drugie, ta formuła nie używa plus-minus do zdefiniowania dwóch granic. Zamiast tego można użyć, granicę, lub użyć , aby uzyskać górną granicę. Na przykład: dla poziomu ufności % błąd = , więc dolną granicę uzyskuje się za pomocą , a górną granicę uzyskuje się za pomocą .

Porównanie

Tak zwana metoda „dokładna” ( Clopper – Pearsona ) jest najbardziej konserwatywna. ( Dokładne nie oznacza idealnie dokładne; wskazuje raczej, że oszacowania nie będą mniej konserwatywne niż wartość prawdziwa).

Metoda Walda, choć powszechnie zalecana w podręcznikach, jest najbardziej stronnicza. [ wymagane wyjaśnienie ]

Powiązane dystrybucje

Sumy dwumianów

Jeśli X ~ B( n , p ) i Y ~ B( m , p ) są niezależnymi zmiennymi dwumianowymi z tym samym prawdopodobieństwem p , to X + Y jest znowu zmienną dwumianową; jego rozkład to Z=X+Y ~ B( n+m , p ):

Zmienna losowa o rozkładzie dwumianowym X ~ B( n , p ) może być traktowana jako suma n zmiennych losowych o rozkładzie Bernoulliego. Zatem suma dwóch zmiennych losowych o rozkładzie dwumianowym X ~ B( n , p ) i Y ~ B( m , p ) jest równoważna sumie n + m zmiennych losowych o rozkładzie Bernoulliego, co oznacza Z=X+Y ~ B( n+m , p ). Można to również udowodnić bezpośrednio za pomocą reguły dodawania.

Jeśli jednak X i Y nie mają tego samego prawdopodobieństwa p , to wariancja sumy będzie mniejsza niż wariancja zmiennej dwumianowej o rozkładzie

Rozkład dwumianowy Poissona

Rozkład dwumianowy jest szczególnym przypadkiem rozkładu dwumianowego Poissona , który jest rozkładem sumy n niezależnych nieidentycznych prób Bernoulliego B( pi ) .

Stosunek dwóch rozkładów dwumianowych

Wynik ten został po raz pierwszy uzyskany przez Katza i współautorów w 1978 roku.

Niech X ~ B( n , p 1 ) i Y ~ B( m , p 2 ) będą niezależne. Niech T = ( X / n )/( Y / m ).

Wówczas log( T ) ma w przybliżeniu rozkład normalny ze średnią log( p 1 / p 2 ) i wariancją ((1/ p 1 ) − 1)/ n + ((1/ p 2 ) − 1)/ m .

Dwumiany warunkowe

Jeśli X ~ B( n , p ) i Y | X ~ B( X , q ) (rozkład warunkowy Y , dany X ), wtedy Y jest prostą dwumianową zmienną losową o rozkładzie Y ~ B( n , pq ).

Na przykład wyobraź sobie, że rzucasz n piłek do kosza U X i zabierasz piłki, które trafiły, i rzucasz je do innego kosza U Y . Jeśli p to prawdopodobieństwo trafienia U X , to X ~ B( n , p ) to liczba piłek, które trafią U X . Jeśli q jest prawdopodobieństwem trafienia U Y , to liczba piłek, które trafiły U Y , wynosi Y ~ B( X , q ), a zatem Y ~ B ( n , pq ).

Ponieważ i , zgodnie z prawem całkowitego prawdopodobieństwo ,

ponieważ powyższe równanie można zapisać jako

i wyciąganie wszystkich terminów, które nie zależą od k z suma teraz daje

Po podstawieniu w powyższym wyrażeniu otrzymujemy

Zauważ, że suma (w nawiasach) powyżej jest równa przez twierdzenie dwumianowe . Zastąpienie tego w końcu daje

a zatem zgodnie z życzeniem.

Rozkład Bernoulliego

Rozkład Bernoulliego jest szczególnym przypadkiem rozkładu dwumianowego, gdzie n = 1. Symbolicznie X ~ B(1, p ) ma takie samo znaczenie jak X ~ Bernoulli( p ). I odwrotnie, każdy rozkład dwumianowy B( n , p ) jest rozkładem sumy n niezależnych prób Bernoulliego , Bernoulliego( p ), z których każda ma to samo prawdopodobieństwo p .

Normalne przybliżenie

Jeśli n jest wystarczająco duże, to skośność rozkładu nie jest zbyt duża. W tym przypadku rozsądne przybliżenie B( n , p ) daje rozkład normalny

a to podstawowe przybliżenie można w prosty sposób poprawić, stosując odpowiednią poprawkę na ciągłość . Podstawowe przybliżenie ogólnie poprawia się wraz ze n (co najmniej 20) i jest lepsze, gdy p nie jest bliskie 0 lub 1. Można zastosować różne praktyczne zasady , aby zdecydować, czy n jest wystarczająco duże, a p jest wystarczająco daleko od skrajności zero lub jeden:

- Jedna zasada mówi, że dla n > 5 normalne przybliżenie jest odpowiednie, jeśli bezwzględna wartość skośności jest ściśle mniejsza niż 0,3; to znaczy, jeśli

Można to sprecyzować za pomocą twierdzenia Berry'ego – Esseena .

- Silniejsza reguła mówi, że przybliżenie normalne jest właściwe tylko wtedy, gdy wszystko w zakresie 3 odchyleń standardowych od jego średniej mieści się w zakresie możliwych wartości; to znaczy tylko wtedy, gdy

- : co implikuje również pierwszą regułę powyżej.

n całkowicie równoważne żądaniu To

Przesuwanie terminów wokół plonów:

Ponieważ możemy zastosować potęgę do kwadratu i podzielić przez odpowiednie czynniki ( , aby otrzymać żądane warunki:

Zauważ, że te warunki automatycznie implikują, że . Z drugiej strony zastosuj ponownie pierwiastek kwadratowy i podziel przez 3,

Odejmując drugi zbiór nierówności od pierwszego otrzymujemy:

a więc pożądana pierwsza reguła jest spełniona,

- Inną powszechnie stosowaną zasadą jest to, że obie wartości i muszą być większe lub równe 5. Jednak konkretna liczba różni się w zależności źródła i zależy od tego, jak dobrego przybliżenia ktoś chce. W szczególności, jeśli użyje się 9 zamiast 5, reguła implikuje wyniki podane w poprzednich akapitach.

że obie wartości i większe niż 9. łatwo mieć to

Musimy teraz tylko podzielić przez odpowiednie czynniki , aby alternatywną postać reguły 3 odchyleń standardowych:

Poniżej przedstawiono przykład zastosowania korekty ciągłości . Załóżmy, że ktoś chce obliczyć Pr( X ≤ 8) dla dwumianowej zmiennej losowej X . Jeśli Y ma rozkład określony przez przybliżenie normalne, to Pr( X ≤ 8) jest przybliżone przez Pr ( Y ≤ 8,5). Dodanie 0,5 to poprawka na ciągłość; nieskorygowane przybliżenie normalne daje znacznie mniej dokładne wyniki.

To przybliżenie, znane jako twierdzenie de Moivre'a-Laplace'a , pozwala zaoszczędzić czas przy ręcznym wykonywaniu obliczeń (dokładne obliczenia z dużymi n są bardzo uciążliwe); historycznie było to pierwsze użycie rozkładu normalnego, wprowadzone w książce Abrahama de Moivre The Doctrine of Chances w 1738 r. Obecnie można to postrzegać jako konsekwencję centralnego twierdzenia granicznego , ponieważ B( n , p ) jest suma n niezależnych zmiennych Bernoulliego o identycznym rozkładzie z parametrem p . Fakt ten jest podstawą testu hipotezy , „testu proporcjonalnego z”, dla wartości p przy użyciu x/n , proporcji próby i estymatora p , we wspólnej statystyce testowej .

Załóżmy na przykład, że losujemy n osób z dużej populacji i pytamy ich, czy zgadzają się z pewnym stwierdzeniem. Odsetek osób, które się zgodzą, będzie oczywiście zależał od próby. Gdyby grupy n osób były pobierane wielokrotnie i naprawdę losowo, proporcje odpowiadałyby przybliżonemu rozkładowi normalnemu ze średnią równą rzeczywistej proporcji p zgodności w populacji i odchyleniem standardowym

Przybliżenie Poissona

Rozkład dwumianowy zbiega się w kierunku rozkładu Poissona , gdy liczba prób dąży do nieskończoności, podczas gdy iloczyn np zbiega się do skończonej granicy. Dlatego rozkład Poissona z parametrem λ = np może być użyty jako przybliżenie B( n , p ) rozkładu dwumianowego, jeśli n jest wystarczająco duże, a p jest wystarczająco małe. Zgodnie z dwiema praktycznymi regułami przybliżenie to jest dobre, jeśli n ≥ 20 i p ≤ 0,05 lub jeśli n ≥ 100 i np ≤ 10.

Na temat dokładności przybliżenia Poissona zob. Novak, rozdz. 4 i odniesienia w nim zawarte.

Dystrybucje ograniczające

- Twierdzenie o granicy Poissona : Gdy n zbliża się do ∞, a p dąży do 0 przy ustalonym produkcie np , rozkład dwumianowy ( n , p ) zbliża się do rozkładu Poissona z wartością oczekiwaną λ = np .

- Twierdzenie de Moivre'a – Laplace'a : Gdy n zbliża się do ∞, podczas gdy p pozostaje stałe, rozkład

- zbliża się do rozkładu normalnego z wartością oczekiwaną 0 i wariancją 1. Ten wynik jest czasami luźno powiedziane, mówiąc, że rozkład X jest asymptotycznie normalny z wartością oczekiwaną 0 i wariancją 1. Wynik ten jest szczególnym przypadkiem centralnego twierdzenia granicznego .

Dystrybucja beta

Rozkład dwumianowy i rozkład beta to różne widoki tego samego modelu powtarzanych prób Bernoulliego. Rozkład dwumianowy to PMF k sukcesów przy n niezależnych zdarzeniach, z których każde ma prawdopodobieństwo p sukcesu. Matematycznie, gdy α = k + 1 i β = n - k + 1 , rozkład beta i rozkład dwumianowy są powiązane współczynnikiem n + 1 :

Rozkłady beta zapewniają również rodzinę wcześniejszych rozkładów prawdopodobieństwa dla rozkładów dwumianowych we wnioskowaniu bayesowskim :

Biorąc pod uwagę jednolity a priori, rozkład późniejszy prawdopodobieństwa sukcesu p przy n niezależnych zdarzeniach z k obserwowanymi sukcesami jest rozkładem beta.

Generowanie liczb losowych

0 Metody generowania liczb losowych , w których rozkład krańcowy jest rozkładem dwumianowym, są dobrze ugruntowane. Jednym ze sposobów generowania losowych próbek zmiennych z rozkładu dwumianowego jest użycie algorytmu inwersji. Aby to zrobić, należy obliczyć prawdopodobieństwo, że Pr( X = k ) dla wszystkich wartości k od do n . (Prawdopodobieństwa te powinny sumować się do wartości bliskiej jedności, aby objąć całą przestrzeń próbki). Następnie, używając generatora liczb pseudolosowych do generowania próbek równomiernie między 0 a 1, można przekształcić obliczone próbki w liczby dyskretne za pomocą prawdopodobieństwa obliczone w pierwszym kroku.

Historia

Ten rozkład został wyprowadzony przez Jacoba Bernoulliego . Rozważył przypadek, w którym p = r /( r + s ), gdzie p jest prawdopodobieństwem sukcesu, a r i s są dodatnimi liczbami całkowitymi. Blaise Pascal rozważał wcześniej przypadek, w którym p = 1/2.

Zobacz też

- Regresja logistyczna

- Rozkład wielomianowy

- Ujemny rozkład dwumianowy

- Rozkład beta-dwumianowy

- Miara dwumianowa, przykład miary multifraktalnej .

- Mechanika statystyczna

- Lemat o stosach , wynikowe prawdopodobieństwo, gdy XOR -uje niezależne zmienne boolowskie

Dalsza lektura

- Hirsch, Werner Z. (1957). „Rozkład dwumianowy - sukces lub porażka, jakie jest prawdopodobieństwo?” . Wprowadzenie do współczesnej statystyki . Nowy Jork: MacMillan. s. 140–153.

- Neter, Jan; Wasserman, William; Whitmore, GA (1988). Statystyka stosowana (wyd. Trzecie). Boston: Allyn & Bacon. s. 185–192. ISBN 0-205-10328-6 .

Linki zewnętrzne

- Grafika interaktywna: Relacje dystrybucji jednowymiarowej

- Kalkulator formuły rozkładu dwumianowego

- Różnica dwóch zmiennych dwumianowych: XY lub |XY|

- Zapytanie o dwumianowy rozkład prawdopodobieństwa w WolframAlpha

![{\displaystyle p\in [0,1]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/33c3a52aa7b2d00227e85c641cca67e85583c43c)

![{\displaystyle G(z)=[q+pz]^{n}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/40494c697ce2f88ebb396ac0191946285cadcbdd)

![{\displaystyle \operatorname {E} [X]=np.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/3f16b365410a1b23b5592c53d3ae6354f1a79aff)

![{\displaystyle \operatorname {E} [X]=\operatorname {E} [X_{1}+\cdots +X_{n}]=\operatorname {E} [X_{1}]+\cdots +\operatorname {E} [X_{n}]=p+\cdots +p=np.}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5f238d520c68a1d1b9b318492ddda39f4cc45bb8)

![{\displaystyle \mu _{c}=\operatorname {E} \left[(X-\operatorname {E} [X])^{c}\right]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/1c5ea3e05b674668550675c3c4593c725a1ec86b)

![{\displaystyle {\begin{aligned}\operatorname {E} [X]&=np,\\\operatorname {E} [X^{2}]&=np(1-p)+n^{2}p^{2},\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/b3f2b3a9af52fc1ea633476400290069fc3ae7b4)

![{\displaystyle \operatorname {E} [X^{c}]=\sum _{k=0}^{c}\left\{{c \atop k}\right\}n^{\underline {k}}p^{k},}](https://wikimedia.org/api/rest_v1/media/math/render/svg/db435ced7af59fa481fe26a023a1429d18a6a83a)

![{\displaystyle \operatorname {E} [X^{c}]\leq \left({\frac {c}{\log(c/(np)+1)}}\right)^{c}\leq (np)^{c}\exp \left({\frac {c^{2}}{2np}}\right).}](https://wikimedia.org/api/rest_v1/media/math/render/svg/e6b86926254189719acfa57fcc1650caf698c292)

![{\displaystyle \operatorname {E} [X^{c}]}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5989f9c9f5202059ad1c0a4026d267ee2a975761)

![{\displaystyle \operatorname {E} [X]^{c}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/74d46bd564a6f77db38e12b156443bdbc3262cfb)

![{\begin{aligned}\operatorname {P} (Z=k)&=\sum _{i=0}^{k}\left[{\binom {n}{i}}p^{i}(1-p)^{n-i}\right]\left[{\binom {m}{k-i}}p^{k-i}(1-p)^{m-k+i}\right]\\&={\binom {n+m}{k}}p^{k}(1-p)^{n+m-k}\end{aligned}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/38fc38e9a5e2c49743f45b4dab5dae6230ab2ad5)

![{\displaystyle {\begin{aligned}\Pr[Y=m]&=\sum _{k=m}^{n}\Pr[Y=m\mid X=k]\Pr[X=k]\\[2pt]&=\sum _{k=m}^{n}{\binom {n}{k}}{\binom {k}{m}}p^{k}q^{m}(1-p)^{n-k}(1-q)^{k-m}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/7e8f896e04f3bc2c13d2eed61e48bd43e63f6406)

![{\displaystyle \Pr[Y=m]=\sum _{k=m}^{n}{\binom {n}{m}}{\binom {n-m}{k-m}}p^{k}q^{m}(1-p)^{n-k}(1-q)^{k-m}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/8369ef846ffda72900efc67b334923f70ce48ca5)

![{\displaystyle {\begin{aligned}\Pr[Y=m]&={\binom {n}{m}}p^{m}q^{m}\left(\sum _{k=m}^{n}{\binom {n-m}{k-m}}p^{k-m}(1-p)^{n-k}(1-q)^{k-m}\right)\\[2pt]&={\binom {n}{m}}(pq)^{m}\left(\sum _{k=m}^{n}{\binom {n-m}{k-m}}\left(p(1-q)\right)^{k-m}(1-p)^{n-k}\right)\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/caaa36dbcb3b4c43d7d5310533ef9d4809ba9db8)

![{\displaystyle \Pr[Y=m]={\binom {n}{m}}(pq)^{m}\left(\sum _{i=0}^{n-m}{\binom {n-m}{i}}(p-pq)^{i}(1-p)^{n-m-i}\right)}](https://wikimedia.org/api/rest_v1/media/math/render/svg/54401b2dd0936ca0904832912df2fe9b2c3d5153)

![{\displaystyle {\begin{aligned}\Pr[Y=m]&={\binom {n}{m}}(pq)^{m}(p-pq+1-p)^{n-m}\\[4pt]&={\binom {n}{m}}(pq)^{m}(1-pq)^{n-m}\end{aligned}}}](https://wikimedia.org/api/rest_v1/media/math/render/svg/324b106ed5f362da979eebfc0feaa94b44b713b2)