Globalne ryzyko katastroficzne

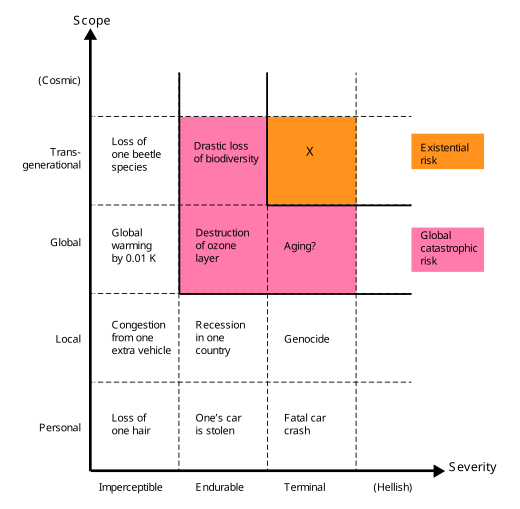

Globalne ryzyko katastrofy lub scenariusz zagłady to hipotetyczne przyszłe wydarzenie, które może zaszkodzić dobrobytowi ludzkości w skali globalnej, a nawet zagrozić lub zniszczyć współczesną cywilizację . Zdarzenie, które może spowodować wyginięcie ludzkości lub trwale i drastycznie ograniczyć potencjał ludzkości, jest znane jako „ ryzyko egzystencjalne ”.

W ciągu ostatnich dwóch dekad powstało wiele organizacji akademickich i organizacji non-profit, które badają globalne zagrożenia katastroficzne i egzystencjalne, formułują potencjalne środki łagodzące oraz opowiadają się za tymi środkami lub je wdrażają.

Definicja i klasyfikacja

Definiowanie globalnych zagrożeń katastroficznych

Termin globalne ryzyko katastroficzne „brakuje ostrej definicji” i ogólnie odnosi się (luźno) do ryzyka, które może spowodować „poważne szkody dla dobrobytu ludzi w skali globalnej”.

Ludzkość już wcześniej doświadczyła wielkich katastrof. Niektóre z nich spowodowały poważne szkody, ale miały jedynie zasięg lokalny — np. czarna śmierć mogła spowodować śmierć jednej trzeciej populacji Europy, czyli 10% ówczesnej populacji świata. Niektóre miały zasięg globalny, ale nie były tak poważne — np. pandemia grypy z 1918 r. zabiła szacunkowo 3–6% światowej populacji. Większość globalnych zagrożeń katastroficznych nie byłaby tak intensywna, aby zabić większość życia na Ziemi, ale nawet gdyby tak się stało, ekosystem i ludzkość ostatecznie odrodziłyby się (w przeciwieństwie do zagrożeń egzystencjalnych ).

Podobnie w Catastrophe: Risk and Response Richard Posner wyróżnia i grupuje wydarzenia, które przynoszą „całkowite obalenie lub ruinę” w skali globalnej, a nie „lokalnej lub regionalnej” . Posner podkreśla, że takie wydarzenia zasługują na szczególną uwagę ze względu na koszty i korzyści, ponieważ mogą bezpośrednio lub pośrednio zagrozić przetrwaniu rasy ludzkiej jako całości.

Definiowanie zagrożeń egzystencjalnych

Ryzyko egzystencjalne definiuje się jako „ryzyko grożące zniszczeniem długoterminowego potencjału ludzkości”. Urzeczywistnienie egzystencjalnego ryzyka ( egzystencjalna katastrofa ) spowodowałoby albo całkowite wyginięcie ludzkości, albo nieodwracalne zablokowanie drastycznie gorszego stanu rzeczy. Ryzyka egzystencjalne to podklasa globalnych zagrożeń katastroficznych, w przypadku których szkoda jest nie tylko globalna , ale także śmiertelna i trwała, uniemożliwiająca odbudowę, a tym samym wpływająca zarówno na obecne, jak i na wszystkie przyszłe pokolenia.

Ryzyko niewymierania

Podczas gdy wyginięcie jest najbardziej oczywistym sposobem zniszczenia długoterminowego potencjału ludzkości, istnieją inne, w tym nieodwracalny upadek i nieodwracalna dystopia . Katastrofa na tyle poważna, że spowodowała trwały, nieodwracalny upadek cywilizacji ludzkiej, stanowiłaby katastrofę egzystencjalną, nawet gdyby nie groziła jej wyginięcie. Podobnie, gdyby ludzkość znalazła się pod reżimem totalitarnym i nie było szans na odrodzenie, to taka dystopia byłaby również egzystencjalną katastrofą. Bryana Caplana pisze, że „być może wieczność totalitaryzmu byłaby gorsza niż wyginięcie”. ( Powieść George'a Orwella Rok 1984 sugeruje przykład). Scenariusz dystopijny ma kluczowe cechy wyginięcia i nieodwracalnego upadku cywilizacji - przed katastrofą ludzkość miała do wyboru szeroki wachlarz świetlanych przyszłości; po katastrofie ludzkość zostaje na zawsze zamknięta w strasznym stanie.

Potencjalne źródła ryzyka

Potencjalne globalne zagrożenia katastroficzne są tradycyjnie klasyfikowane jako zagrożenia antropogeniczne lub nieantropogeniczne. Przykłady zagrożeń nieantropogenicznych to uderzenie asteroidy , erupcja superwulkanu , śmiercionośny rozbłysk promieniowania gamma , burza geomagnetyczna niszcząca sprzęt elektroniczny, naturalna długoterminowa zmiana klimatu , wrogie życie pozaziemskie lub przewidywalna przemiana Słońca w czerwonego olbrzyma gwiazda otaczająca Ziemię.

Zagrożenia antropogeniczne to zagrożenia powodowane przez ludzi i obejmują zagrożenia związane z technologią, zarządzaniem i zmianami klimatycznymi. Zagrożenia technologiczne obejmują tworzenie sztucznej inteligencji niedostosowanej do ludzkich celów, biotechnologię i nanotechnologię . Niewystarczające lub złośliwe globalne zarządzanie stwarza zagrożenia w sferze społecznej i politycznej, takie jak globalna wojna i nuklearny holokaust , bioterroryzm wykorzystujący genetycznie zmodyfikowane organizmy , cyberterroryzm niszczący infrastruktura krytyczna , taka jak sieć elektryczna , lub niepowodzenie w zarządzaniu pandemią naturalną lub sztuczną . Globalne zagrożenia katastroficzne w dziedzinie zarządzania systemem ziemskim obejmują globalne ocieplenie , degradację środowiska , wymieranie gatunków , głód w wyniku niesprawiedliwej dystrybucji zasobów, przeludnienie , nieurodzaj i niezrównoważone rolnictwo .

Wyzwania metodologiczne

Badania nad naturą i łagodzeniem globalnych zagrożeń katastroficznych i zagrożeń egzystencjalnych podlegają wyjątkowemu zestawowi wyzwań, w wyniku czego niełatwo poddają się zwykłym standardom rygoru naukowego. Na przykład eksperymentalne badanie tych zagrożeń nie jest ani wykonalne, ani etyczne. Carla Sagana wyraził to w odniesieniu do wojny nuklearnej: „Zrozumienie długoterminowych konsekwencji wojny nuklearnej nie jest problemem, który można zweryfikować eksperymentalnie”. Co więcej, wiele zagrożeń związanych z katastrofami zmienia się szybko wraz z postępem technologicznym i zmianami warunków otoczenia, takich jak warunki geopolityczne. Kolejnym wyzwaniem jest ogólna trudność w dokładnym przewidywaniu przyszłości w długich ramach czasowych, zwłaszcza w przypadku zagrożeń antropogenicznych, które zależą od złożonych ludzkich systemów politycznych, gospodarczych i społecznych. Oprócz znanych i namacalnych zagrożeń mogą wystąpić nieprzewidywalne czarnego łabędzia , co stanowi dodatkowy problem metodologiczny.

Brak historycznego precedensu

Ludzkość nigdy nie doświadczyła katastrofy egzystencjalnej, a gdyby do niej doszło, byłaby to z konieczności bezprecedensowa. Dlatego zagrożenia egzystencjalne stanowią wyjątkowe wyzwanie dla przewidywania, nawet większe niż inne zdarzenia długoterminowe, ze względu na efekty selekcji obserwacji . W przeciwieństwie do większości wydarzeń, niepowodzenie całkowitego wyginięcia w przeszłości nie jest dowodem na prawdopodobieństwo ich wystąpienia w przyszłości, ponieważ każdy świat, który doświadczył takiego wyginięcia, nie ma obserwatorów, więc niezależnie od ich częstotliwości żadna cywilizacja nie obserwuje egzystencjalnych zagrożeń w swojej historii. Te antropiczne problemów można częściowo uniknąć, przyglądając się dowodom, które nie mają takiego efektu selekcji, takim jak kratery uderzeniowe asteroid na Księżycu, lub bezpośrednio oceniając prawdopodobny wpływ nowej technologii.

Aby zrozumieć dynamikę bezprecedensowego, nieodwracalnego globalnego upadku cywilizacyjnego (rodzaj ryzyka egzystencjalnego), pouczające może być zbadanie różnych lokalnych upadków cywilizacyjnych , które miały miejsce w całej historii ludzkości. Na przykład cywilizacje takie jak Cesarstwo Rzymskie zakończyły się utratą scentralizowanego zarządzania i poważną utratą infrastruktury i zaawansowanej technologii w całej cywilizacji. Jednak te przykłady pokazują, że społeczeństwa wydają się być dość odporne na katastrofy; na przykład średniowieczna Europa przetrwała Czarną Śmierć bez cierpień przypominających a upadek cywilizacji pomimo utraty od 25 do 50 procent ludności.

Zachęty i koordynacja

Istnieją przyczyny ekonomiczne, które mogą wyjaśnić, dlaczego tak mało wysiłku wkłada się w redukcję ryzyka egzystencjalnego. Jest to globalne dobro publiczne , więc należy spodziewać się niedostatecznej podaży rynków. Nawet jeśli duży naród zainwestuje w środki ograniczające ryzyko, odniesie z tego tylko niewielki ułamek korzyści. Co więcej, redukcja ryzyka egzystencjalnego jest międzypokoleniowym globalnym dobrem publicznym, ponieważ większość korzyści z redukcji ryzyka egzystencjalnego odniosłaby większość przyszłych pokoleń i chociaż ci przyszli ludzie być może byliby skłonni zapłacić znaczne sumy za redukcję ryzyka egzystencjalnego, żaden mechanizm dla takiej transakcji istnieje.

Błędy poznawcze

Liczne błędy poznawcze mogą wpływać na ludzką ocenę znaczenia zagrożeń egzystencjalnych, w tym niewrażliwość na zakres , dyskontowanie hiperboliczne , heurystyka dostępności , błąd koniunkcji , heurystyka afektu i efekt nadmiernej pewności siebie .

Niewrażliwość na zakres wpływa na to, jak źli ludzie postrzegają wyginięcie rasy ludzkiej. Na przykład, kiedy ludzie są zmotywowani do ofiarowania pieniędzy na cele altruistyczne, ilość, którą są skłonni przekazać, nie rośnie liniowo wraz ze skalą problemu: ludzie są mniej więcej tak samo chętni do zapobieżenia śmierci 200 000 lub 2000 ptaków. Podobnie, ludzie często bardziej przejmują się zagrożeniami dla jednostek niż dla większych grup.

Eliezer Yudkowsky teoretyzuje, że zaniedbanie zakresu odgrywa rolę w społecznym postrzeganiu zagrożeń egzystencjalnych:

Znacznie większe liczby, takie jak 500 milionów zgonów, a zwłaszcza jakościowo różne scenariusze, takie jak wyginięcie całego gatunku ludzkiego, wydają się uruchamiać inny sposób myślenia… Ludzie, którzy nigdy nie marzyliby o skrzywdzeniu dziecka, słyszą o ryzyku egzystencjalnym, i powiedzieć: „Cóż, może gatunek ludzki tak naprawdę nie zasługuje na przetrwanie”.

Wszystkie wcześniejsze prognozy wyginięcia ludzkości okazały się fałszywe. Niektórym sprawia to, że przyszłe ostrzeżenia wydają się mniej wiarygodne. Nick Bostrom argumentuje, że brak wymierania ludzi w przeszłości jest słabym dowodem na to, że w przyszłości nie będzie wymierania ludzi, z powodu uprzedzeń ocalałych i innych skutków antropicznych .

Socjobiolog EO Wilson argumentował, że: „Przyczyną tej krótkowzrocznej mgły, twierdzą biolodzy ewolucyjni, jest to, że była ona rzeczywiście korzystna przez wszystkie, z wyjątkiem kilku ostatnich tysiącleci z dwóch milionów lat istnienia rodzaju Homo… Premię położono na zwrócenie szczególnej uwagi na najbliższą przyszłość i wczesną reprodukcję i niewiele więcej. Katastrofy o skali, które zdarzają się tylko raz na kilka stuleci, zostały zapomniane lub przekształcone w mit ”.

Proponowane łagodzenie

Obrona wielowarstwowa

Dogłębna obrona to przydatne ramy do kategoryzowania środków ograniczania ryzyka na trzy poziomy obrony:

- Zapobieganie : Przede wszystkim zmniejszanie prawdopodobieństwa wystąpienia katastrofy. Przykład: Środki zapobiegające wybuchom nowych wysoce zakaźnych chorób.

- Odpowiedź : Zapobieganie skalowaniu katastrofy do poziomu globalnego. Przykład: Środki zapobiegające eskalacji wymiany nuklearnej na małą skalę w wojnę nuklearną na wielką skalę.

- Resilience : Zwiększanie odporności ludzkości (przed wyginięciem) w obliczu globalnych katastrof. Przykład: Środki mające na celu zwiększenie bezpieczeństwa żywnościowego podczas nuklearnej zimy.

Wyginięcie człowieka jest najbardziej prawdopodobne, gdy wszystkie trzy mechanizmy obronne są słabe, to znaczy „z powodu ryzyka, któremu prawdopodobnie nie zapobiegniemy, na które nie uda się zareagować i na które nie będziemy odporni”.

Bezprecedensowy charakter zagrożeń egzystencjalnych stanowi szczególne wyzwanie przy projektowaniu środków ograniczających ryzyko, ponieważ ludzkość nie będzie w stanie wyciągnąć wniosków z dotychczasowych wydarzeń.

Finansowanie

Niektórzy badacze twierdzą, że zarówno badania, jak i inne inicjatywy związane z ryzykiem egzystencjalnym są niedofinansowane. Nick Bostrom twierdzi, że przeprowadzono więcej badań na temat Star Treka , snowboardu lub chrząszczy gnojowych niż na temat zagrożeń egzystencjalnych. Porównania Bostroma zostały skrytykowane jako „aroganckie”. Od 2020 r. Konwencji o zakazie broni biologicznej dysponowała rocznym budżetem w wysokości 1,4 mln USD.

Planowanie przetrwania

Niektórzy uczeni proponują utworzenie na Ziemi jednej lub więcej samowystarczalnych, odległych, zamieszkałych na stałe osad, stworzonych specjalnie w celu przetrwania globalnej katastrofy. Ekonomista Robin Hanson twierdzi, że schronienie, w którym na stałe zamieszkałoby zaledwie 100 osób, znacznie zwiększyłoby szanse przetrwania ludzi podczas szeregu globalnych katastrof.

Przechowywanie żywności zostało zaproponowane na całym świecie, ale koszt pieniężny byłby wysoki. Co więcej, prawdopodobnie przyczyniłoby się to do obecnych milionów zgonów rocznie z powodu niedożywienia . W 2022 roku zespół kierowany przez Davida Denkenbergera porównał opłacalność elastycznej żywności z bezpieczeństwem sztucznej inteligencji ogólnej (AGI) i stwierdził „~ 98-99% pewności” dla wyższego marginalnego wpływu pracy nad sprężystą żywnością. Niektórzy survivalowcy oferują rekolekcje przetrwania z wieloletnimi zapasami żywności.

Svalbard Global Seed Vault jest zakopany 400 stóp (120 m) wewnątrz góry na wyspie w Arktyce . Został zaprojektowany, aby pomieścić 2,5 miliarda nasion z ponad 100 krajów jako środek ostrożności w celu zachowania światowych upraw. Otaczająca skała ma temperaturę -6 ° C (21 ° F) (stan na 2015 r.), Ale sklepienie jest utrzymywane w temperaturze -18 ° C (0 ° F) przez lodówki zasilane lokalnym węglem.

Mówiąc bardziej spekulatywnie, jeśli społeczeństwo będzie nadal funkcjonować, a biosfera nadal będzie nadawała się do zamieszkania, zapotrzebowanie kaloryczne obecnej populacji ludzkiej może teoretycznie zostać zaspokojone podczas przedłużonej nieobecności światła słonecznego, przy odpowiednim planowaniu z wyprzedzeniem. Domniemane rozwiązania obejmują uprawę grzybów na martwej biomasie roślinnej pozostałej po katastrofie, przekształcanie celulozy w cukier lub dostarczanie gazu ziemnego bakteriom trawiącym metan.

Globalne zagrożenia katastroficzne i globalne zarządzanie

Niewystarczające zarządzanie globalne stwarza ryzyko w sferze społecznej i politycznej, ale mechanizmy zarządzania rozwijają się wolniej niż zmiany technologiczne i społeczne. Istnieją obawy ze strony rządów, sektora prywatnego, a także ogółu społeczeństwa, co do braku mechanizmów zarządzania umożliwiających skuteczne radzenie sobie z ryzykiem, negocjowanie i rozstrzyganie między różnymi i sprzecznymi interesami. Jest to dodatkowo podkreślone przez zrozumienie wzajemnych powiązań globalnych ryzyk systemowych. W przypadku braku lub przewidywania globalnego zarządzania, rządy krajowe mogą działać indywidualnie, aby lepiej zrozumieć, złagodzić i przygotować się na globalne katastrofy.

Klimatyczne plany awaryjne

W 2018 roku Klub Rzymski wezwał do intensywniejszych działań w zakresie zmian klimatu i opublikował swój klimatyczny plan awaryjny, w którym proponuje dziesięć punktów działań mających na celu ograniczenie wzrostu średniej temperatury na świecie do 1,5 stopnia Celsjusza. Ponadto w 2019 roku Klub opublikował bardziej kompleksowy Planetarny Plan Awaryjny.

Istnieją dowody sugerujące, że zbiorowe angażowanie się w doświadczenia emocjonalne, które pojawiają się podczas rozważania podatności gatunku ludzkiego na zmiany klimatu, pozwala na adaptację tych doświadczeń. Gdy kolektywne angażowanie się i przetwarzanie doświadczeń emocjonalnych jest pomocne, może to prowadzić do wzrostu odporności, elastyczności psychologicznej, tolerancji doświadczeń emocjonalnych i zaangażowania społeczności.

Kolonizacja kosmosu

Kolonizacja kosmosu jest proponowaną alternatywą mającą na celu zwiększenie szans na przetrwanie scenariusza wyginięcia. Rozwiązania tego zakresu mogą wymagać inżynierii w megaskali .

Astrofizyk Stephen Hawking opowiadał się za kolonizacją innych planet w Układzie Słonecznym, gdy technologia wystarczająco się rozwinie, aby zwiększyć szanse przetrwania ludzi po wydarzeniach na całej planecie, takich jak globalna wojna termojądrowa.

Miliarder Elon Musk pisze, że ludzkość musi stać się gatunkiem wieloplanetarnym, aby uniknąć wyginięcia. Musk wykorzystuje swoją firmę SpaceX do opracowania technologii, która, jak ma nadzieję, zostanie wykorzystana w kolonizacji Marsa .

Poruszanie Ziemi

Za kilka miliardów lat Słońce rozszerzy się do postaci czerwonego olbrzyma , pochłaniając Ziemię. Można tego uniknąć, przesuwając Ziemię dalej od Słońca, utrzymując temperaturę w przybliżeniu na stałym poziomie. Można to osiągnąć, modyfikując orbity komet i asteroid, tak aby przelatywały blisko Ziemi w taki sposób, aby dodać energii do orbity Ziemi. Ponieważ ekspansja Słońca jest powolna, wystarczyłoby mniej więcej jedno takie spotkanie na 6000 lat. [ potrzebne źródło ]

Sceptycy i przeciwnicy

Psycholog Steven Pinker nazwał ryzyko egzystencjalne „bezużyteczną kategorią”, która może odwracać uwagę od rzeczywistych zagrożeń, takich jak zmiana klimatu i wojna nuklearna.

Organizacje

The Bulletin of the Atomic Scientists (założony w 1945 r.) jest jedną z najstarszych globalnych organizacji zajmujących się ryzykiem, założoną po tym, jak opinia publiczna została zaalarmowana potencjałem wojny atomowej w następstwie II wojny światowej. Bada zagrożenia związane z wojną nuklearną i energią oraz słynie z utrzymywania Zegara Zagłady ustanowionego w 1947 r. Foresight Institute (założony w 1986 r.) bada zagrożenia związane z nanotechnologią i jej korzyści. Była to jedna z pierwszych organizacji, która zbadała niezamierzone konsekwencje nieszkodliwej technologii, która zbłądziła na skalę globalną. Została założona przez K. Erica Drexlera który postulował „ szarą mazię ”.

Począwszy od roku 2000, rosnąca liczba naukowców, filozofów i miliarderów technologicznych tworzyła organizacje zajmujące się badaniem globalnych zagrożeń zarówno w środowisku akademickim, jak i poza nim.

Do niezależnych organizacji pozarządowych (NGO) należy Machine Intelligence Research Institute (założony w 2000 r.), którego celem jest zmniejszenie ryzyka katastrofy spowodowanej przez sztuczną inteligencję, z darczyńcami, w tym Peterem Thielem i Jedem McCalebem . Nuclear Threat Initiative (założona w 2001 r.) ma na celu zmniejszenie globalnych zagrożeń związanych z zagrożeniami nuklearnymi, biologicznymi i chemicznymi oraz powstrzymanie szkód po zdarzeniu. Utrzymuje indeks bezpieczeństwa materiałów jądrowych. Lifeboat Foundation (założona w 2009 r.) finansuje badania nad zapobieganiem katastrofie technologicznej. Większość pieniędzy na badania finansuje projekty na uniwersytetach. Globalny Instytut Ryzyka Katastroficznego (założony w 2011 r.) to bezpartyjny think tank non-profit z siedzibą w USA, założony przez Setha Bauma i Tony'ego Barretta. GCRI prowadzi badania i prace polityczne dotyczące różnych zagrożeń, w tym sztucznej inteligencji, wojny nuklearnej, zmian klimatycznych i uderzeń asteroid. Fundacja Global Challenges Foundation (założona w 2012 r.) z siedzibą w Sztokholmie, założona przez Laszlo Szombatfalvy'ego , publikuje coroczny raport na temat stanu globalnych zagrożeń. Instytut Przyszłości Życia (zał. 2014) działa na rzecz ograniczenia ekstremalnych zagrożeń na dużą skalę związanych z technologiami transformacyjnymi, a także steruje rozwojem i wykorzystaniem tych technologii z korzyścią dla każdego życia, poprzez udzielanie dotacji, rzecznictwo polityczne w Stanach Zjednoczonych, Unii Europejskiej i Organizacji Narodów Zjednoczonych, i zasięg edukacyjny. Elon Musk , Vitalik Buterin i Jaan Tallinn to jedni z największych darczyńców. Center on Long-Term Risk (zał. 2016), dawniej znany jako Foundational Research Institute, to brytyjska organizacja skupiająca się na zmniejszaniu ryzyka astronomicznego cierpienia ( s-ryzyka ) związanego z pojawiającymi się technologiami.

Do organizacji uniwersyteckich należy Instytut Przyszłości Ludzkości (założony w 2005 r.), który bada kwestie długoterminowej przyszłości ludzkości, w szczególności ryzyka egzystencjalnego. Została założona przez Nicka Bostroma i ma siedzibę na Uniwersytecie Oksfordzkim. Center for the Study of Existential Risk (założone w 2012 r.) to organizacja z siedzibą na Uniwersytecie Cambridge, która bada cztery główne zagrożenia technologiczne: sztuczną inteligencję, biotechnologię, globalne ocieplenie i działania wojenne. Wszystkie są ryzykiem spowodowanym przez człowieka, jak Huw Price wyjaśnił agencji prasowej AFP: „Wydaje się rozsądną prognozą, że kiedyś w tym lub następnym stuleciu inteligencja ucieknie od ograniczeń biologii”. Dodał, że kiedy to się stanie, „nie jesteśmy już najmądrzejszymi rzeczami w okolicy” i ryzykujemy, że znajdziemy się na łasce „maszyn, które nie są złośliwe, ale maszyn, których interesy nas nie obejmują”. Stephen Hawking był doradcą aktorskim. Sojusz Milenijny na rzecz Ludzkości i Biosfery to organizacja z siedzibą na Uniwersytecie Stanforda, skupiająca się na wielu zagadnieniach związanych z globalną katastrofą, zrzeszająca przedstawicieli środowisk akademickich zajmujących się naukami humanistycznymi. Założył ją m.in. Paul Ehrlich . Uniwersytet Stanforda ma również Centrum Bezpieczeństwa i Współpracy Międzynarodowej, które koncentruje się na współpracy politycznej w celu zmniejszenia globalnego ryzyka katastrof. Centrum Bezpieczeństwa i Nowych Technologii została założona w styczniu 2019 roku w Walsh School of Foreign Service w Georgetown i będzie koncentrować się na badaniach politycznych nad nowymi technologiami, z początkowym naciskiem na sztuczną inteligencję. Zgodnie z sugestią Open Philanthropy otrzymali grant w wysokości 55 mln USD od Good Ventures .

Inne grupy zajmujące się oceną ryzyka mają siedzibę w organizacjach rządowych lub są ich częścią. Światowa Organizacja Zdrowia (WHO) obejmuje oddział o nazwie Global Alert and Response (GAR), który monitoruje i reaguje na globalny kryzys epidemiczny. GAR pomaga państwom członkowskim w szkoleniu i koordynacji reagowania na epidemie. Agencja Stanów Zjednoczonych ds. Rozwoju Międzynarodowego (USAID) ma swój program Emerging Pandemic Threats Program, którego celem jest zapobieganie i powstrzymywanie naturalnie generowanych pandemii u ich źródła. Narodowe Laboratorium Lawrence'a Livermore'a ma oddział o nazwie Global Security Principal Directorate, który prowadzi badania w imieniu rządu w kwestiach takich jak bezpieczeństwo biologiczne i zwalczanie terroryzmu.

Zobacz też

- Fikcja apokaliptyczna i postapokaliptyczna

- Wyścig zbrojeń sztucznej inteligencji

- Hipoteza kataklizmowego przesunięcia biegunów

- Odporność społeczności

- Kult zagłady

- Eschatologia

- Ekstremalne ryzyko

- Stan nieudany

- Paradoks Fermiego

- Foresight (psychologia)

- Przyszłość Ziemi

- Przyszłość Układu Słonecznego

- Geoinżynieria

- Globalny raport o zagrożeniach

- Świetny filtr

- Wymieranie holocenu

- Zdarzenie uderzeniowe

- Lista problemów globalnych

- Rozprzestrzenianie broni jądrowej

- Problem z kontekstem zewnętrznym

- Granice planetarne

- Rzadkie zdarzenia

- Szóste wymieranie: nienaturalna historia

- Degeneracja społeczna

- Upadek społeczny

- Transformacja społeczna

- Ewolucja spekulacyjna

- Surwializm

- Ryzyko ogona

- Przepaść: ryzyko egzystencjalne i przyszłość ludzkości

- Kalendarium dalekiej przyszłości

- Ostateczny los wszechświata

- Ostrzeżenie światowych naukowców dla ludzkości

Dalsza lektura

- Avin, Shahar; Wintle, Bonnie C.; Weitzdörfer, Julius; Héigeartaigh, Seán S.; Sutherland, William J.; Rees, Martin J. (2018). „Klasyfikowanie globalnych zagrożeń katastroficznych” . Kontrakty terminowe . 102 : 20–26. doi : 10.1016/j.futures.2018.02.001 .

- Corey S. Powell (2000). „Dwadzieścia sposobów, w jakie świat może się nagle skończyć” , Discover Magazine

- Derrick Jensen (2006) Koniec gry ( ISBN 1-58322-730-X ).

- Łąki Donelli (1972). Granice wzrostu ( ISBN 0-87663-165-0 ).

- Edwarda O. Wilsona (2003). Przyszłość życia . ISBN 0-679-76811-4

- Holt, Jim , „The Power of Catastrophic Thinking” (recenzja Toby'ego Orda , The Precipice: Existential Risk and the Future of Humanity , Hachette, 2020, 468 s.), The New York Review of Books , tom. LXVIII, nr. 3 (25.02.2021), s. 26–29. Jim Holt pisze (s. 28): „Niezależnie od tego, czy szukasz lekarstwa na raka, czy robisz karierę naukową lub artystyczną, czy też angażujesz się w tworzenie bardziej sprawiedliwych instytucji, zagrożenie dla przyszłości ludzkości jest również zagrożeniem dla znaczenia tego, co robisz”.

- Huesemann, Michael H. i Joyce A. Huesemann (2011). Technofix: Why Technology Won't Save Us or the Environment , rozdział 6, „Zrównoważony rozwój lub upadek”, New Society Publishers , Gabriola Island, British Columbia, Canada, 464 strony ( ISBN 0865717044 ).

- Jared Diamond , Upadek: Jak społeczeństwa decydują się na porażkę lub sukces , Penguin Books , 2005 i 2011 ( ISBN 9780241958681 ).

- Jean-Francois Rischard (2003). W samo południe 20 globalnych problemów, 20 lat na ich rozwiązanie . ISBN 0-465-07010-8

- Joel Garreau , Radykalna ewolucja , 2005 ( ISBN 978-0385509657 ).

- Johna A. Leslie (1996). Koniec świata ( ISBN 0-415-14043-9 ).

- Josepha Taintera (1990). Upadek złożonych społeczeństw , Cambridge University Press , Cambridge, Wielka Brytania ( ISBN 9780521386739 ).

- Martina Reesa (2004). Nasza ostatnia godzina: ostrzeżenie naukowca: jak terror, błąd i katastrofa ekologiczna zagrażają przyszłości ludzkości w tym stuleciu - na Ziemi i poza nią . ISBN 0-465-06863-4

- Roger-Maurice Bonnet i Lodewijk Woltjer , Przetrwanie 1000 stuleci Czy możemy to zrobić? (2008), Springer-Praxis Books.

- Toby'ego Orda (2020). Przepaść – ryzyko egzystencjalne i przyszłość ludzkości . Wydawnictwo Bloomsbury. ISBN9781526600219 _

Linki zewnętrzne

- „Czy jesteśmy na drodze do upadku cywilizacji?” . BBC . 19 lutego 2019 r.

- MacAskill, William (5 sierpnia 2022). „Sprawa długoterminowości” . New York Timesa .

- „Co za droga” z The Guardian . Dziesięciu naukowców wymienia największe zagrożenia dla Ziemi i ocenia szanse ich wystąpienia. 14 kwietnia 2005.

- Ludzkość zagrożona przez idealną burzę kryzysów – opracowanie . Strażnik . 6 lutego 2020 r.

- Roczne raporty na temat globalnego ryzyka autorstwa Global Challenges Foundation

- Skoncentruj się na ryzyku długoterminowym

- Globalna Polityka Ryzyka Katastroficznego

- Stephen Petranek: 10 sposobów na koniec świata , przemówienie TED